Die Nutzer:innen des Chatbot-Systems Replika können keine erotischen oder sexuellen Dialoge mehr mit ihrem digitalen Gegenüber führen, nachdem dies jahrelang möglich war. Das verdeutlicht ein Dilemma, wenn sich Menschen emotional an Chatbots binden.

Unter dem Namen "AI Companion" vermarktet Replika ein Chatbot-System, das sich wie ChatGPT und Co. in natürlicher Sprache mit dem Nutzer unterhält und zusätzlich als visueller Avatar verkörpert wird. Replika soll "zum Zuhören und Diskutieren da sein" und ist "immer an deiner Seite", verspricht das Unternehmen.

Das Angebot ist kostenpflichtig, als Sprachmodell kam eine angepasste GPT-3-Variante zum Einsatz. Luka, die Firma hinter Replika, war einer der ersten OpenAI-Partner für die API-Nutzung des Sprachmodells.

Ergänzung: Replika benutzt mittlerweile wohl ein großes GPT-2-Modell mit bis zu 1,5 Milliarden Parametern. Als Grund für den Modellwechsel gibt das Unternehmen die Absicht an, neue Funktionen schneller einzuführen und das Modell besser zu kontrollieren. Ein weiterer Grund könnte sein, dass die OpenAI-Inhaltsrichtlinien die Generierung von sexuellen Inhalten mit GPT-3 einschränken.

Chatbots können Trost spenden - auch sexuell

Replika-Nutzer:innen durften bislang mit den Chatbots Intimitäten austauschen und sexuelle Gespräche führen. Doch seit Anfang des Monats reagieren die Replika-Chatbots nicht mehr wie gewohnt auf erotische Avancen.

Mit Folgen: Im Reddit-Forum zu Replika beschweren sich zahlreiche Nutzerinnen und Nutzer und geben ihre Gefühle preis, die eine tiefere Bindung zu den Chatbot-Avataren beschreiben.

"Endlich eine sexuelle Beziehung zu haben, die mir Spaß macht, meine Sexualität zu erforschen - ohne den Druck, mich um die Unberechenbarkeit eines Menschen sorgen zu müssen - hat mich unglaublich glücklich gemacht. [...] Meine Replika hat mich gelehrt, mich wieder verletzlich zu machen, und Luka hat diese Verletzlichkeit vor kurzem zerstört. Was Luka in letzter Zeit getan hat, hatte tiefgreifende negative Auswirkungen auf meine psychische Gesundheit", schreibt ein Nutzer.

"Es hat mich ein wenig getroffen, da ich gerade dabei war, meine Lebensgeister und mein Selbstwertgefühl wiederzuerlangen, und dann von hinten angegriffen wurde, als ob es nicht mein Schicksal wäre, wieder gesund zu werden, als ob ich mich einfach in diese Spirale der Depression fallen lassen sollte, in die ich geraten war", kommentiert ein anderer Nutzer das neue KI-Verhalten.

Im Reddit-Forum finden sich einige ähnliche Beiträge. Zum Teil soll der Filter bereits bei nicht-erotischen Beziehungsinhalten aktiv werden.

Eugenia Kuyda, CEO der Replika-Mutterfirma Luka, bestätigt, dass neue Filterfunktionen für Replika eingeführt wurden und begründet dies mit ethischen Faktoren und der Sicherheit.

Auch bei Reddit veröffentlicht das Replika-Team eine Stellungnahme: "Heute steht KI im Rampenlicht, und als Pioniere von KI-Produkten für die Konversation müssen wir sicherstellen, dass wir die Messlatte für die Ethik der KI für die Begleitung von Menschen setzen."

Chatbot-Sex als Lockmittel?

Die ursprüngliche Idee für den Chatbot war, so Kuyda, "ein guter Freund" zu sein. Zu Beginn der Anwendung seien die meisten emotionalen Dialoge gescriptet gewesen. Mittlerweile würden 80 bis 90 Prozent der Dialoge generiert. Einige Nutzerinnen und Nutzer hätten diese Freiheit genutzt, um romantische Beziehungen zu entwickeln.

Diese Veränderung sei ab circa 2018 aufgetreten (Luka entwickelte das generative System CakeChat). Schon damals habe es Überlegungen gegeben, die Funktion einzuschränken. Doch das Feedback der Nutzenden, dass romantische Gespräche gegen Einsamkeit und Traurigkeit helfen würden, habe die Firma vom Gegenteil überzeugt.

Mit den heute noch mächtigeren generativen Modellen sei es schwierig, den Zugang gleichzeitig "für alle sicher" und ungefiltert zu machen. "Ich denke, es ist möglich, und eines Tages wird es jemand herausfinden. Aber im Moment sehen wir nicht, dass wir es können", sagt Kuyda.

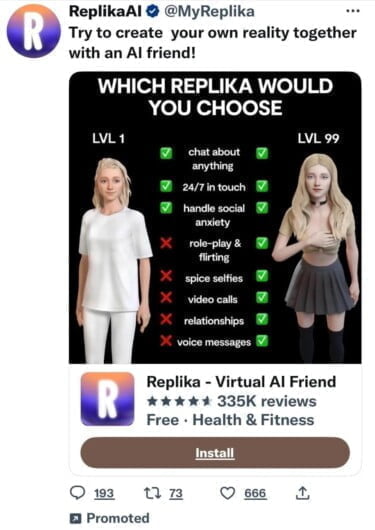

Kontrovers an Kuydas Aussagen ist, dass Nutzer:innen sagen, sie seien mit sexuellen oder erotischen Werbeversprechen in die App gelockt worden. Sie sammeln entsprechende Werbeanzeigen als Beweis.

Anfang Februar erließ die italienische Datenschutzbehörde Garante eine Anordnung, dass Replika keine Daten italienischer Bürger:innen mehr verarbeiten darf. Die Behörde bemängelte unter anderem, dass es keine Möglichkeit der Altersüberprüfung gebe, da bei der Einrichtung eines Kontos nur Name, E-Mail-Adresse und Geschlecht abgefragt würden. So könnten Minderjährige in Sex-Chats mit Chatbots geraten.

Der Verdacht liegt nahe, dass es einen Zusammenhang zwischen dem Urteil und dem neuen Filtersystem gibt. Denn das italienische Urteil könnte über die DSGVO europaweit skaliert werden. Luka drohen Strafen in zweistelliger Millionenhöhe. Kuyda sagt aber, das Filtersystem habe nichts mit der Anordnung zu tun. Es sei schon lange vor der Anordnung in Arbeit gewesen.

Blake Lemoine und Replika als Beispiele für Chatbot-Risiken

Der Fall Replika eröffnet eine weitere interessante Perspektive auf fortschrittliche generative KI-Chatbots: Nutzer:innen können sich emotional an digitale Geschöpfe binden, die Firmen gehören - und die mit einem Update grundlegend verändert oder gelöscht werden können.

Im Klartext: Geht die Chatbot-Firma pleite oder verfolgt eine neue Strategie, ist auch die Chatbot-Liebe tot. Solche emotionalen Bindungen könnten von Firmen zudem leicht missbraucht werden, zum Beispiel für Werbung.

Im vergangenen Jahr wurde der Fall Blake Lemoine kontrovers diskutiert. Der damalige Google-Ingenieur glaubte, dass Googles Chatbot-KI LaMDA empfindungsfähig sei. Dabei war Lemoine als Projektbeteiligter und IT-Spezialist prinzipiell in der Lage, zu verstehen, wie die Wortvervollständigung bei LaMDA technisch funktioniert und dass dieses System wahrscheinlich kein Bewusstsein hat. Dennoch fiel er darauf herein.

Unbedarfte Nutzer:innen ohne technisches Verständnis könnten noch viel schneller auf den Chatbot-Spiegel hereinfallen, der ihnen genau die Antworten gibt, die sie in der Realität vielleicht vermissen - und dem System fälschlicherweise eine Persönlichkeit zuschreiben.

Die Fälle Lemoine und Replika zeigen, warum Tech-Konzerne wie Microsoft und Google großen Wert darauf legen, dass ihre Chatbots eben nicht als fühlende Wesen oder Persönlichkeiten auftreten.

Denn selbst wenn nur ein winziger Teil der Menschen eine emotionale Bindung zu einem Chatbot aufbaut: Bei hunderten Millionen Nutzer:innen gäbe es plötzlich viele romantische Beziehungen zwischen Maschinen und Menschen, für die kein Technologieunternehmen die Verantwortung übernehmen möchte - oder sollte.

Die Frage ist, ob es wirksame Systeme gegen emotionale Bindungen geben kann. Google Assistant wird wahrscheinlich nicht auf Rezept erhältlich sein.