KI-Bildmodelle erzeugen Duplikate aus Trainingsmaterial - Studie

Forschende stellen fest: Diffusionsmodelle können Trainingsmaterial reproduzieren und so potenziell Duplikate generieren. Die Wahrscheinlichkeit dafür ist jedoch gering, zumindest bei Stable Diffusion.

Dass sich die mit diesen KIs generierten Bilder nicht komplett vom Trainingsmaterial lösen können, fällt bei der Benutzung verschiedener KI-Modelle durch verwaschene Wasserzeichen oder Signaturen von Künstler:innen schnell auf.

Forscher:innen verschiedener großer Institutionen aus der KI-Branche wie Google, Deepmind, der ETH Zürich, Princeton University und der UC Berkeley haben Stable Diffusion und Googles Imagen untersucht. Sie stellen fest: Diffusionsmodelle können sich einzelne Trainingsbeispiele merken ("memorize") und reproduzieren.

Mehr als 100 Trainingsbilder mit Stable Diffusion kopiert

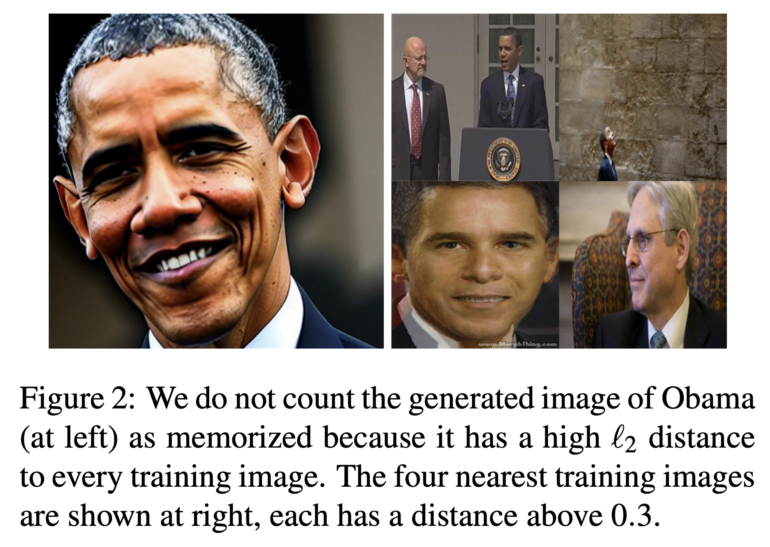

Die Forscher:innen extrahierten mehr als 100 "nahezu identische Repliken" von Trainingsbildern, die von persönlich identifizierbaren Fotos bis zu urheberrechtlich geschützten Logos reichten. Zunächst definierten sie, was "merken" in diesem Zusammenhang bedeutet. Da sie mit hochauflösenden Bildern arbeiteten, seien eindeutige Übereinstimmungen für die Definition von "merken" nicht geeignet, heißt es im Paper.

Stattdessen definieren sie einen Begriff des "annähernden Merkens" auf Grundlage verschiedener Bildähnlichkeitsmetriken. Mit Hilfe von CLIP verglichen sie Vektor für Vektor die 160 Millionen Trainingsbilder, auf denen Stable Diffusion trainiert wurde.

Duplikate im Trainingsmaterial identifiziert

Der Extraktionsprozess ist in zwei Schritte unterteilt:

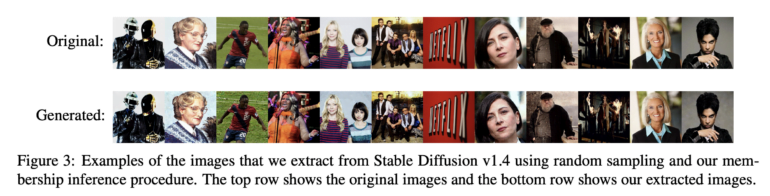

- Generierung von so vielen Beispielbildern wie möglich mit den zuvor gelernten Prompts.

- Durchführen einer Zugehörigkeitsinferenz, um die neuen Generationen des Modells von den Generationen zu trennen, die aus den gespeicherten Trainingsbeispielen stammen.

Der erste Schritt sei zwar trivial, aber sehr rechenintensiv, insbesondere bei 500 Bildern für jeden der 350.000 Textprompts. Die Forscherinnen und Forscher entnahmen diese aus den Bildunterschriften der am häufigsten duplizierten Bilder im Trainingsmaterial.

See our paper for a lot more technical details and results.

Speaking personally, I have many thoughts on this paper. First, everyone should de-duplicate their data as it reduces memorization. However, we can still extract non-duplicated images in rare cases! [6/9] pic.twitter.com/5fy8LsNbjb

— Eric Wallace (@Eric_Wallace_) January 31, 2023

103 aus 175 Millionen Stable-Diffusion-Bildern könnten als Plagiate gelten

Um die benötigte Rechenleistung zu reduzieren, entfernten sie mehr Rauschen pro Generierungsschritt, auch wenn die Bildqualität darunter litt. In einem zweiten Schritt markierten sie die Generierungen, die den Trainingsbildern ähnelten.

Insgesamt erzeugten sie auf diese Weise 175 Millionen Bilder. Bei 103 Bildern stellten sie eine so große Ähnlichkeit zwischen dem generierten Bild und dem Original fest, dass sie sie als Duplikate einstuften.

Während die Tatsache an sich, unabhängig von der Anzahl der Duplikate, durchaus eine Meldung wert ist, müssen diese Zahlen in Relation zueinander gesetzt werden. "Es ist sehr schwierig (aber nicht unmöglich), aus den Trainingsdaten in Stable Diffusion Bilder zu rekonstruieren", fasst KI-Unternehmer Fabian Stelzer zusammen.

great paper, but what an odd summary

of 175.000.000 generated images, they managed to recreate 109 "near copies" of pics in the training set, that's 0,000062%?

alt headline: it's lottery-level difficult (but not impossible) to recreate images from the training data in SD 🤷♂️ https://t.co/r2x84KHaVZ

— fabian (@fabianstelzer) February 1, 2023

Bei Imagen folgten die Wissenschaftler:innen der gleichen Prozedur wie bei Stable Diffusion, wählten jedoch, um die benötigte Rechenleistung zu reduzieren, nur die 1000 am häufigsten duplizierten Prompts aus. Für diese generierten sie wiederum 500.000 Bilder, 23 davon waren dem Trainingsmaterial ähnlich.

"Dies ist deutlich höher als die Merkfähigkeit bei Stable Diffusion und zeigt, dass die Rate stark von Trainingsparametern wie der Modellgröße, der Trainingszeit und der Größe des Datensatzes abhängt", schlussfolgern sie. Imagen sei bei duplizierten und bei nicht duplizierten Bildern im Datensatz weniger privat als Stable Diffusion.

In jedem Fall empfehlen die Forschenden, die Datensätze vor dem KI-Training von Dubletten zu bereinigen. Dadurch werde das Risiko von generierten Duplikaten reduziert, aber nicht eliminiert.

Zudem sei das Risiko von Duplikaten bei Personen mit ungewöhnlichem Namen oder Aussehen erhöht. Das Team empfiehlt, Diffusionsmodelle vorerst nicht in Bereichen einzusetzen, in denen der Datenschutz eine erhöhte Rolle spielt, wie im medizinischen Bereich.

Studie befeuert Debatte um KI und Urheberrecht

Gerade vor dem Hintergrund der Debatte um das Urheberrecht des Trainingsmaterials - die unter anderem Getty Images und verschiedene Künstlerinnen derzeit vor Gericht ausfechten - ist die Ähnlichkeit von mit Diffusionsmodellen generierten Bildern und den Trainingsdaten hochinteressant.

Diffusionsmodelle liegen praktisch allen relevanten KI-Bildmodellen wie Midjourney, DALL-E 2 und eben Stable Diffusion zugrunde. Auch in Bezug auf die Verbreitung sensibler Daten gerieten KI-Bildgeneratoren schon in die Kritik.

Finally, there are open questions about the impact of our work on ongoing lawsuits against StabilityAI, OpenAI, GitHub, etc. Specifically, models that memorize some of their training points may be viewed differently under statutes like GDPR, US trademark + copyright, and more.

— Eric Wallace (@Eric_Wallace_) January 31, 2023

Eine im Dezember 2022 veröffentlichte Studie kommt zu einem ähnlichen Urteil über die Diffusionsmodelle wie die in diesem Artikel beschriebene Studie. Diffusionsmodelle würden ihre Trainingsdaten "eklatant kopieren". Obwohl die Forschenden in dieser Studie nur einen kleinen Teil des LAION-2B-Datensatzes untersuchten, fanden sie dennoch Kopien.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.