Missbrauchsfälle von KI haben stark zugenommen

"Die Zahl der Vorfälle im Zusammenhang mit dem Missbrauch von KI steigt rapide an." Das ist eine der zentralen Aussagen, die im Artificial Intelligence Index Report 2023 zu lesen sind.

Das in diesem Jahr rund 400 Seiten starke Werk gilt als einer der vertrauenswürdigsten Berichte über den Status quo von Künstlicher Intelligenz und wurde nun zum sechsten Mal von der Stanford University veröffentlicht.

Kein einziges Mal im ersten Bericht von 2017, doch ganze 21 Mal im diesjährigen Report erwähnen die Autor:innen das Wort "Deepfake". Ein ganzes Kapitel widmen sie dem Thema "Technische KI-Ethik".

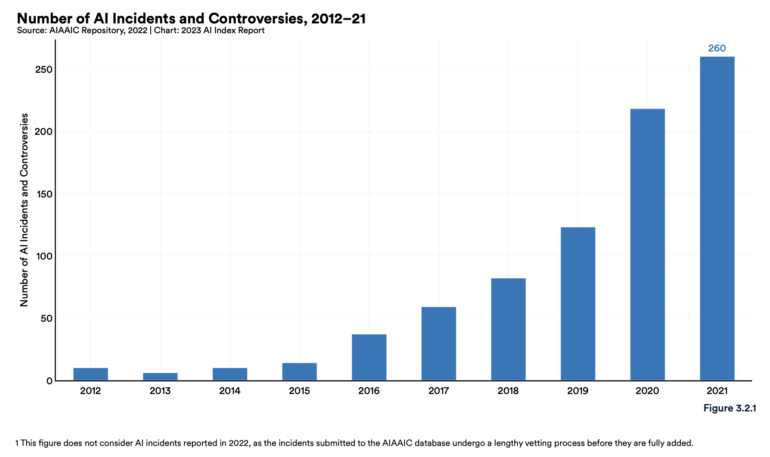

Der Anstieg der gemeldeten Vorfälle ist wahrscheinlich ein Beleg für die zunehmende Verflechtung von KI mit der realen Welt und ein wachsendes Bewusstsein für die Möglichkeiten des ethischen Missbrauchs von KI. Der dramatische Anstieg wirft auch eine wichtige Frage auf: In dem Maße, wie das Bewusstsein gewachsen ist, hat sich auch die Verfolgung von Vorfällen und Schäden verbessert - was darauf hindeutet, dass ältere Vorfälle möglicherweise nicht ausreichend gemeldet werden.

AI Index Report 2023

Und das ist kein Zufall: Laut der unabhängigen AIAAIC-Datenbank, die Vorfälle im Zusammenhang mit dem ethischen Missbrauch von KI verfolgt, sei die Anzahl der KI-Vorfälle zwischen 2012 und 2021 um das 26-fache gestiegen.

Finale Zahlen zu 2022 liegen noch nicht vor, da die Datenbankeinträge einem langwierigen Verifizierungsprozess unterzogen werden. Zudem sei aber von einer hohen Dunkelziffer in den ersten Jahren der Nachverfolgung auszugehen.

Ein im März 2022 veröffentlichtes Deepfake-Video, in dem vermeintlich der ukrainische Präsidenten Wolodymyr Selenskyj seine Truppen zur Aufgabe aufruft, nennen die Autor:innen als ein Beispiel mit einer besonders hohen Reichweite.

Weitere Vorfälle, die Ethik-Fragen aufwerfen

Aber auch abseits von Deepfakes hat der Einsatz von KI in der jüngeren Vergangenheit zu Diskussionen über den ethischen Umgang geführt. So gebe es Berichte, dass in US-Gefängnissen Telefongespräche mithilfe von KI überwacht worden seien. Dabei sei zudem aufgefallen, dass die Spracherkennung bei Schwarzen Personen weniger genaue Transkripte lieferte, obwohl ein Großteil der Häftlinge in den USA Schwarz ist.

Überwachung spielt nicht nur bei Strafgefangenen eine Rolle, und sie findet nicht nur im Verborgenen statt. Ganz offen geht etwa der IT-Riese Intel damit um, dass er für das Videokonferenztool Zoom eine Software entwickelt hat, die Emotionen wie “gelangweilt”, “abgelenkt” oder “verwirrt” aus den Gesichtern von Schüler:innen ablesen soll.

Schließlich taucht in dieser beunruhigenden Reihe auch Midjourney auf - stellvertretend für alle KI-Bildgeneratoren, einschließlich DALL-E 2 und Stable Diffusion. Die Systeme werfen laut dem Bericht ethische Fragen bezüglich Fairness, Bias, Copyright, Arbeitsplätzen und Datenschutz auf.

Unerwähnt bleibt allerdings die Fähigkeit, fotorealistische Bilder zu erzeugen, die zuletzt etwa in Bezug auf Papst Franziskus oder Donald Trump für Schlagzeilen gesorgt hat.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.