Nvidia stellt neuen KI-Beschleuniger H200 vor

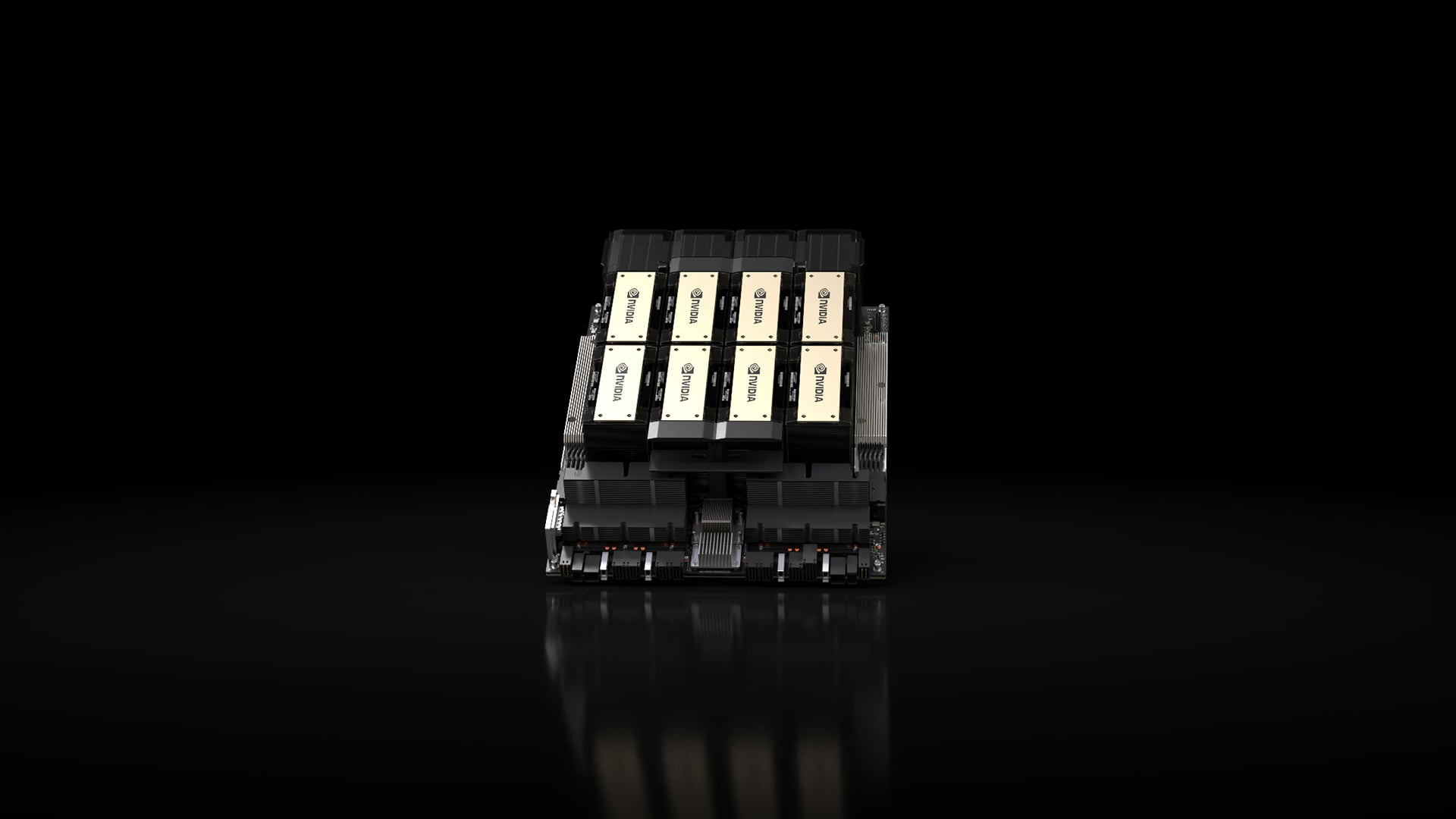

Im Rahmen der SC23 Supercomputing Show hat Nvidia seinen neuen KI-Beschleuniger H200 vorgestellt. Dieser soll dank schnellerem Speicher die Inferenz von KI-Modellen nahezu verdoppeln.

Nvidias H200 ist die erste GPU, die den schnellen HBM3e-Speicher und bietet Vergleich zum Vorgängermodell H100 141 Gigabyte HBM3e statt 90 Gigabyte HBM2e sowie eine Bandbreite von 4,8 Terabyte pro Sekunde statt 3,35. Im Vergleich zur A100 sind das etwa 2 bis 2,5-mal so hohe Werte.

Der schnellere Speicher und weitere Optimierungen sollen sich gegenüber der H100 vor allem in der Inferenz bemerkbar machen: Laut Nvidia läuft beispielsweise Metas Llama 2 in der 70-Milliarden-Parameter-Variante auf einer H200 fast doppelt so schnell. Auch für wissenschaftliche HPC-Anwendungen soll der Grafikprozessor besser geeignet sein. Das Unternehmen erwartet weitere Verbesserungen durch Software-Optimierungen.

Systeme und Cloud-Instanzen mit H200 werden voraussichtlich ab dem zweiten Quartal 2024 verfügbar sein, einschließlich HGX H200-Systemen. Die H200 kann in verschiedenen Rechenzentrumsumgebungen eingesetzt werden, darunter On-Premise-, Cloud-, Hybrid-Cloud- und Edge-Umgebungen.

Amazon Web Services, Google Cloud, Microsoft Azure und Oracle Cloud Infrastructure gehören zu den ersten Cloud Serviceprovidern, die ab nächstem Jahr H200-basierte Instanzen anbieten wollen.

Nvidias H200 kommt in GH200-Superchip mit 144 Gigabyte HBM3e

Laut Nvidia soll die H200-GPU auch in einer ab 2024 verfügbaren 144-Gigabyte-Variante des Grace-Hopper-Superchips GH200 erhältlich sein. Der GH200 verbindet Nvidias GPUs direkt mit Nvidias Grace CPUs.Im kürzlich veröffentlichten MLPerf-Benchmark in der Version 3.1 zeigte die aktuelle GH200-Variante mit geringerer Bandbreite und 96 Gigabyte HBM3-Speicher beim Training von KI-Modellen einen Geschwindigkeitsvorteil von knapp 17 Prozent gegenüber der H100.

Diese Variante soll ab 2024 von der größeren Variante mit HBM3e-Speicher abgelöst werden. Insgesamt sollen die GH200-Chips in mehr als 40 Supercomputern weltweit eingesetzt werden, darunter im Jülich Supercomputing Centre in Deutschland und im Joint Center for Advanced High Performance Computing in Japan.

JUPITER-Supercomputer setzt auf knapp 24.000 GH200-Superchips

Das Forschungszentrum Jülich wird auch den Supercomputer JUPITER betreiben, der ebenfalls auf der GH200-Architektur basiert und KI-Modelle in Bereichen wie Klima- und Wetterforschung, Materialwissenschaften, Arzneimittelforschung, Industrial Engineering und Quantencomputing beschleunigen soll.

JUPITER ist das erste System, das eine Vier-Knoten-Konfiguration des NVIDIA GH200 Grace Hopper Superchips verwendet.

Insgesamt werden fast 24.000 GH200-Chips verbaut, die JUPITER zum schnellsten KI-Supercomputer der Welt machen. JUPITER soll 2024 installiert werden und ist einer der Supercomputer, die im Rahmen des EuroHPC Joint Undertaking gebaut werden.

Im Rahmen des SC23 gab es auch Neuigkeiten zum kürzlich vorgestellten Eos-Supercomputer von Nvidia. Das deutsche Chemieunternehmen BASF will EOS für die Berechnung von 50-Qubit-Simulationen auf Nvidias CUDA Quantum-Plattform einsetzen.

Ziel ist es, die Eigenschaften der Verbindung NTA zu untersuchen, die zur Entfernung giftiger Metalle aus städtischen Abwässern eingesetzt wird.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.