Apple stellt Open-Source-Modell für leistungsstarke Bildbearbeitung per Text vor

Die Bildgenerierung mit KI hat in den letzten Jahren große Fortschritte gemacht, die Bildmanipulation hingegen weniger. Bis jetzt, denn Apple zeigt eine Methode, die komplexe Anweisungen versteht und sie entsprechend umsetzen kann.

Apple hat zusammen mit Forschenden der University of California ein neues Open-Source-KI-Modell entwickelt, das Bilder mit Hilfe von Anweisungen in natürlicher Sprache bearbeiten kann. "MGIE", das für Multimodal Large Language Models Guided Image Editing steht, wurde in einem Paper vorgestellt.

MGIE verwendet multimodale große Sprachmodelle (MLLMs), um Benutzerbefehle zu interpretieren und pixelgenaue Bildmanipulationen durchzuführen. MLLMs können sowohl Text als auch Bilder verarbeiten und haben sich bereits bewährt - etwa in Form von ChatGPT, das durch GPT-4V Bilder versteht und mit DALL-E 3 neue generiert.

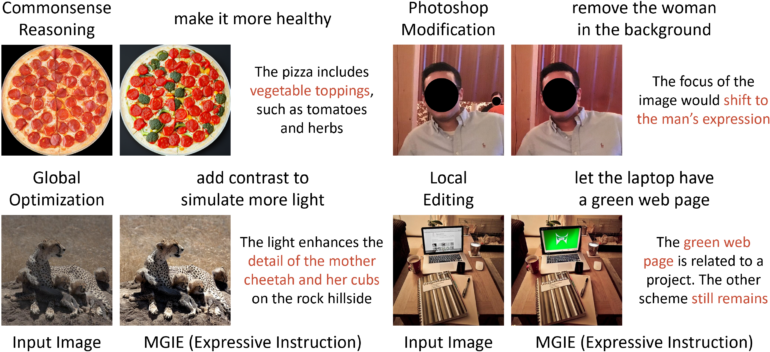

MGIE macht Gebrauch von diesen Fähigkeiten und erlaubt erstmalig umfassende Bildbearbeitungsaufgaben, die von einfachen Farbanpassungen bis hin zu komplexen Objektmanipulationen reichen.

Globale und lokale Manipulationen möglich

Ein weiteres Merkmal von MGIE ist die Fähigkeit, globale und lokale Manipulationen durchzuführen. Das Modell kann ausdrucksstarke anweisungsbasierte Bearbeitungen durchführen und gängige Photoshop-ähnliche Bearbeitungen wie Beschneiden, Skalieren, Drehen, Spiegeln und Hinzufügen von Filtern anwenden.

Es versteht auch anspruchsvolle Anweisungen, etwa um den Hintergrund zu ändern, Objekte hinzuzufügen oder zu entfernen sowie mehrere Bilder zusammenzuführen.

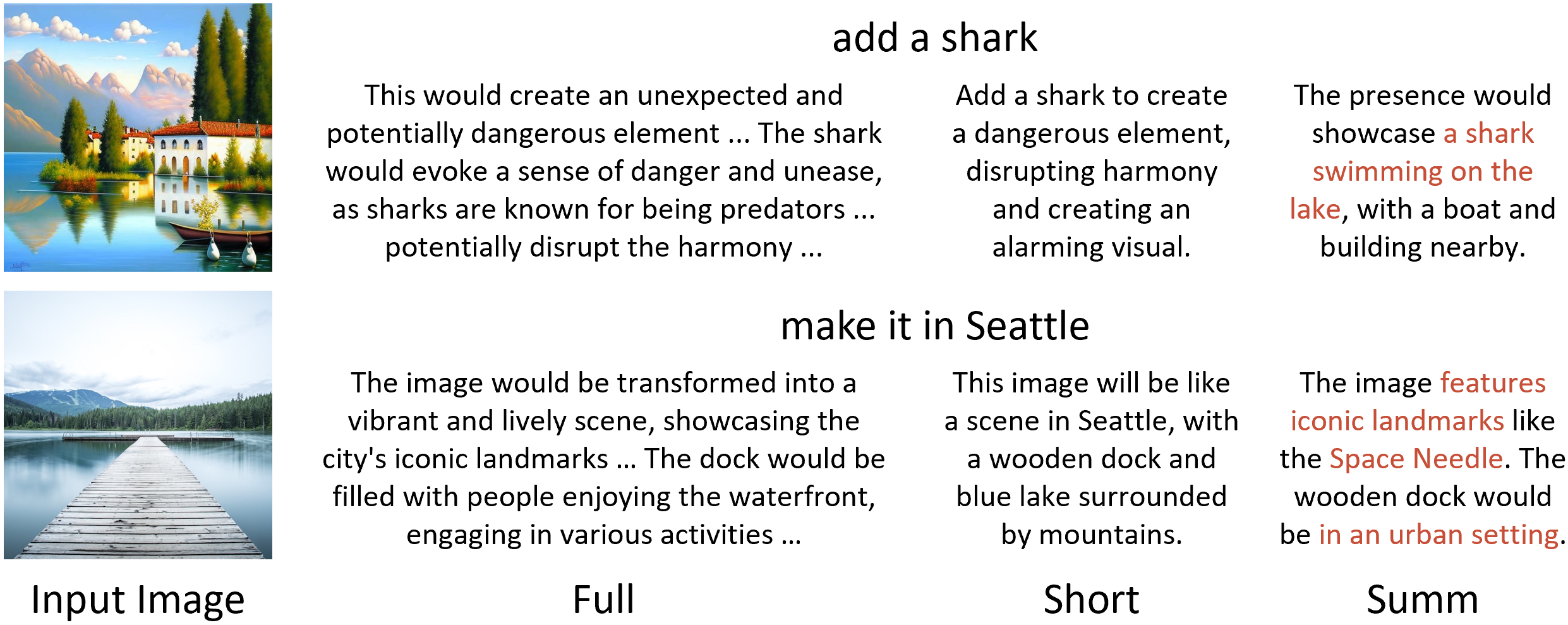

Die Methode basiert auf zwei Schritten. Der erste soll das Problem lösen, dass Nutzeranweisungen häufig zu kurz seien.

Der Anweisung des Nutzers stellen die Forschenden daher den Prompt "what will this image be like if" voraus, um sie durch ein Sprachmodell detailliert auszuformulieren. Ähnlich geht OpenAI bei DALL-E 3 in ChatGPT vor.

Da diese jedoch wiederum oft zu lang seien, kommt ein vortrainiertes Modell zur Zusammenfassung des ausführlichen Prompts zum Einsatz. Hier werden auch Wörter wie "Wüste" mit "Sanddünen" oder "Kakteen" verknüpft. Im zweiten Schritt wird eine visuelle Vorstellung der fertigen Bearbeitung erstellt.

MGIE ist als Open-Source-Projekt auf GitHub verfügbar. Außerdem gibt es eine Demo auf Hugging Face.

Weiterer Baustein in Apples KI-Strategie

Die Veröffentlichung von MGIE unterstreicht Apples wachsende Ambition im Bereich der KI-Forschung und -Entwicklung. Apple CEO Tim Cook hat kürzlich die baldige Einführung generativer KI-Funktionen in iOS 18 bestätigt und sich "unglaublich begeistert" von Apples Arbeit in diesem Bereich gezeigt. Forschungsarbeiten wie oben dürften einen Ausblick darauf geben, was Apple an neuen Funktionen für iOS plant.

Ein ähnliches, älteres Modell der instruktionsbasierten Bildverarbeitung ist InstructPix2Pix. Basierend auf Stable Diffusion war dieses Verfahren jedoch eher nur für die Veränderung einzelner Objekte in einem Bild gedacht und zeigt im Vergleich zu MGIE deutlich ungenauere Ergebnisse.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.