Elon Musks xAI bleibt auch mit dem neuen Grok 1.5 hinter OpenAI zurück

Elon Musks KI-Start-up xAI kündigt die Veröffentlichung seines neuesten Modells Grok-1.5 an.

Das neue Modell wird in Kürze für bestehende Nutzer und frühe Tester auf der X-Plattform verfügbar sein. Zu den Neuerungen gehören verbesserte Schlussfolgerungsfähigkeiten und eine Kontextlänge von 128.000 Token.

Die Kontextlänge beschreibt, wie viele Wörter oder Seiten das Modell auf einmal verarbeiten kann. 128K entsprechen etwa 100.000 Wörtern oder 300 Buchseiten. Damit kann Grok 1.5 auch komplexere Prompts mit mehr Beispielen verarbeiten.

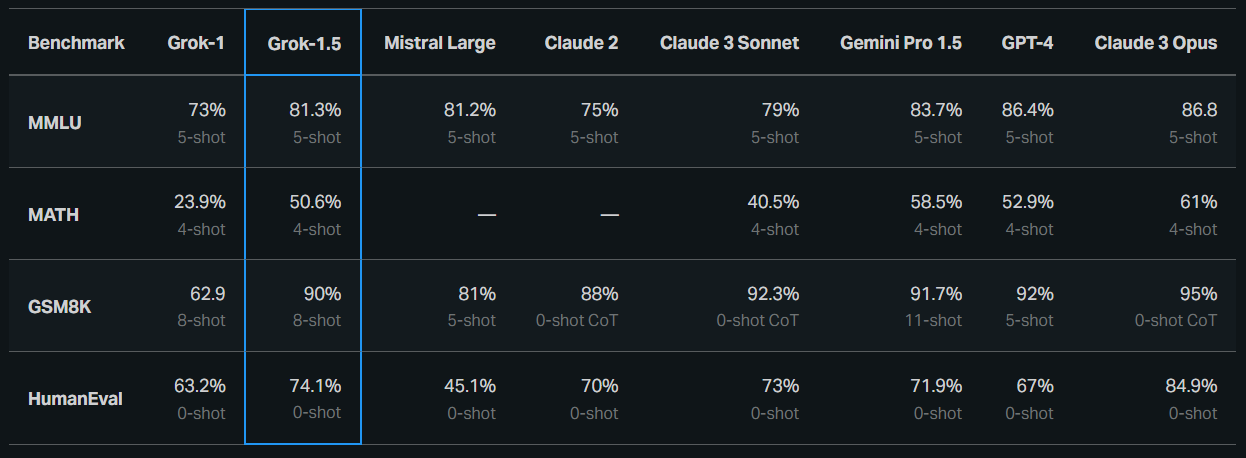

In Tests erreichte Grok-1.5 eine Punktzahl von 50,6 Prozent für den MATH-Benchmark und 90 Prozent für den GSM8K-Benchmark. Beide Benchmarks decken ein breites Spektrum von Mathematikproblemen ab, das von der Grundschule bis zum Wettbewerbsniveau der Oberstufe reicht. Bei der Codegenerierung und beim Problemlösen erreichte Grok-1.5 beim HumanEval-Benchmark 74,1 Prozent.

Im Sprachverständis-Benchmark MMLU erreichte Grok 1.5 rund 81 Prozent. Ein großer Fortschritt gegenüber Grok-1 (73 Prozent), aber deutlich hinter den aktuellen Spitzenmodellen GPT-4 und Claude 3 Opus mit jeweils gut 86 Prozent. Und OpenAI dürfte mit GPT-4.5 bereits das nächste Update in der Mache haben.

Im "Needle in the Haystack"-Test, der prüft, ob das KI-Modell eine bestimmte Information im Kontextfenster zuverlässig finden kann, erzielte Grok 1.5 ein perfektes Ergebnis. Allerdings ist der Test wenig aussagekräftig, da er das Sprachmodell wie eine teure Suchfunktion verwendet. Relevanter, aber viel schwieriger zu testen, wäre z.B. die Anzahl der Fehler oder Lücken bei der Zusammenfassung sehr großer Dokumente.

Auch andere KI-Unternehmen wie Google oder Anthropic verwenden diesen letztlich irreführenden Benchmark.

xAI arbeitet an effizienterem KI-Training

xAI betont, dass es sich auf Innovation konzentriert, insbesondere im Trainings-Framework. Grok-1.5 basiert laut xAI auf einem speziellen verteilten Trainings-Framework, das auf JAX, Rust und Kubernetes basiert. Dieser Trainings-Stack ermöglicht es dem Team, Ideen zu prototypisieren und neue Architekturen mit minimalem Aufwand in großem Maßstab zu trainieren.

Eine der größten Herausforderungen beim Training von Large Language Models (LLMs) auf großen Compute-Clustern sei die Optimierung der Zuverlässigkeit und Verfügbarkeit des Trainingsjobs.

Der speziell von xAI entwickelte Training-Orchestrator soll sicherstellen, dass problematische Knoten automatisch erkannt und aus dem Trainingsjob entfernt werden. Checkpointing, Datenladen und Neustart von Trainingsjobs wurden ebenfalls optimiert, um die Ausfallzeit im Fehlerfall zu minimieren.

xAI hat Grok-1 vor etwa zwei Wochen als Open-Source-Modell veröffentlicht. Es ist das bisher größte Mixture-of-Experts-Modell, das als Open Source verfügbar ist. Es bleibt jedoch hinter der Leistung wesentlich kleinerer und effizienterer Modelle zurück. xAI äußert sich nicht zu Open-Source-Plänen für Grok 1.5.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.