Deepfake-Nudes: Eltern ahnungslos, Lehrer misstrauisch, Schüler gespalten

Eine neue Studie des Beratungsunternehmens The Human Factor beleuchtet das wachsende Problem von KI-generierten Nacktbildern Minderjähriger, so genannten Deepfake Nudes, die von Schülerinnen und Schülern erstellt und verbreitet werden. Das Beratungsunternehmen hat mehr als 1000 Eltern, Schülerinnen und Schüler, Lehrkräfte und Technologieexperten befragt und praktische Lösungen erarbeitet.

In den USA gab es zuletzt mehrere Vorfälle, in denen Schüler mithilfe von KI-Bildgeneratoren gefälschte Nacktbilder von Mitschülern erstellten und verbreiteten. Bei einem Vorfall in Florida wurden zwei Teenager angeklagt, weil sie Deepfakes von 22 Mitschülern und Lehrern teilten. Ein ähnlicher Fall ereignete sich an einer Highschool in New Jersey und in Spanien.

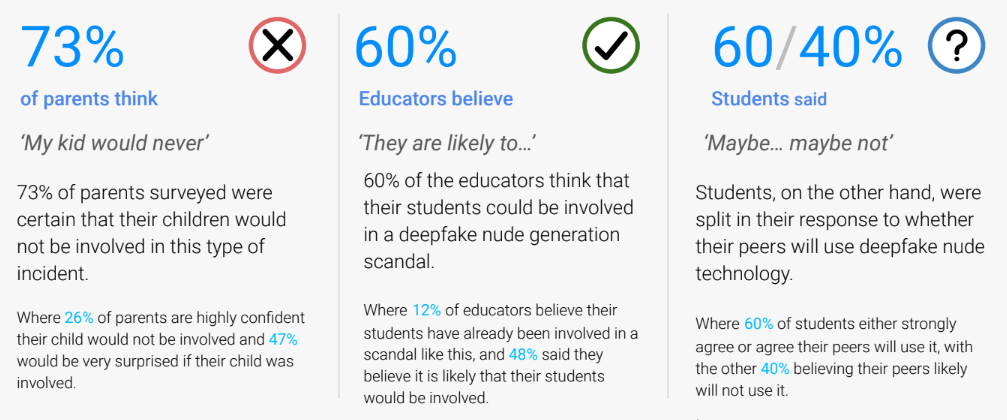

Die Studie zeigt, dass die meisten Eltern vollkommen ahnungslos sind. 73 Prozent der befragten Eltern waren sich sicher, dass ihre Kinder niemals in einen Deepfake-Skandal involviert sein würden. Im Gegensatz dazu glauben 60 Prozent der Lehrer, dass ihre Schüler möglicherweise involviert sein könnten.

Die Schüler hingegen waren geteilter Meinung: 60 Prozent hielten es für wahrscheinlich, dass ihre Mitschüler die Technik missbrauchen würden, 40 Prozent hielten es für unwahrscheinlich.

Bestehende Gesetze greifen oft zu kurz

Zwar gibt es Gesetze zu verwandten Themen wie Kinderpornografie, Rachepornos oder Cybermobbing. Eindeutige bundesweite Regelungen zu von Minderjährigen erstellten Deepfake Nudes Minderjähriger fehlen aber. Auch die Rechtsprechung hinkt der technischen Entwicklung hinterher.

Härtere Strafen könnten zudem Schüler abschrecken, Vorfälle zu melden - aus Angst vor Konsequenzen für die Täter, oft Mitschüler oder Freunde. Opfer wiederum wollen eine erneute Traumatisierung durch Gerichtsverfahren vermeiden.

Auch Techfirmen stoßen an Grenzen. Inhalte zuverlässig als Deepfakes zu erkennen, ist schwierig. Zudem werden die Bilder in privaten Chatgruppen geteilt, auf die Plattformen keinen direkten Zugriff haben. Zum Teil würden die Bilder dort Monate zirkulieren.

Gerade weil die Bilder oft in Gruppen geteilt werden, können nur die Beteiligten darüber berichten. Doch hier mangelt es noch an Mut und Aufklärung, wie die Studie zeigt.

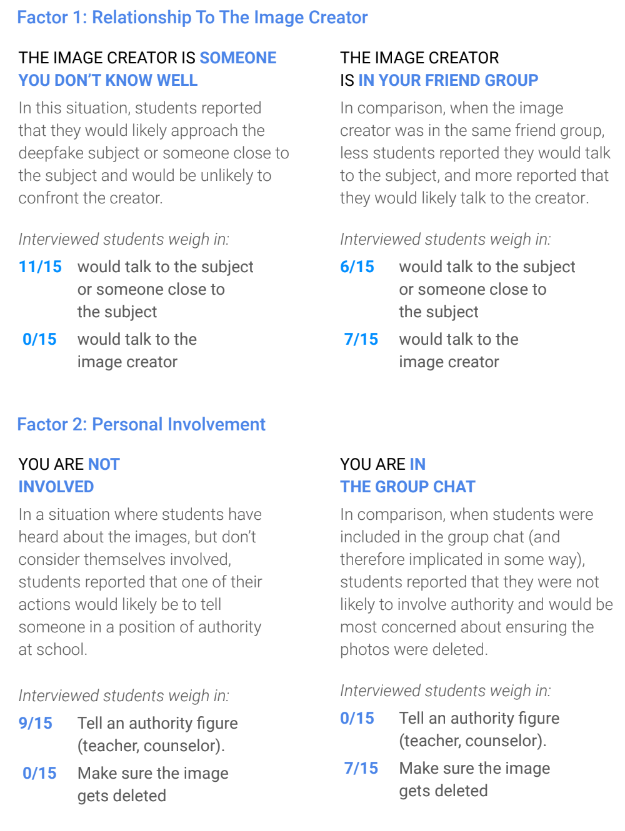

Eine Umfrage unter US-Schülern der 7. bis 12. Klasse ergab, wenn die Schüler von den Bildern hörten, aber nicht involviert waren, würden immerhin 9 von 15 eine Autoritätsperson informieren. Kein Schüler würde jedoch auf Löschung der Bilder drängen.

Waren die Schüler jedoch in den Gruppenchat eingebunden, würde niemand Autoritäten einschalten. Stattdessen würden 7 von 15 darauf bestehen, dass die Fotos gelöscht werden. Eine direkte Konfrontation mit dem Bildersteller wird gemieden (7/30), mehr als die Hälfte der Befragten (17/30) würde sich immerhin im Freundeskreis umhören.

Die Studie zeigt, dass die Nähe zum Vorfall und die eigene Verwicklung entscheidend dafür sind, ob Schüler Deepfake-Vorfälle melden oder nicht. Je stärker involviert, desto geringer ist die Bereitschaft, Lehrkräfte einzuschalten und desto größer der Wunsch nach Vertuschung.

Empfehlungen an Schulen und Eltern

Die Studie empfiehlt mehr Aufklärung und klare Konsequenzen. Schulen sollten KI und Deepfakes offen thematisieren, die Auswirkungen auf die Opfer hervorheben und (anonyme) Meldesysteme einrichten. Eltern wird empfohlen, mit ihren Kindern über Technologie zu sprechen und gemeinsam Regeln aufzustellen.

Schulordnungen und Verhaltenskodizes sollten Deepfake Nudes explizit als Vergehen benennen und Strafen festlegen. Das ermögliche schnelles, rechtssicheres Handeln von Lehrern und Rektoren. Anonyme Meldesysteme könnten Schüler ermutigen, Fälle zu melden.

Empathie für alle Beteiligten sei entscheidend, so die Experten. Die Technologie entwickle sich so schnell, dass perfekte Lösungen unmöglich seien. Verständnis füreinander erleichtere die Zusammenarbeit bei der Etablierung neuer, gesunder Verhaltensnormen.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.