Sony entwickelt mit Forschern KI-Musikeditor, der Songs per Text umschreiben kann

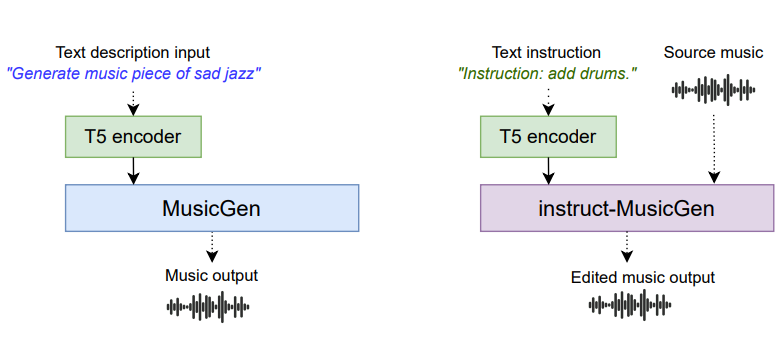

Forscher der Queen Mary University of London, Sony AI und des Music X Lab am MBZUAI haben ein KI-System namens Instruct-MusicGen vorgestellt, das bestehende Musik anhand von Textanweisungen gezielt verändern kann.

Instruct-MusicGen basiert auf dem bestehenden Open Source KI-Modell MusicGen, das die Forscher für Text-zu-Musik-Bearbeitungsaufgaben optimiert haben. Zu diesem Zweck modifizierte das Team die ursprüngliche MusicGen-Architektur durch die Integration eines Text- und eines Audio-Fusion-Moduls, die es dem Modell ermöglichen, Prompts und Audioeingaben gleichzeitig zu verarbeiten.

Durch die Einführung von Audio- und Textfusionsmodulen kann Instruct-MusicGen präzise Bearbeitungsaufgaben wie das Hinzufügen, Entfernen oder Trennen von Musikspuren, sogenannten Stems, durchführen. Stems sind gemischte Gruppen von Spuren, oft nach Instrumententyp sortiert, und spielen eine zentrale Rolle in der Musikproduktion.

Input-Audio ohne Bass:

Mit Anweisung "add bass":

Input Audio:

Input Audio "only drums":

Die Forscher betonen, dass Instruct-MusicGen die Effizienz der Text-zu-Musik-Verarbeitung verbessert und die Anwendbarkeit von Musik-Sprachmodellen in dynamischen Produktionsumgebungen erweitert.

Das neue Modell benötige nur acht Prozent mehr Parameter und 5.000 zusätzliche Trainingsschritte, weniger als ein Prozent der gesamten Trainingszeit von MusicGen, um gute Ergebnisse zu erzielen.

Zahlreiche Beispiele, den Code, das Modell und die Gewichte stellen die Entwickler auf der Projektseite zur Verfügung.

Lizenzrechtlich dürfte Sony auf der sicheren Seite sein: Meta hat MusicGen nach eigenen Angaben nur auf lizenzierte Musik trainiert und für das eigene Instruction Tuning den Slakh2100-Datensatz mit synthetisch erzeugten Musikstücken verwendet.

Das ist insofern relevant, als Sony eine der treibenden Kräfte hinter einer Klage wegen angeblicher Lizenzverletzung gegen existierende Musikgeneratoren ist, die aus Textprompts gänzlich neue Stücke generieren können.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.