Alibabas neue Mathe-Sprachmodelle rechnen besser als GPT-4 und Co.

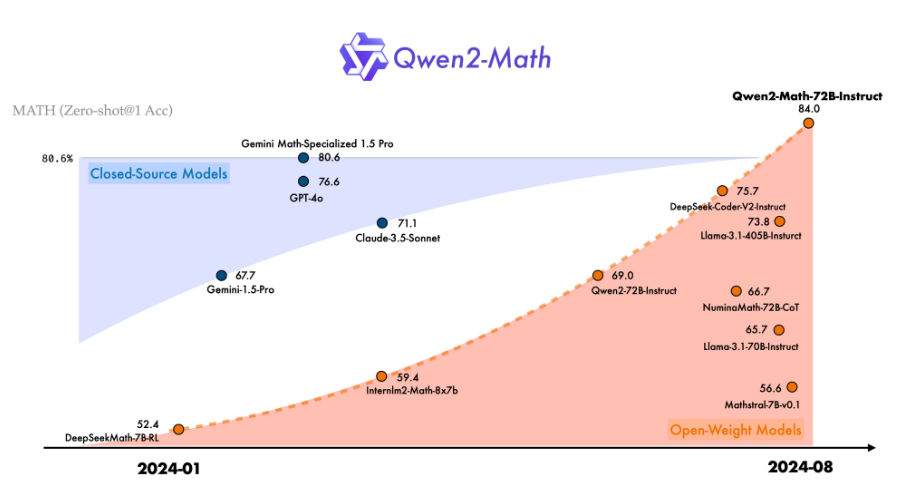

Alibabas Cloud-Computing-Abteilung hat eine neue Reihe von Sprachmodellen namens Qwen2-Math vorgestellt, die speziell für mathematische Aufgaben optimiert sind. In Benchmarks schneiden sie besser ab als generisch trainierte LLMs wie GPT-4 und Claude.

Qwen2-Math- und Qwen2-Math-Instruct-Modelle für Chats gibt es in verschiedenen Größen von 1,5 bis 72 Milliarden Parametern. Sie basieren auf den allgemeinen Qwen2-Sprachmodellen, wurden aber zusätzlich auf einem speziell zusammengestellten Mathematik-Korpus vortrainiert.

Dieser Korpus enthält große Mengen an hochwertigen mathematischen Webtexten, Büchern, Code, Prüfungsfragen und von Qwen2 synthetisierten mathematischen Vortrainingsdaten. Dadurch übertreffen die Qwen2-Math-Modelle laut Alibaba die mathematischen Fähigkeiten von generisch trainierten LLMs wie GPT-4.

Qwen2-Math übertrifft GPT-4, Claude und Co. in mathematischen Aufgaben

In Benchmarks wie GSM8K, Math und MMLU-STEM schneidet das größte Modell Qwen2-Math-72B-Instruct besser ab als Modelle wie GPT-4, Claude-3.5-Sonnet, Gemini-1.5-Pro und Llama-3.1-405B. Auch in chinesischen Mathematik-Benchmarks wie CMATH, GaoKao Math Cloze und GaoKao Math QA erzielt es Bestleistungen.

Fallstudien mit olympischen Mathematikaufgaben zeigen laut Alibaba, dass Qwen2-Math in der Lage ist, einfachere Aufgaben von Mathematik-Wettbewerben zu lösen. Das Qwen-Team betont jedoch, dass es die Korrektheit der Lösungswege nicht garantieren kann.

Um eine Verfälschung der Testergebnisse durch Überschneidungen zwischen Trainings- und Testdaten zu vermeiden, hat das Qwen-Team nach eigenen Angaben sowohl die Datensätze vor als auch nach dem Training bereinigt.

Derzeit unterstützen die Qwen2-Math-Modelle hauptsächlich Englisch. Das Team plant jedoch, in Kürze zweisprachige Modelle zu veröffentlichen, die sowohl Englisch als auch Chinesisch unterstützen. Auch die Entwicklung mehrsprachiger Modelle ist laut Alibaba in Vorbereitung.

Die Math-Modelle sind unter der Tongyi Qianwen-Lizenz bei Hugging Face verfügbar. Bei mehr als 100 Millionen Nutzern und Nutzerinnen pro Monat wird eine kommerzielle Lizenz benötigt.

Hybride KI-Systeme sollen LLMs Logik beibringen

Hinter der Qwen-Modellreihe steckt die Cloud-Computing-Einheit des chinesischen E-Commerce-Giganten Alibaba. Die erste Generation der Qwen-Sprachmodelle wurde von den Forschern im August 2023 veröffentlicht.

Kürzlich stellte Alibaba mit Qwen2 eine deutlich leistungsfähigere Nachfolgegeneration vor, die Verbesserungen in Bereichen wie Programmierung, Mathematik, Logik und Mehrsprachigkeit bietet.

Alibaba will die Fähigkeit der Modelle, komplexe und anspruchsvolle mathematische Probleme zu lösen, weiter verbessern. Es ist jedoch unsicher, dass das Training von Sprachmodellen auf mathematische Probleme allein zu einer grundlegenden Verbesserung der logischen Fähigkeiten der Modelle führt.

Google Deepmind und vermutlich auch OpenAI setzen wohl eher auf hybride Systeme, die versuchen, die logischen Fähigkeiten klassischer KI-Algorithmen mit den Fähigkeiten der generativen KI zu verheiraten. Google Deepmind hat kürzlich mit AlphaProof ein erstes solches System vorgestellt. Die Skalierbarkeit per verstärkendem Lernen und Verallgemeinerbarkeit bleibt abzuwarten.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.