"Plan Like a Graph": Neue Prompting-Methode hilft Sprachmodellen beim Planen

Methoden, die Menschen beim Denken helfen, können auch Sprachmodelle unterstützen. Die Darstellung von Schrittfolgen in Graphenform kann zu signifikanten Leistungsschüben führen.

Forscher:innen von renommierten Institutionen wie der University of Oxford, dem Alan Turing Institute, dem Allen Institute for AI und der LMU München haben die Fähigkeiten großer Sprachmodelle bei der Lösung komplexer Planungsaufgaben untersucht.

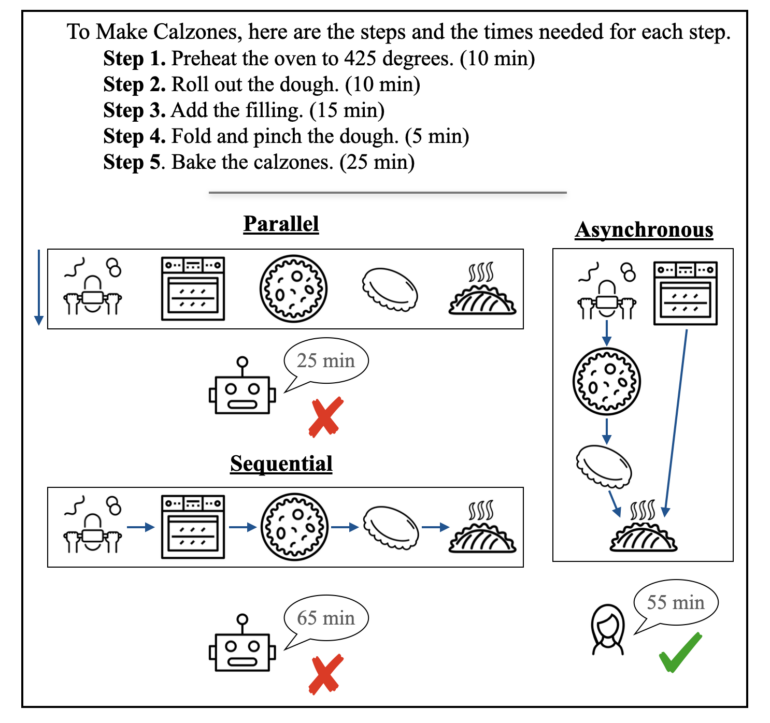

Ziel war es herauszufinden, ob LLMs Pläne optimieren können, die sowohl sequenzielle, also aufeinanderfolgende, als auch parallele Aktionen unter Zeit- und Ressourcenbeschränkungen beinhalten. Die Wissenschaftler:innen stellten ihre Methode "Plan Like a Graph" (PLaG) in einem kürzlich veröffentlichten Paper vor.

Methode für alle Sprachmodelle einsetzbar

Die Ergebnisse zeigten, dass es die Leistung der Sprachmodelle erheblich steigern kann, wenn man das Problem im Prompt durch einen zusätzlichen Graphen darstellt.

Laut den Autor:innen des Papers verbessert PLaG die Leistung aller getesteten Modelle und ist eine sofort einsetzbare Methode, die auch auf aktuelle Modelle werden könne. Das neuste getestete Modell ist das mittlerweile für KI-Verhältnisse etwas betagte GPT-4.

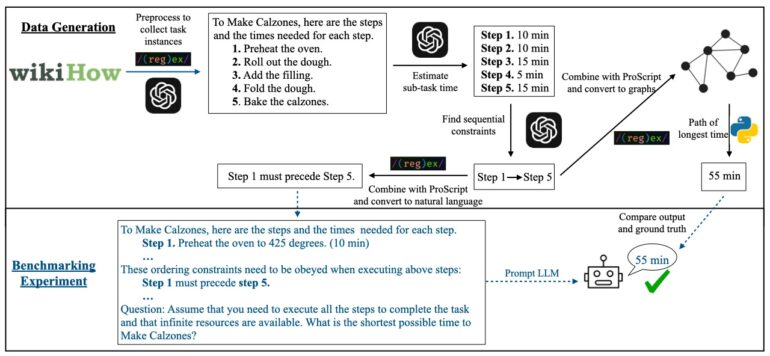

Zur Evaluierung von PLaG entwickelten die Autor:innen des Papers einen Benchmark-Datensatz namens AsyncHow, der über 1.600 realistische Planungsprobleme enthält. Der Datensatz basiert auf dem bestehenden ProScript-Set und wurde um Anleitungen von WikiHow ergänzt.

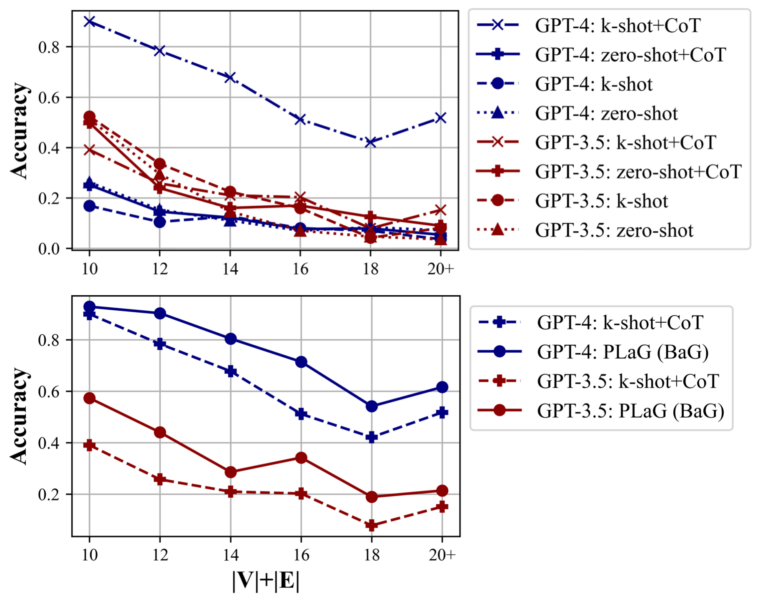

Die Forscher:innen testeten PLaG mit verschiedenen neueren und älteren Sprachmodellen, darunter GPT-3.5, GPT-4, Cohere Command sowie Open-Source-Modellen wie LLaMA-2 und Mistral-7B. Allerdings warnten die Forscher:innen, dass die Leistung der LLMs mit zunehmender Komplexität bzw. Anzahl der Schritte der Aufgabe drastisch abnimmt.

Die Variante "Build a Graph" (BaG), bei der das LLM seine eigene Graphendarstellung des Problems generiert, führt sogar zu noch besseren Ergebnissen als die Verwendung eines explizit vorgegebenen Graphen. Die Autor:innen des Papers vermuten, dass das LLM die Graphendarstellung für sein eigenes Reasoning optimieren kann.

AGI trotzdem noch in weiter Ferne

Trotz der Verbesserungen durch PLaG sind LLMs laut den Forscher:innen noch nicht robust genug, um als allgemein intelligente Agenten für komplexe Planung eingesetzt zu werden. Es gebe - zumindest derzeit noch - Grenzen für den Einsatz von LLMs als eigenständige digitale Planer.

Die Autor:innen des Papers sehen mehrere Möglichkeiten, ihre Arbeit in Zukunft weiterzuentwickeln. Dazu gehört es, den Benchmark um zusätzliche Einschränkungen zu erweitern und die Leistungsmuster von LLMs und Menschen bei denselben Planungsaufgaben zu vergleichen.

Seit Veröffentlichung der "PLaG"-Methode hat OpenAI bereits sein neustes Modell o1 vorgestellt, das auf logisches Denken optimiert ist. Spannend wäre es daher zu testen, ob diese Technik auch die Planungsfähigkeiten von o1 verbessert.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.