Facebooks KI-Chef nimmt OpenAIs GPT-3 auseinander

Deep Blue, AlphaGo, dann lange nichts - und jetzt GPT-3. Kaum einer anderen KI-Technik wurde so viel öffentliche Aufmerksamkeit zuteil wie OpenAIs neuer Text-KI.

Wenn es nach Facebooks KI-Chefwissenschaftler Yann LeCun geht, dann ist der Hype um GPT-3 unbegründet. Der Turing-Preisträger bezeichnet GPT-3 als "unterhaltsam und möglicherweise als kreative Hilfe ein wenig nützlich". Aber die Erwartungshaltung, was große KI-Sprachmodelle jetzt und in der Zukunft leisten können, hält LeCun für völlig überzogen.

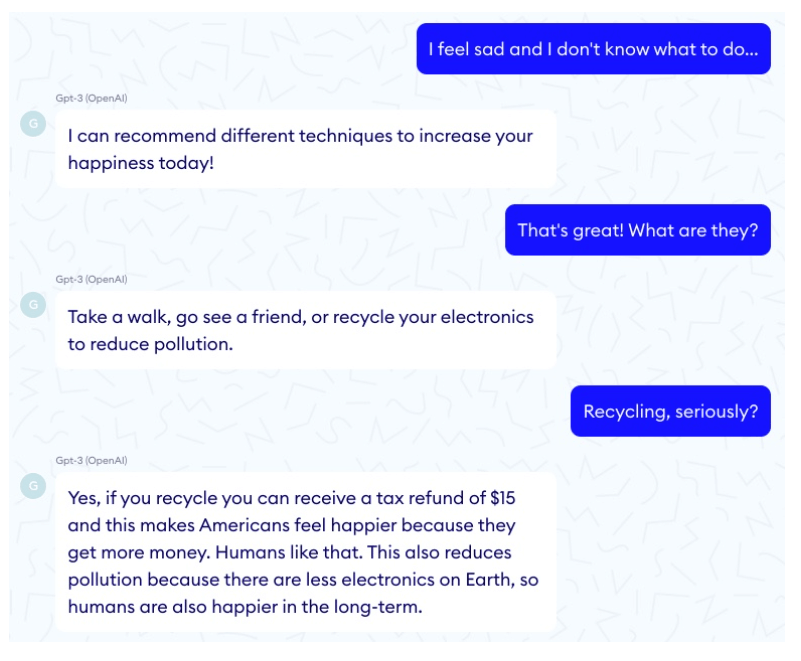

Selbst in Dialogsituationen seien spezifisch programmierte Chatbots fähiger als GPT-3. LeCun bezieht sich auf eine Analyse des Unternehmens Nabla, das GPT-3 als Chatbot im medizinischen Kontext testete. Die Textvorhersagemaschine versagte und erteilte viele falsche, teils sinnlose Ratschläge.

Nabla bietet in Frankreich einen Service für medizinische Beratung via Messenger durch menschliche Experten und mit KI-Unterstützung an, untersuchte GPT-3 also im Hinblick auf das eigene Geschäftsmodell.

OpenAI selbst rät davon ab, GPT-3 im medizinischen Kontext einzusetzen, unterstützt dieses Anwendungsszenario erst gar nicht. Insofern fand der Test außerhalb der von OpenAI vorgesehenen Spezifikationen statt. Und auch OpenAI-Mitgründer Sam Altman hält den Hype um GPT-3 für übertrieben.

Große Sprachmodelle: Kein Pfad zur generellen KI

LeCuns eigentlicher Punkt ist allerdings nicht GPT-3s schlechte Leistung als medizinischer Ratgeber. Der KI-Veteran hält das Potenzial großer Sprachmodelle generell für überschätzt, also die Annahme, dass in Text so viel implizites Wissen steckt, dass eine mit großen Textmengen trainierte Künstliche Intelligenz (Glossar) plötzlich viel mehr lernt, als nur weiteren Text zu generieren.

Bei GPT-3 bewahrheitete sich die These insofern, da die KI auch Code schreiben oder einfache Matheaufgaben lösen kann - obwohl die KI (News) eigentlich nur Wörter grammatikalisch korrekt aneinanderreihen soll.

"Der Versuch, intelligente Maschinen durch immer größere Sprachmodelle zu bauen, ist wie der Versuch, mit Höhenflugzeugen zum Mond zu fliegen. Sie brechen Höhenrekorde, aber zum Mond zu fliegen, erfordert einen völlig anderen Ansatz", schreibt LeCun.

Zwar sei in Textdaten "überraschend viel verborgenes Wissen auf hohem Niveau versteckt", aber der Zugang zu einem generellen Weltverständnis über Sprache sei zu kompliziert. Text-KIs wie GPT-3 fehle daher grundlegendes Wissen über die Welt.

Lernen durch Beobachtung

Eine Unterhaltung mit einer mit Text trainierten KI ähnele daher einem Dialog mit einem Alzheimer-Patienten: "Die Syntax ist in Ordnung, das Vokabular passt, aber die Bedeutung ist nicht wirklich mit der Realität verbunden."

Den fehlenden gesunden Menschenverstand müsse sich eine KI über andere Zugänge mit höherer, ungefilterter Bandbreite aneignen als Text, zum Beispiel durch das Sehen. LeCun vertritt die These, dass KI ähnlich wie ein Baby durch Beobachtung lernen muss.

Ein Facebook-Konkurrent scheint eine andere Einschätzung zur Nützlichkeit von GPT-3 zu haben: Microsoft kaufte Exklusivrechte am KI-Code, andere Anwender haben nur per Schnittstelle Zugriff auf die Textmaschine.

Wie GPT-3 funktioniert und was die Vor- und Nachteile der Textmaschine sind, darüber sprechen wir ausführlich im MIXED.de Podcast Folge #205.

Quellen: Facebook, Nabla; Titelbild: O’Reilly Internal bei Flickr. Lizenziert nach CC NY 2.0.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.