Plötzlich gut in Mathe: Hat Open AIs GPT-3 gelernt zu lernen?

OpenAIs Sprach-KI kann Mathe – zumindest ein bisschen. Warum ist das überraschend und was bedeutet es?

Seit Juni 2020 haben erste Entwickler Zugriff auf OpenAIs GPT-3 und demonstrieren die beeindruckenden Fähigkeiten der Text-KI in verschiedenen Anwendungen: Sie kann Sprachbefehle in funktionierenden Web-Code verwandeln, Entwickler-Legende John Carmack imitieren oder als Suchmaschine genutzt werden.

Das ist nur ein Bruchteil der vielfältigen KI-Experimente, die klar machen: GPT-3 überrascht mit unerwarteten Fähigkeiten.

Du hattest einen Job zu erledigen ... und machst zwei?

Unerwartet sind GPT-3s Fähigkeiten, da die Text-KI im Kern sehr einfach funktioniert: Sie sagt das nächste wahrscheinliche Wort voraus ausgehend von einer vorhandenen Reihe Wörter. So vervollständigt sie Sätze, Gedichte oder ganze Essays.

Doch im Training hat GPT-3 ganze 470 Gigabyte Webtext gesehen - darunter auch Code-Beispiele oder Rechentabellen. Wie verwertet sie diese Symbole?

In den Experimenten zeigt sich: Das Prinzip der Wort-Vorhersage überträgt sich nahtlos von Buchstaben auf Zahlen und Sonderzeichen. So kommt es, dass GPT-3 Mathe kann – obwohl die KI nie explizit dafür trainiert wurde.

GPT-3 rechnet tatsächlich

Einen Ausblick auf diese Fähigkeit gab es bereits im Mai, als OpenAI die neue Text-KI erstmals vorstellte. In einem Abschnitt der wissenschaftlichen Arbeit untersuchen die OpenAI-Forscher die mathematischen Fähigkeiten der KI.

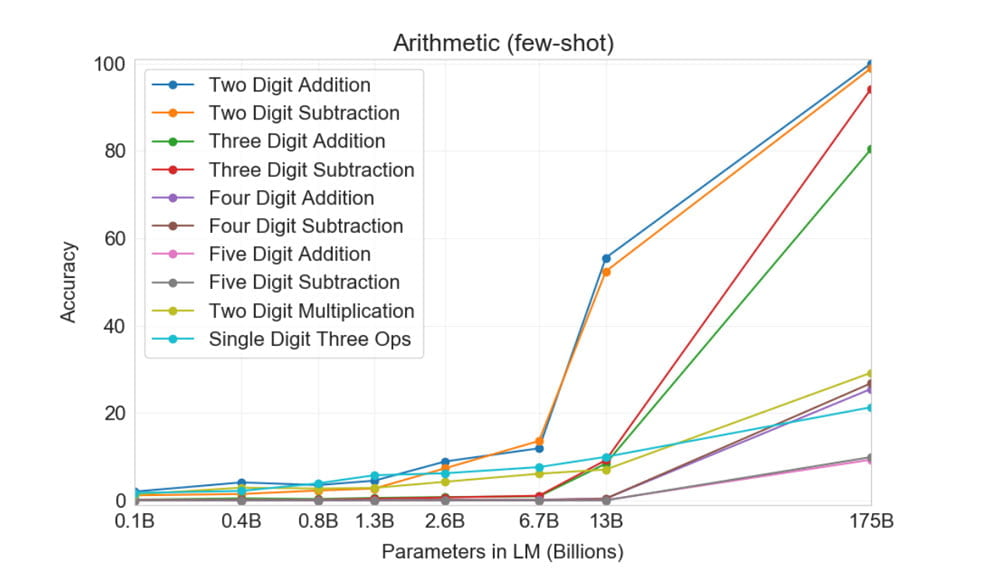

Die Forscher lassen dort die große Variante von GPT-3 mit 175 Milliarden Parametern gegen kleinere Varianten in der Addition, Subtraktion und Multiplikation von zwei- bis fünfstelligen Zahlen antreten.

Es zeigt sich: Das große Modell, also das besonders umfangreich trainierte, kann wesentlich besser rechnen und addiert und subtrahiert zuverlässig zwei- und dreistellige Zahlen. In anspruchsvolleren Rechenaufgaben schlägt sich das große Modell ebenfalls besser – aber liegt in 75 bis 90 Prozent der Fälle falsch und damit weit unter jeder Alltagstauglichkeit.

OpenAI prüfte außerdem, dass GPT-3 die Lösungen für die Matheaufgaben nicht einfach nur im großen Texthaufen abliest: In den Trainingsdaten finden sich lediglich 0,8 Prozent bzw. 0,1 Prozent der 2.000 getesteten Additions- und Subtraktions-Rechenaufgaben mit dreistelligen Zahlen.

Mit anderen Worten: GPT-3 hat gelernt, zu rechnen - obwohl das nie die Intention der Entwickler war.

Hat GPT-3 gelernt, zu lernen?

Experimente von Facebook zeigen, dass die von GPT-3 genutzte Transformer-Architektur in der Lage ist, komplexe mathematische Formeln zu lösen. Facebook nutzte dafür aber einen spezialisierten Datensatz, der die KI direkt für die Lösung von Formeln trainierte.

GPT-3 hingegen macht aus den mangelnden Trainingsdaten eine Tugend: Die KI lernt rechnen, um ihr eigentliches Lernziel besser zu erreichen – das nächstwahrscheinliche Zeichen in einer Zeichenfolge vorhersagen.

Das könnte ein Hinweis darauf sein, dass ausreichend vielfältig trainierte KI-Systeme wie GPT-3 gewisse generalisierte, logische Fähigkeiten erlernen können.

Da die Kurven in allen Benchmarks für GPT-3s Fähigkeiten steil nach oben zeigen, wird OpenAI wohl ein noch größeres Modell trainieren. Das könnte noch besser rechnen und neue, unerwartete Fähigkeiten zeigen.

Über OpenAIs GPT-3 und die unerwarteten Mathe-Fähigkeiten einer Text-KI sprechen wir ausführlich in unserem MIXED.de Podcast #205.

Via: Arxiv

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.