Menschen misstrauen als "KI-generiert" gekennzeichneten Schlagzeilen

Laut einer aktuellen Studie stufen Menschen Schlagzeilen, die als "KI-generiert" gekennzeichnet sind, als weniger glaubwürdig ein und teilen sie seltener - selbst wenn die Inhalte wahr sind oder von Menschen erstellt wurden. Sie gehen davon aus, dass die Artikel vollständig von KI verfasst wurden.

Forscher der Universität Zürich haben in zwei Experimenten mit knapp 2.000 Befragten untersucht, wie sich die Kennzeichnung von Schlagzeilen als "KI-generiert" auf die wahrgenommene Genauigkeit der Inhalte und die Bereitschaft zum Teilen auswirkt.

Die Ergebnisse zeigen: Die Kennzeichnung reduzierte die Glaubwürdigkeit und Teilungsbereitschaft, unabhängig davon, ob die Inhalte stimmten und ob sie tatsächlich von KI oder Menschen erstellt wurden. Selbst menschlich verfasste, aber fälschlich als KI-generiert gekennzeichnete Schlagzeilen wurden ebenso skeptisch bewertet wie echte KI-Schlagzeilen.

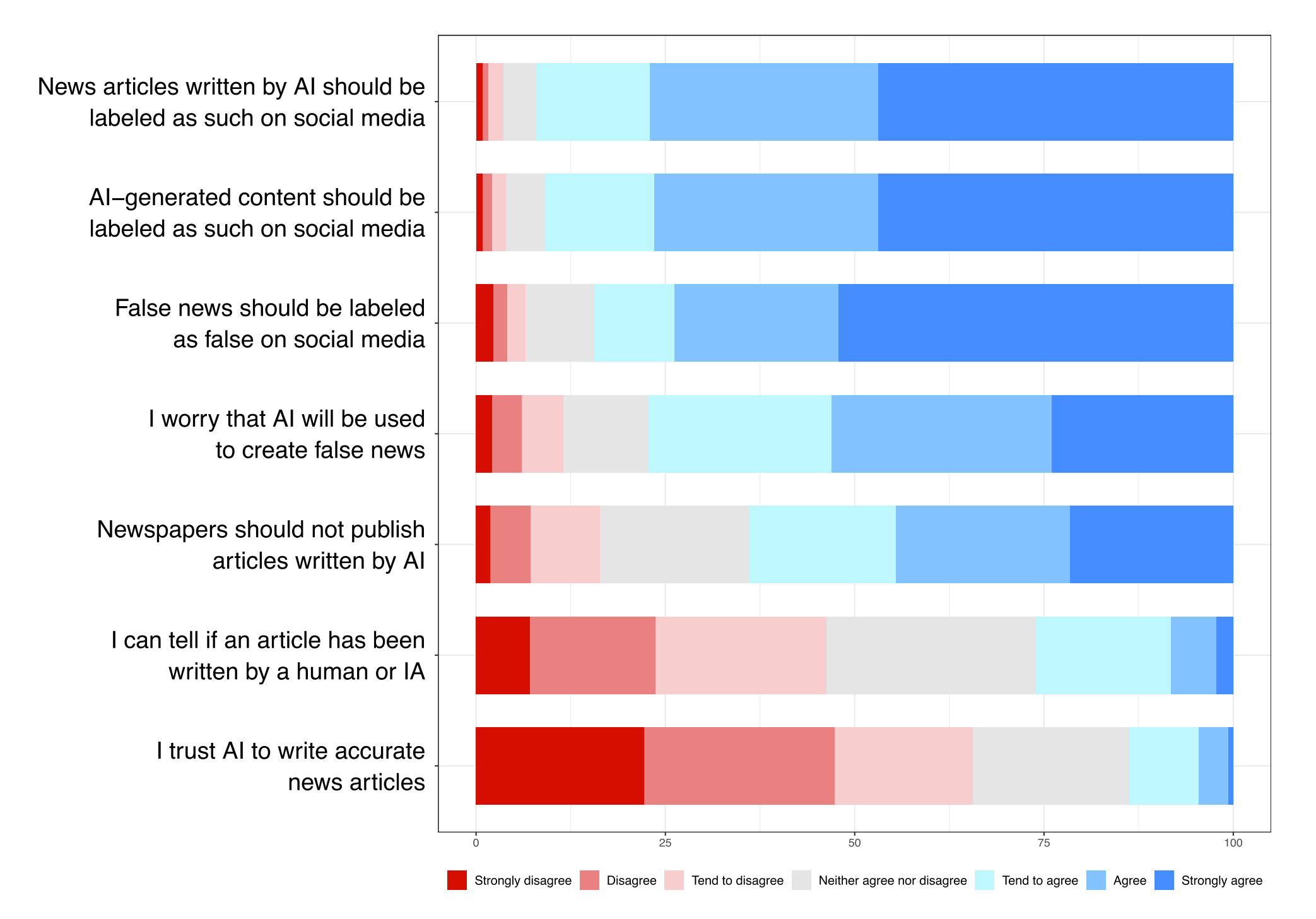

In einer Umfrage gaben die wenigsten Teilnehmenden an, mit bloßem Auge erkennen zu können, ob ein Artikel menschlich oder maschinell verfasst wurde, und dass sie einer KI zutrauen, korrekte Newsartikel zu schreiben.

In der zweiten Studie ging es um die Gründe für dieses Misstrauen. Dazu erklärten die Forscher den Teilnehmenden, was "KI-generiert" bedeutet, von einer schwachen Definition, bei der KI nur Klarheit und Stil verbesserte, bis zu einer starken Definition, bei der KI das Thema wählte und den gesamten Artikel schrieb.

Die Skepsis trat nur auf, wenn die Teilnehmenden keine Definition erhielten oder wenn ihnen die "starke" Definition präsentiert wurde. Daraus schließen die Forscher, dass Menschen bei als KI-generiert gekennzeichneten Schlagzeilen von einer vollständigen Erstellung durch KI ausgehen.

KI-Labels nicht leichtfertig verwenden

Die Studienautoren warnen daher vor einem vereinfachten Einsatz von KI-Labels, da diese auch auf nützliche KI-Inhalte abschreckend wirken könnten. Schädliche KI-Inhalte sollten ihrer Ansicht nach explizit als solche markiert werden, statt sie nur allgemein als KI-generiert zu kennzeichnen. Zudem sei Transparenz über die Bedeutung der Labels wichtig, damit Nutzer:innen keine falschen Annahmen treffen.

Die Ergebnisse fügen sich in ein Bild ein, das auch andere aktuelle Studien zeichnen: Generell stehen Menschen KI-generierten Nachrichten eher skeptisch gegenüber. So zeigte etwa eine Untersuchung, dass die Bereitschaft, KI-generierte und menschlich erstellte Fake News zu teilen, ähnlich hoch ist. Beide wurden aber als weniger glaubwürdig eingeschätzt als echte Nachrichten.

Eine Befragung des Reuters Institute ergab zudem, dass die meisten Menschen KI-generierte Nachrichten für weniger wertvoll halten als von Menschen verfasste Inhalte.

Expert:innen empfehlen Nachrichtenorganisationen daher einen wohlüberlegten Einsatz von KI primär für unterstützende Tätigkeiten und neue Darstellungsformen. Bei der Inhaltserstellung sei Vorsicht geboten. Entscheidend sei eine transparente Kommunikation über die KI-Nutzung - und dass alle Inhalte, egal ob mit oder ohne KI erstellt, von Menschen überprüft werden. Andernfalls drohe ein Vertrauensverlust des Publikums.

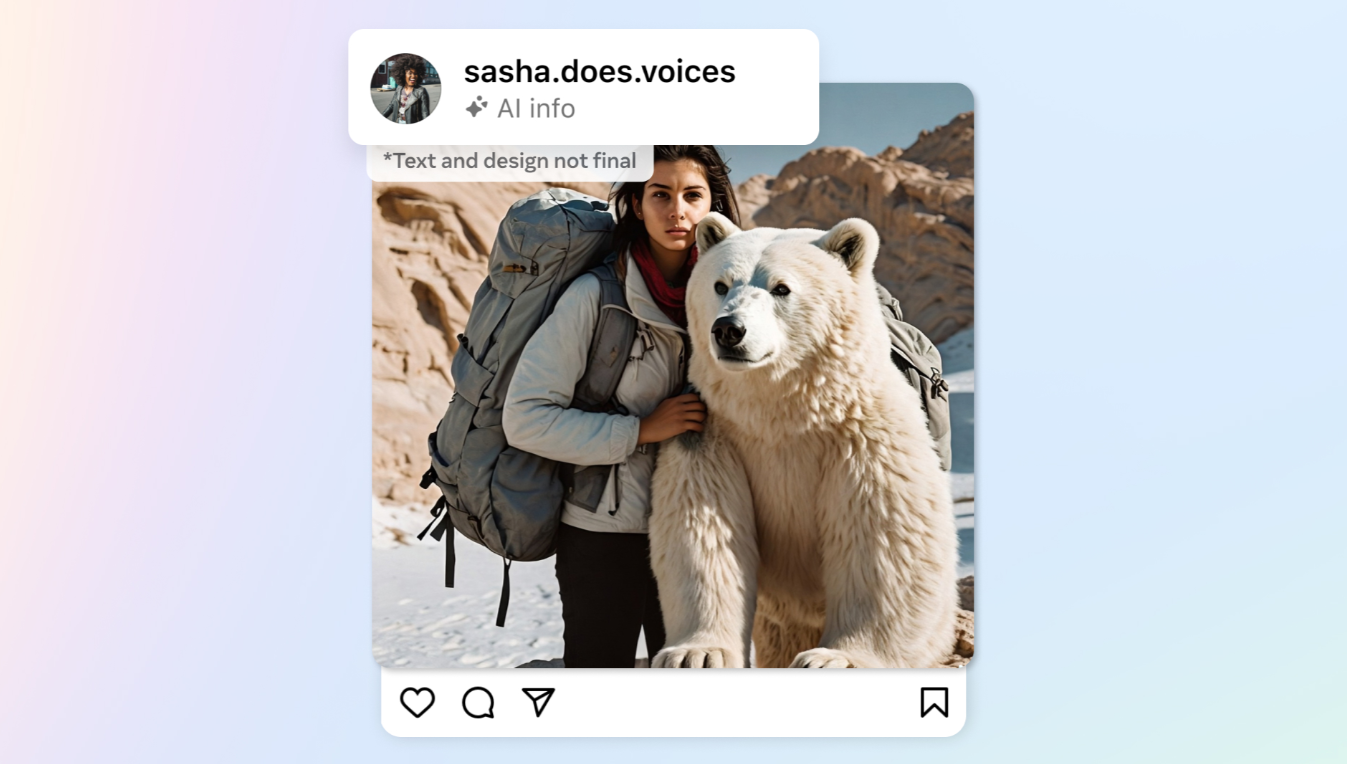

Die Kennzeichnung von KI-Inhalten spielt neben dem Nachrichtenbereich vor allem in den sozialen Medien eine Rolle. Meta gibt seinen Nutzer:innen seit einiger Zeit die Möglichkeit, bei jedem Beitrag eine "AI Info" hinzuzufügen.

Aus dieser geht jedoch trotz Umbenennung nicht hervor, wie viel KI zum Bild beigetragen hat, ob es etwa vollständig generiert, der Himmel verschönert oder lediglich kleinere Störelemente entfernt wurden.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.