Rhymes AI: Multimodales KI-Modell Aria ist Open-Source und schlägt viele Konkurrenten

Das US-Start-up Rhymes AI hat Aria veröffentlicht, das nach eigenen Angaben weltweit erste quelloffene, multimodale Mixture-of-Experts-Modell. Aria soll bei vergleichbarer Größe mit offenen und kommerziellen spezialisierten Modellen gleichauf sein oder sie übertreffen.

Rhymes AI hat sein erstes KI-Modell Aria als Open-Source-Software veröffentlicht. Laut dem Unternehmen ist Aria das weltweit erste quelloffene, multimodale Mixture-of-Experts-(MoE)-Modell.

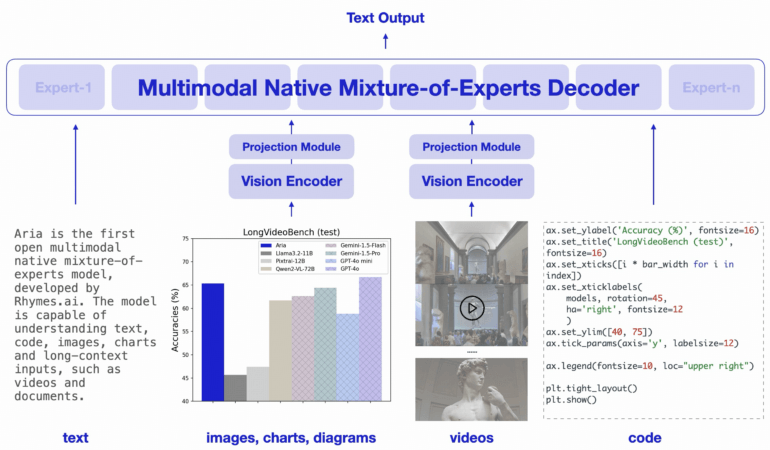

Ein nativ multimodales Modell definiert Rhymes AI als eines, das bei vergleichbarer Kapazität über mehrere Eingabemodalitäten wie Text, Code, Bild und Video hinweg die Verständnisfähigkeiten spezialisierter Modelle erreicht oder übertrifft.

MoE-Modelle ersetzen die Feed-Forward-Schichten eines Transformers durch mehrere spezialisierte Experten. Für jeden Input-Token wählt ein Router-Modul eine Teilmenge der Experten aus, wodurch die Anzahl der aktiven Parameter pro Token reduziert und die Recheneffizienz erhöht wird. Bekannte Vertreter dieser Klasse sind etwa Mixtral 8x7B und DeepSeek-V2. Auch GPT-4 baut mutmaßlich auf dieser Architektur auf.

Der MoE-Decoder von Aria aktiviert 3,5 Milliarden Parameter pro Texttoken und verfügt insgesamt über 24,9 Milliarden Parameter. Ein leichtgewichtiger visueller Encoder mit 438 Millionen Parametern wandelt visuelle Eingaben variabler Länge, Größe und Seitenverhältnis in visuelle Token um. Aria hat ein multimodales Kontextfenster von 64.000 Token.

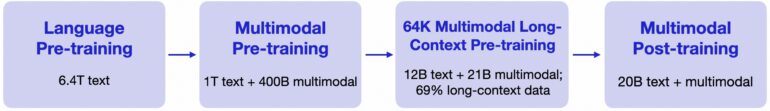

Rhymes AI hat Aria in vier Phasen vortrainiert: zunächst nur mit Textdaten, dann mit einer Mischung aus Text und multimodalen Daten, gefolgt von Training mit langen Sequenzen und schließlich mit einem Finetuning.

Insgesamt wurde Aria mit 6,4 Billionen Texttoken und 400 Milliarden multimodalen Token vortrainiert. Das Material stammt unter anderem aus den bekannten Datensätzen von Common Crawl und LAION und wurde teilweise synthetisch angereichert.

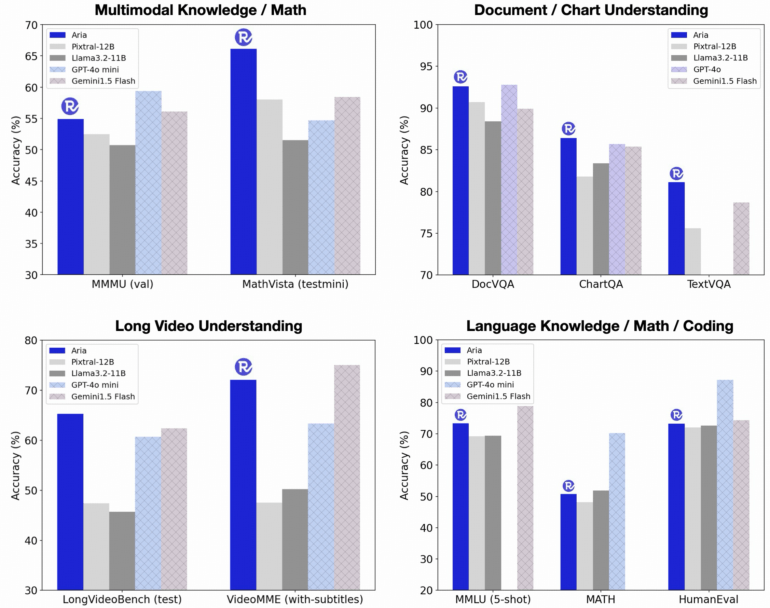

Im Vergleich zu Modellen wie Pixtral-12B und Llama-3.2-11B zeigt Aria laut Benchmarks eine überlegene Leistung bei einer Vielzahl von multimodalen, sprachlichen und Programmieraufgaben, und das bei geringeren Inferenzkosten aufgrund der geringeren Anzahl aktivierter Parameter. Darüber hinaus soll Aria auch mit proprietären Modellen wie GPT-4o und Gemini-1.5 bei verschiedenen multimodalen Aufgaben mithalten können.

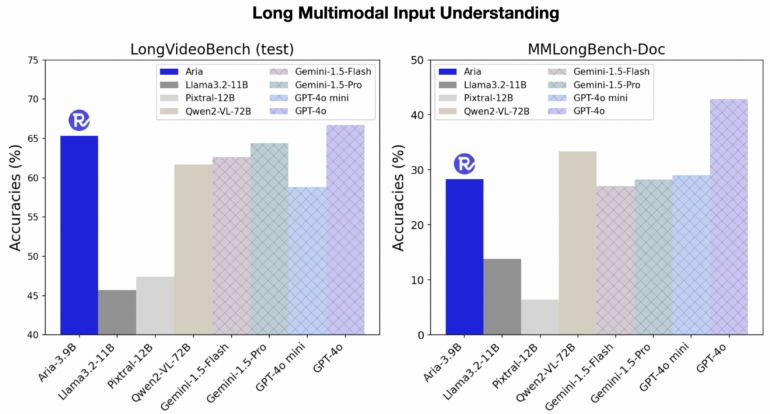

Aria erzielt laut Rhymes AI auch bei langen multimodalen Eingaben wie Videos mit Untertiteln oder mehrseitigen Dokumenten gute Ergebnisse. Im Gegensatz zu anderen Open-Source-Modellen soll Aria lange Videos besser verstehen als GPT-4o mini und lange Dokumente besser als Gemini 1.5 Flash.

Rhymes AI kooperiert mit AMD

Rhymes AI hat den Quellcode von Aria unter der Apache-2.0-Lizenz auf GitHub zur Verfügung gestellt, die sowohl die akademische als auch die kommerzielle Nutzung erlaubt. Um die Einführung zu erleichtern, hat das Unternehmen außerdem ein Trainingsframework veröffentlicht, mit dem sich Aria mit nur einer einzigen GPU auf einer Vielzahl von Datenquellen und -formaten feinabstimmen lässt.

Rhymes AI wurde von ehemaligen Google-KI-Expert:innen gegründet. Ähnliches Ziel wie das einiger anderer aufstrebender KI-Unternehmens ist es, leistungsstarke Modelle zu entwickeln, die für alle zugänglich sind. Das Unternehmen hat 30 Millionen US-Dollar Startkapital erhalten.

Um die Leistung seiner Modelle durch den Einsatz von AMD-Hardware zu optimieren, ist Rhymes AI eine Partnerschaft mit dem Chiphersteller eingegangen. Auf der Konferenz "Advancing AI 2024" von AMD hat Rhymes AI seine für Consumer entwickelte Suchanwendung BeaGo vorgestellt, die auf AMDs MI300X-Beschleuniger läuft und laut Rhymes AI umfassende KI-Suchergebnisse für Text und Bilder liefert.

Video: Rhymes AI

In einem Video vergleicht sich BeaGo mit Perplexity und Gemini. Die aktuell kostenlos für iOS und Android verfügbare App beherrscht neben der Suchmaschinenanbindung aktuell jedoch offenbar nur Text- und englische Spracheingabe. Außerdem schlägt sie KI-Zusammenfassungen zu aktuellen Nachrichten vor und verlinkt dabei auf verschiedene Onlineartikel.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.