Falls ihr noch Videos im Internet glaubt, schaut euch TANGO an

Forscher haben eine neue KI-Methode entwickelt, mit der sich täuschend echte Bewegtbilder zu beliebigen Audioaufnahmen erzeugen lassen. Das könnte die Flut an Fake-Videos im Netz weiter verstärken.

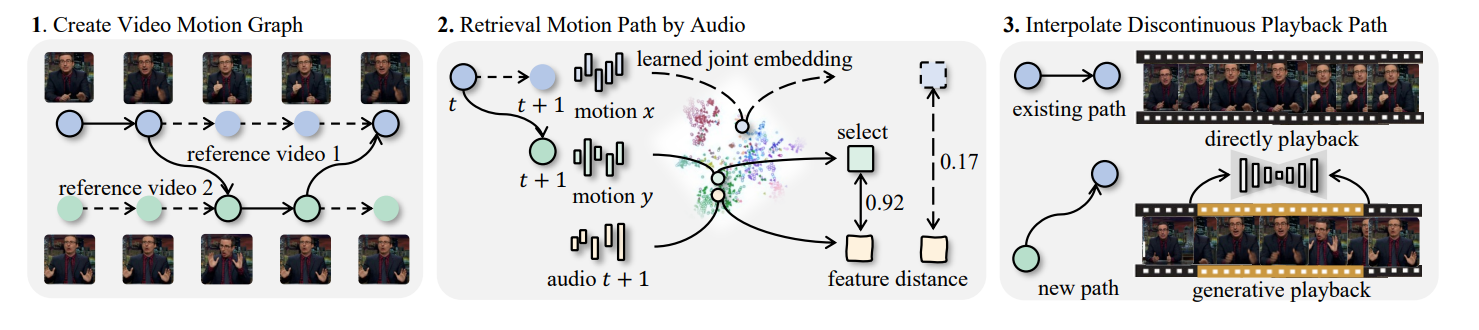

Die Methode funktioniert in drei Schritten und nutzt dabei einen sogenannten "Bewegungsgraphen", der mögliche Übergänge zwischen verschiedenen Körperhaltungen repräsentiert.

Im ersten Schritt werden Referenzvideos einer Person analysiert, um daraus den Bewegungsgraphen zu erstellen. Anschließend wählt das System passende Bewegungssequenzen zu einer Ziel-Audioaufnahme aus. Im letzten Schritt generiert ein KI-Modell fehlende Übergangsbilder, um einen flüssigen Bewegungsablauf zu erzeugen.

Eine Besonderheit von TANGO ist laut den Forschern die Verwendung eines hierarchischen Audio-Bewegungs-Embeddings. Dieses ermögliche es, sowohl kurzfristige als auch längerfristige Zusammenhänge zwischen Sprache und Gestik zu erfassen. Dadurch sollen die generierten Bewegungen besser zur Audioeingabe passen als bei früheren Methoden.

Den Entwicklern zufolge erzielte TANGO in Tests bessere Ergebnisse als bestehende generative und retrieval-basierte Verfahren. Sowohl bei objektiven Metriken als auch in Nutzerstudien habe das System die Vergleichsmethoden übertroffen.

TANGO könnte ein vielversprechender Ansatz sein, um beispielsweise in der Filmproduktion oder für virtuelle Avatare realistisch wirkende Bewegtbilder zu erzeugen. Gleichzeitig könnte die Technologie auch missbraucht werden, um Deepfakes zu erstellen.

Fake-Videos sind nicht mehr aufzuhalten

Angesichts der zunehmenden Einfachheit, mit der sich heute überzeugende Fake-Videos generieren lassen, wird es für Nutzer immer schwieriger, die Echtheit von Online-Inhalten zu überprüfen.

Entsprechend dürften vertrauenswürdige und verifizierte Quellen an Bedeutung gewinnen, anstatt zu versuchen, jedes einzelne Video auf seine Authentizität hin zu überprüfen. Die schiere Menge an potenziellen Fälschungen macht es nahezu unmöglich, alle Fakes zu entlarven.

TANGO verdeutlicht einmal mehr, wie ausgereift die Technologien zur Erstellung synthetischer Medieninhalte mittlerweile sind. Nutzer sollten daher besonders kritisch sein, wenn sie auf vermeintlich authentisches Videomaterial im Internet stoßen - insbesondere wenn die Quelle nicht verifiziert ist.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.