OpenAIs neues KI-Modell "Orion" zeigt angeblich kaum Verbesserungen gegenüber GPT-4

Die Entwicklung von Sprachmodellen scheint ein Plateau erreicht zu haben. Das kommende Sprachmodell Orion von OpenAI soll seinen Vorgänger GPT-4 kaum übertreffen. Die Stagnation bei LLM betrifft die gesamte Branche.

Wie The Information berichtet, zeigt OpenAIs nächstes großes Sprachmodell mit dem Codenamen "Orion" deutlich geringere Leistungsverbesserungen als erhofft. Der Qualitätssprung zwischen GPT-4 und Orion falle wesentlich kleiner aus als der zwischen GPT-3 und GPT-4.

In einigen Bereichen, etwa beim Programmieren, sei Orion nicht einmal durchgängig besser als sein Vorgänger. Lediglich bei Sprachfähigkeiten zeige das Modell Verbesserungen. Zusätzlich könnte der Betrieb von Orion in den Rechenzentren teurer werden als bei bisherigen Modellen.

Mangel an hochwertigen Trainingsdaten

Ein Grund für die Stagnation ist laut OpenAI-Forschern ein Mangel an hochwertigen Trainingsdaten. Die öffentlich verfügbaren Texte und Daten seien weitgehend ausgeschöpft. Als Reaktion darauf hat OpenAI ein "Foundations Team" unter der Leitung von Nick Ryder gegründet, berichtet The Information.

Diese Beschreibung passt zu einer Aussage von Altman im Sommer, dass zwar genügend Daten vorhanden sind, es aber in Zukunft darum gehen wird, aus weniger Daten mehr zu lernen. Dabei sollen auch synthetische Daten, also von einem KI-Modell generierte Trainingsdaten, helfen.

Das kommende Modell Orion wurde laut The Informaton bereits teilweise mit synthetischen Daten von GPT-4 und OpenAIs neuem "Logik"-Modell o1 trainiert. Das berge aber auch die Gefahr, dass das neue Modell die alten Modelle teilweise nachahmt.

LLM-Stagnation stellt die Branche vor eine Herausforderung

Die Stagnation beschränkt sich nicht auf OpenAI. Laut The Verge bleibt auch Googles kommendes Gemini 2.0 hinter den internen Erwartungen zurück. Anthropic hat angeblich die Entwicklung seiner Version 3.5 des Flaggschiffmodells Opus vorerst auf Eis gelegt und stattdessen ein verbessertes Sonnet veröffentlicht, möglicherweise aus Sorge, die Erwartungen von Nutzern und Investoren zu enttäuschen.

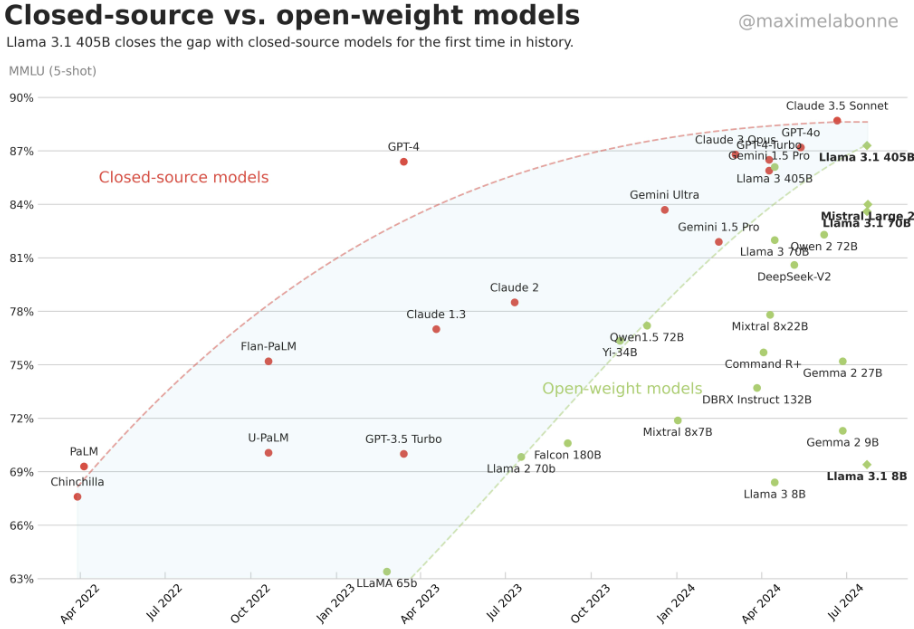

Dass große Sprachmodelle stagnieren, zeigt sich auch daran, dass Open-Source-Modelle in den vergangenen 1,5 Jahren zu den mit Milliarden finanzierten proprietären Modellen aufschließen konnten. Das wäre kaum möglich gewesen, hätten die großen Tech-Konzerne ihre massiven Investitionen effektiv in mehr KI-Leistung umsetzen können.

Trotz dieser Entwicklung gibt sich OpenAI-CEO Sam Altman in einem aktuellen Interview zuversichtlich. Der Pfad zur künstlichen allgemeinen Intelligenz (AGI) sei im Grunde klar. Eine wichtige Aufgabe sei es, bestehende Modelle kreativ zu nutzen. Altman könnte sich hier auf die Verbindung von LLMs, Reasoning-Ansätzen wie o1 und agentischer KI beziehen.

Laut Noam Brown, renommierter KI-Entwickler bei OpenAI, zuvor bei Meta, und einer der Köpfe hinter o1, ist Altmans Aussage kein Hype, sondern entspricht der Mehrheitsmeinung der OpenAI-Forscher.

Speziell das neue o1-Modell soll einen neuen Skalierungshorizont schaffen. Hier wird die Rechenleistung nicht mehr hauptsächlich für das Training verwendet, sondern für die Rechenzeit, die das KI-Modell benötigt, um eine Aufgabe zu lösen, die sogenannte Inferenz.

Brown geht davon aus, dass dieses neue Skalierungsprinzip weit tragen wird. Es wird aber auch Milliarden kosten und viel Energie verbrauchen. Eine der Kernfragen der KI-Branche wird daher sein, ob die Entwicklung immer leistungsfähigerer KI-Modelle und damit der Bau riesiger Rechenzentren ökonomisch und ökologisch sinnvoll ist. OpenAI scheint davon überzeugt zu sein.

Grundlegende Kritik an der LLM-Entwicklung

Der Google-KI-Experte François Chollet hingegen übt auf X derweil grundlegende Kritik an der reinen Skalierung von Sprachmodellen für mathematische Aufgaben. Er bezeichnet es als "besonders stumpfsinnig", wenn Fortschritte bei mathematischen Benchmarks als Beweis für künstliche allgemeine Intelligenz (AGI) angeführt werden.

Laut Chollet zeigen die empirischen Daten vielmehr, dass Deep Learning im Allgemeinen und große Sprachmodelle im Besonderen nicht eigenständig mathematische Probleme lösen können. Stattdessen seien dafür diskrete Suchmethoden notwendig.

Statt wie ein Sprachmodell zu "raten", welche Antwort wahrscheinlich richtig sein könnte, navigiert ein diskreter Suchalgorithmus systematisch durch einen klar definierten Lösungsraum und prüft verschiedene Lösungswege, bis er die korrekte Lösung findet.

Der KI-Forscher kritisiert auch, dass der Begriff "LLM" zunehmend als Marketingbegriff für alle aktuellen KI-Fortschritte missbraucht wird, obwohl viele dieser Fortschritte gar nichts mit Sprachmodellen zu tun hätten.

So sei etwa die Integration von Gemini in Google Deepminds AlphaProof "im Wesentlichen kosmetischer Natur und für Marketingzwecke" erfolgt.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.