Coconut: Meta-Forscher entwickeln ein Sprachmodell, das ohne Sprache denkt

Ein Forschungsteam von Meta und der UC San Diego hat eine neue KI-Methode namens "Coconut" entwickelt, die es Sprachmodellen ermöglicht, in einem kontinuierlichen Raum statt in natürlicher Sprache zu denken. Die Ergebnisse zeigen deutliche Vorteile gegenüber herkömmlichen Methoden.

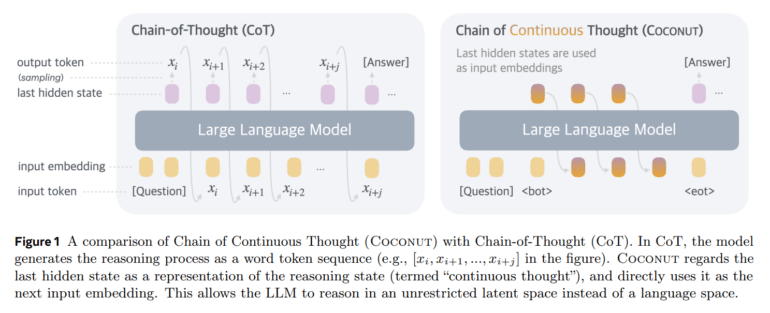

Ein Team von Forschern der UC San Diego und Meta hat eine neue Methode entwickelt, die es großen Sprachmodellen ermöglicht, ohne den "Umweg" über natürliche Sprache zu denken. Die als "Coconut" (Chain of Continuous Thought) bezeichnete Technik lässt KI-Modelle in einem kontinuierlichen mathematischen Raum operieren.

Laut der Studie funktioniert Coconut ähnlich wie die bekannte Chain-of-Thought-Methode, bei der KI-Modelle Schritt für Schritt in natürlicher Sprache denken. Der entscheidende Unterschied: Statt Gedankenschritte in Worten auszudrücken, arbeitet das System mit mathematischen Vektoren.

"Die meisten Wörter in einer Gedankenkette dienen nur der sprachlichen Kohärenz und sind für das eigentliche Denken nicht wesentlich", erklären die Forscher in ihrer Studie. Gleichzeitig erfordern einige kritische Wörter komplexe Planung und stellen große Herausforderungen für KI-Modelle dar.

Bessere Ergebnisse bei komplexen Aufgaben

Die Forscher testeten Coconut auf drei verschiedenen Aufgabentypen und verglichen die Ergebnisse direkt mit der etablierten Chain-of-Thought (CoT) Methode. Bei mathematischen Textaufgaben (GSM8k) erreichte Coconut 34,1 Prozent Genauigkeit und lag damit zwar unter CoT (42,9 Prozent), aber deutlich über der Baseline ohne Gedankenketten (16,5 Prozent).

Bei logischen Schlussfolgerungen zeigte sich jedoch ein anderes Bild: Im ProntoQA-Test, bei dem KI-Systeme logische Verbindungen zwischen Konzepten herstellen müssen, erreichte Coconut eine Genauigkeit von 99,8 Prozent und übertraf damit CoT (98,8 Prozent). Noch deutlicher war der Vorsprung beim neu entwickelten ProsQA-Test, der besonders viel Planungsfähigkeit erfordert: Hier erreichte Coconut 97 Prozent, während CoT nur auf 77,5 Prozent kam.

Coconut benötigte dabei deutlich weniger Tokens als CoT - bei ProntoQA nur 9 statt 92,5 Tokens und bei ProsQA 14,2 statt 49,4 Tokens. Diese Ergebnisse zeigen, dass die neue Methode vor allem bei komplexen logischen Aufgaben nicht nur genauer, sondern auch wesentlich effizienter arbeitet als traditionelle Ansätze.

Die Forscher stellten außerdem fest, dass das System in der Lage ist, mehrere mögliche nächste Denkschritte parallel zu verarbeiten und so vor der Token-Generierung schrittweise die falschen Optionen auszuschließen.

Training bleibt eine Herausforderung

Die Experimente zeigten aber auch Grenzen auf: Ohne spezielle Trainingsmethoden lernte das System nicht, effektiv im kontinuierlichen Raum zu denken. Für ihre Studie nutzten die Wissenschaftler ein vortrainiertes GPT-2-Modell als Grundlage. Sie entwickelten ein mehrstufiges Trainingscurriculum, bei dem auf jeder Stufe eine bestimmte Anzahl kontinuierlicher Gedanken integriert und im Gegenzug ein sprachlicher Denkschritt entfernt wurde. Mit fortschreitender Trainingsstufe erhöhte sich so der Anteil des latenten Denkens, während die sprachliche Argumentation schrittweise reduziert wurde.

Die Ergebnisse weisen nach Ansicht der Forscher auf ein erhebliches Potenzial für die Weiterentwicklung von KI-Systemen hin. "Coconut zeigt, dass Denken im kontinuierlichen Raum die Fähigkeiten großer Sprachmodelle deutlich verbessern kann", schreiben die Autoren in ihrer Studie. Besonders vielversprechend sei die Beobachtung, dass das System selbstständig effektive Denkmuster entwickelt hat, die einer Breitensuche ähneln, ohne explizit darauf trainiert worden zu sein.

Für die Zukunft sehen die Forscher vor allem im Vortraining (Pretraining) größerer Sprachmodelle mit kontinuierlichen Gedanken ein großes Potenzial. Dadurch könnten die Modelle ihre Denkfähigkeiten auf ein breiteres Aufgabenspektrum übertragen. Auch wenn die aktuelle Version von Coconut noch auf bestimmte Aufgabentypen beschränkt ist, sind die Forscher überzeugt, dass ihre Erkenntnisse den Weg für fortschrittlichere Systeme des maschinellen Denkens ebnen werden.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.