Allgemeine Künstliche Intelligenz ist laut Metas KI-Chef Yann LeCun noch Jahre entfernt

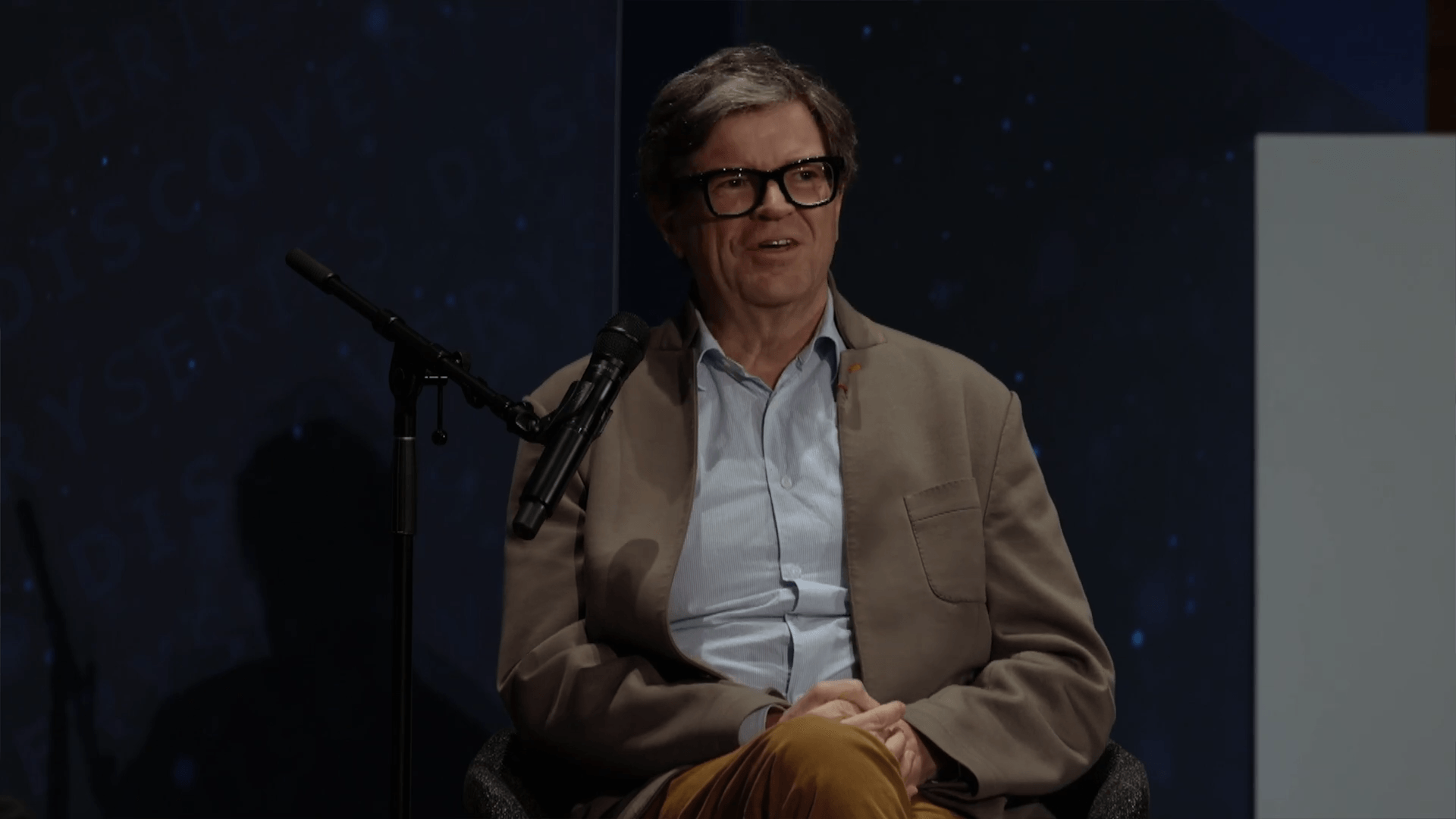

Yann LeCun, Chief AI Scientist bei Meta, dämpft die Erwartungen an eine baldige allgemeine künstliche Intelligenz. Der Weg zur menschenähnlichen KI führe nicht über große Sprachmodelle.

Yann LeCun, Chief AI Scientist bei Meta, hält die Entwicklung einer Künstlichen Allgemeinen Intelligenz (AGI) für ein Fernziel. Wie LeCun in einer Diskussionsrunde am Johns Hopkins Bloomberg Center erklärte, sei man "sehr weit von AGI entfernt" - zwar nicht Jahrhunderte oder Jahrzehnte, aber definitiv mehrere Jahre.

Seine Aussage folgt auf die jüngste Vorstellung des KI-Modells o3 von OpenAI, dem von einem kleinen Teil der KI-Gemeinschaft bereits AGI-Fähigkeiten zugeschrieben werden, da es in Mathematik- und Programmiertests überdurchschnittlich gut abschneidet.

Die Debatte wird dadurch erschwert, dass es keine einheitliche Definition von AGI gibt. Während einige Experten darunter eine menschenähnliche, generalisierbare Intelligenz verstehen, definieren Unternehmen wie OpenAI AGI als den Punkt, an dem KI-Systeme einen Großteil menschlicher Arbeit automatisieren können.

Beobachtungslernen statt Textanalyse

Nach Ansicht des Meta-Forschers stößt die Entwicklung von Large Language Models (LLMs) an ihre Grenzen, da nicht mehr genügend natürliche Textdaten zur Verfügung stehen. Diese Ansicht vertritt LeCun schon seit Jahren.

Selbst prominente Verfechter des textbasierten Ansatzes hätten ihre Meinung geändert, so LeCun. So haben OpenAIs früherer Chefforscher Ilya Sutskever zu jenen gehört, die in der Skalierung von Textmodellen den Weg zu genereller KI sahen. "Ilya war bekanntermaßen ein Verfechter dieses Konzepts und ist es jetzt offenbar nicht mehr", sagt LeCun.

Er verweist darauf, dass ein vierjähriges Kind in 16.000 Wachstunden etwa die gleiche Datenmenge visuell verarbeitet wie die größten Sprachmodelle in Form von Text. Meta sammelt bereits in Forschungsprojekten große Mengen an Videodaten, die Interaktionen im Kontext der Umgebung dokumentieren.

"Wir werden nie eine menschenähnliche KI erreichen, wenn wir nur mit Text trainieren. Wir müssen mit sensorischen Inputs trainieren", betont LeCun. Als Beweis führt er an, dass es keine funktionierenden Haushaltsroboter gibt - nicht wegen mangelnder Robotertechnologie, sondern wegen mangelnder KI-Intelligenz.

Zudem benötigten die Systeme laut LeCun Emotionen, um Ziele zu verfolgen und die Konsequenzen ihrer Handlungen einschätzen zu können. Dies sei ein "untrennbarer Bestandteil ihres Designs" und Teil von Metas KI-Vision für die Zukunft. Ebenso seien ein Weltmodell und die Fähigkeit zur Schlussfolgerung und Planung erforderlich.

Weniger Sorgen um KI-Missinformation

Die Gefahr von KI-generierter Desinformation sieht LeCun gelassen. KI sei nicht das Werkzeug, das Hassrede und Desinformation ermöglicht, sondern die beste Gegenmaßnahme. Die "Guten" müssten lediglich bessere KI-Systeme haben als die "Bösen".

Dass OpenAI schon mit GPT-2 vor "gefährlicher KI" für Fake News warnte und das Modell damals mit dieser Begründung nicht veröffentlichte, bezeichnet LeCun als "lächerlich" für die damalige Zeit, da die Fähigkeiten des Modells bescheiden gewesen wären. Ähnliche Systeme seien nun seit Jahren im Umlauf, heute noch viel mächtiger, und es sei nichts Schlimmes passiert.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.