Mistral veröffentlicht LLM Small 3 unter Apache-Lizenz und kündigt Reasoning-Modell an

Das Sprachmodell Mistral Small 3 erreicht in Benchmarks ähnliche Leistungen wie größere Modelle von Meta, Qwen und OpenAI. Mit der Veröffentlichung steigt Mistral auf die Apache-2.0-Lizenz um, die Nutzer:innen mehr Freiheiten einräumt.

Das französische KI-Startup Mistral AI hat mit Small 3 ein neues Sprachmodell mit 24 Milliarden Parametern veröffentlicht. Das Modell wurde laut Mistral für eine geringe Latenz optimiert und eignet sich damit besonders für den lokalen Einsatz. Die vorangegangene Version erschien im September 2024.

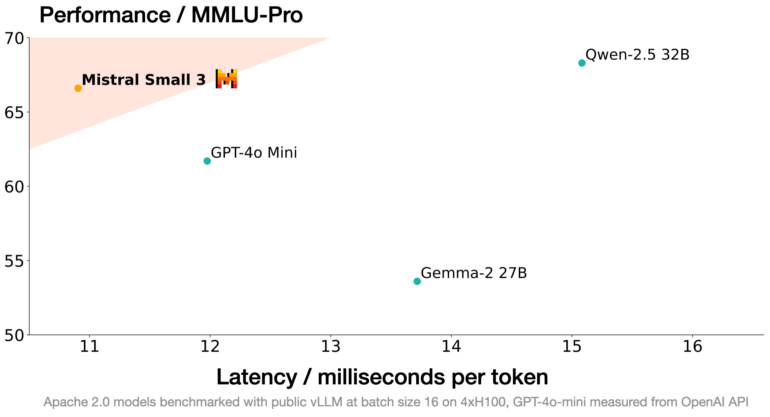

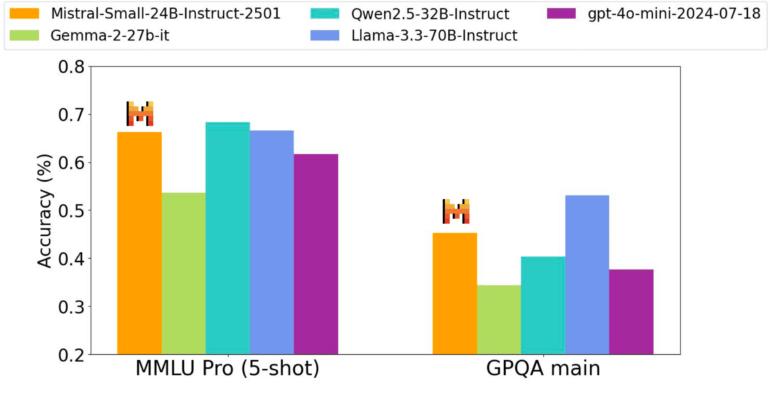

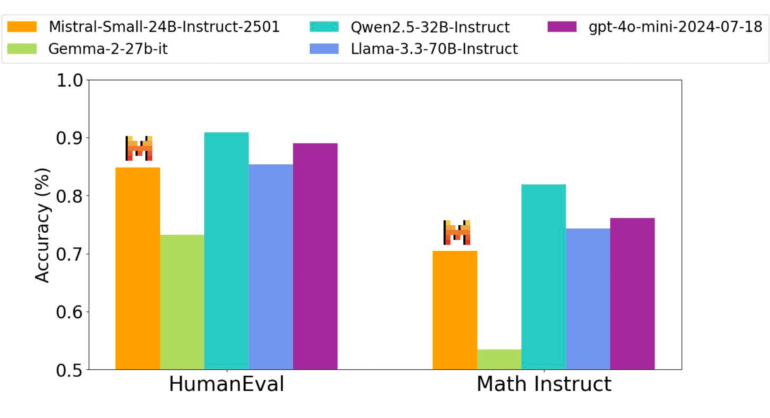

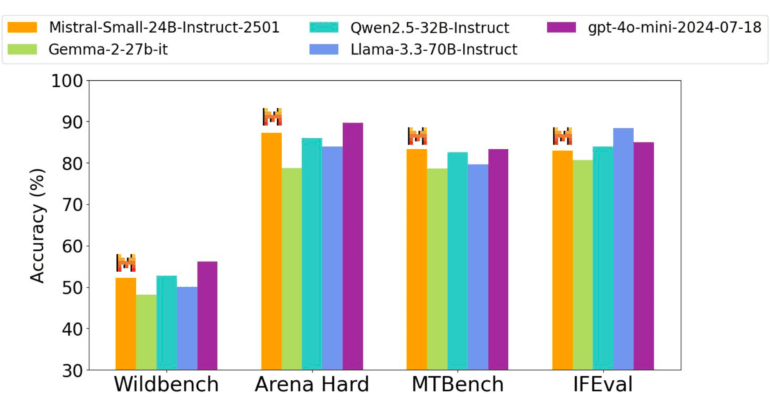

In Benchmarks erreichte Mistral Small 3 trotz der geringeren Parameterzahl ähnliche Ergebnisse wie die teilweise drei Mal so großen Modelle Llama-3.3-70B von Meta, Qwen2.5-32B und GPT-4o-mini. Auch in Evaluierungen durch externe Gutachter:innen mit Coding- und allgemeinen Prompts schnitt es laut Angaben von Mistral gut ab.

Bei Instruktionsaufgaben war die Leistung von Mistral Small 3 mit Qwen2.5-32B-Instruct, Llama-3.3-70B-Instruct und Gemma-2-27B-IT vergleichbar. Beim Pretraining zeigte es in seiner Größenklasse ebenfalls eine Leistung auf dem Niveau von Llama-3.3-70B.

Mit einer Genauigkeit von 81 Prozent bei MMLU und einer Latenz von 150 Token pro Sekunde ist Mistral Small 3 laut Mistral aktuell eines der effizientesten Modelle dieser Kategorie.

Verschiedene Anwendungsmöglichkeiten in Unternehmen und für Entwickler

Mistral sieht für das Modell Einsatzmöglichkeiten wie schnelle Antworten in Chats, Funktionsaufrufe, das Finetuning für spezifische Domänen sowie die lokale Inferenz auf einzelnen GPUs.

Unternehmen aus den Bereichen Finanzen, Gesundheitswesen, Robotik und Fertigung evaluieren Mistral Small 3 bereits für Anwendungen wie Betrugserkennung, Kundensupport oder Sentiment-Analyse. Entwickler:innen können das Modell als Basis für eigene Anpassungen und zur Integration von Reasoning-Fähigkeiten nutzen.

Mistral Small 3 kann ab sofort unter der Apache-2.0-Lizenz auf der Plattform von Mistral sowie bei Partnern wie Hugging Face, Ollama, Kaggle, Together AI und Fireworks AI heruntergeladen werden. Die Unterstützung weiterer Plattformen ist in Planung.

Umstellung von MRL- auf Apache-Lizenz und geplante Weiterentwicklungen

Mit Mistral Small 3 vollzieht Mistral bei seinen allgemeinen Sprachmodellen einen Wechsel von der bisher verwendeten, proprietären MRL-Lizenz (Mistral Research License) zur freien Apache-2.0-Lizenz. Damit sind die Modelle auch für kommerzielle Anwendungen frei nutzbar, modifizierbar und weiterverteilbar. Für spezielle Anforderungen will das Unternehmen weiterhin kommerzielle Modelle anbieten.

Für die kommenden Wochen kündigt Mistral die Veröffentlichung weiterer kleiner und großer Modelle mit verbesserten Reasoning-Fähigkeiten an.

Mistral Small 3 versteht sich als Ergänzung zu größeren Open-Source-Modellen mit Reasoning-Fähigkeiten, wie sie zuletzt etwa von Deepseek veröffentlicht wurden. Es kann als Basis dienen, um ähnliche Fähigkeiten mit effizienteren Architekturen in kleineren Modellen zu realisieren.

Über die letzten Monate hat sich Mistral als wichtiger europäischer Vertreter von quelloffener KI-Entwicklung etabliert. Zwar sind die Modelle bisher nicht ganz auf Niveau eines omnimodalen GPT-4o, nach Veröffentlichung von Pixtral, seinem ersten Sprachmodell mit Bildverständnis, scheint das Start-up aber auf einem guten Weg. Diese Neuerungen sind nicht nur für Entwickler:innen spannend, über den Chatbot Le Chat finden die Modelle auch ihren Weg zu Endnutzer:innen.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.