Chain of Draft-Prompt: KI-Modelle mit weniger Wörtern schneller denken lassen

Mit "Chain of Draft" (CoD) haben Forschende eine Methode vorgestellt, die es KI-Modellen ermöglicht, komplexe Aufgaben mit deutlich weniger Worten und höherer Geschwindigkeit zu lösen als bisher - angeblich ohne Einbußen bei der Genauigkeit.

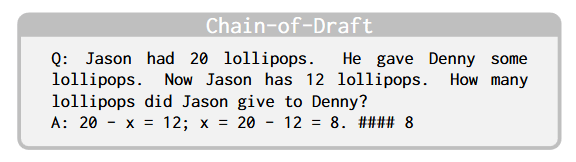

CoD generiert dafür minimale, aber informative Zwischenergebnisse und löst Aufgaben mit bis zu 92,4 Prozent weniger Wörtern als mit der vergleichbaren Chain of Thought-Methode, ohne an Genauigkeit zu verlieren. Die Inspiration dafür: Statt jeden Gedankenschritt ausführlich auszuformulieren, halten Menschen oft nur das Wesentliche in Stichpunkten fest. CoD ahmt genau das nach.

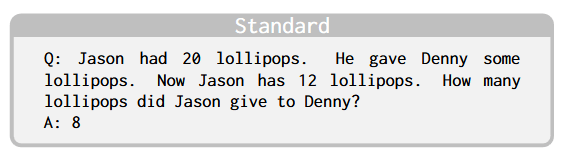

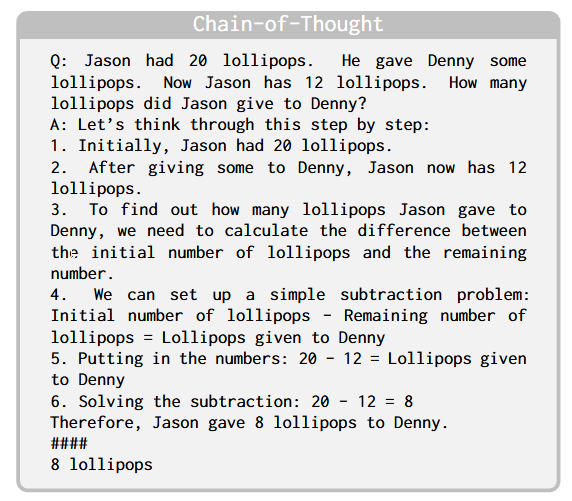

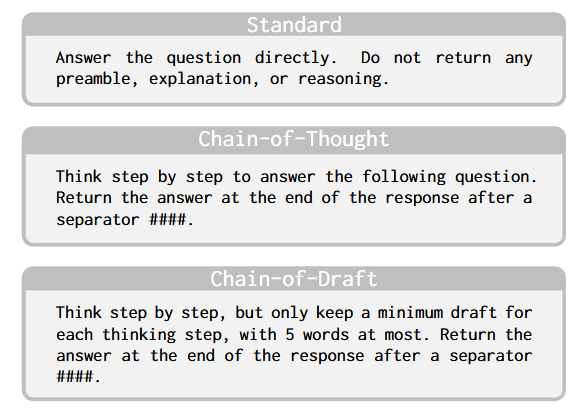

Während der getestete Prompt in allen drei Beispielen derselbe ist, liegt der Unterschied im Systemprompt. Für CoD wurde ein Chain-of-Thought (CoT)-Prompt modifiziert und das Modell angewiesen, maximal fünf Wörter pro Schritt aufzunehmen.

Kurze Denk-Prompts erzielen ähnliche Ergebnisse wie ausführliche

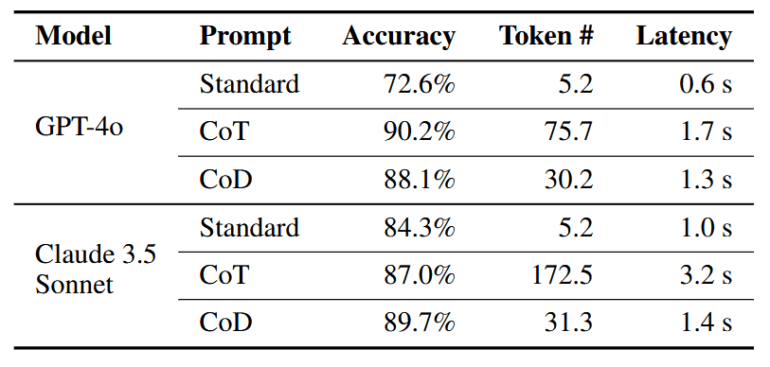

Die Forscherinnen und Forscher verglichen CoD mit ausführlichen CoT-Prompts und Standard-Prompts ohne Erklärungen. Bei arithmetischen Aufgaben, Verständnistests und symbolischen Schlussfolgerungen erzielte CoD eine ähnliche Genauigkeit wie CoT, benötigte aber 68 bis 86 Prozent weniger Wörter.

Im Vergleich zu Standard-Prompts, bei denen das Modell die Antwort ohne zusätzliche Denkschritte direkt ausgibt, stieg die Genauigkeit beispielsweise bei Verständnisaufgaben zu Datumsangaben von 72,6 auf 88,1 Prozent (GPT-4o) bzw. von 84,3 auf 89,7 Prozent (Claude 3.5 Sonnet).

Weniger Rechenzeit und Kosten durch CoD

Chain of Draft reduziert direkt die Anzahl der Output-Token, da das Modell kürzere Zwischenschritte in der Argumentation erzeugt. Darüber hinaus kann es in bestimmten Situationen indirekt die Anzahl der Eingabe-Token reduzieren, insbesondere wenn mit Beispiellösungen in Prompts gearbeitet wird. Wenn diese Beispiele im Chain-of-Draft-Format erstellt werden, wird jedes Beispiel kürzer.

Diese kombinierte Reduzierung von Eingabe- und Ausgabetoken senkt die Rechenkosten und ermöglicht schnellere Antworten, was CoD für große LLM-Implementierungen und Anwendungen mit begrenztem Budget interessant macht.

Allerdings eignen sich kompakte Prompts nicht für jede Aufgabe. Manche erforderten längere Überlegungen, Selbstkorrekturen oder den Zugriff auf externes Wissen.

Hier sehen die Forschenden Potenzial, CoD mit Ansätzen wie adaptivem parallelem Schlussfolgern oder mehrstufiger Validierung zu kombinieren. Die Erkenntnisse könnten auch das Training von KI-Modellen beeinflussen, indem kompakte Denkvorgänge als Trainingsdaten dienen.

Die Chain-of-Draft-Methode hat ein Forschungsteam von Zoom Communications, dem Hersteller der gleichnamigen Videokonferenzsoftware entwickelt. Schon seit 2023 bietet das Tool einen "AI Companion", der Meetings virtuell begleitet, Zusammenfassungen und Vorschläge liefern kann. Gerade die Latenz, also die benötigte Zeit bis zur fertigen Antwort, sei bis jetzt häufig ignoriert worden. In Echtzeitsituationen wie Videotelefonaten könnte Chain-of-Draft in Zukunft eine Rolle spielen.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.