Wie "Der kleine Prinz" und KI dabei helfen, Sprachentwicklung im Gehirn besser zu verstehen

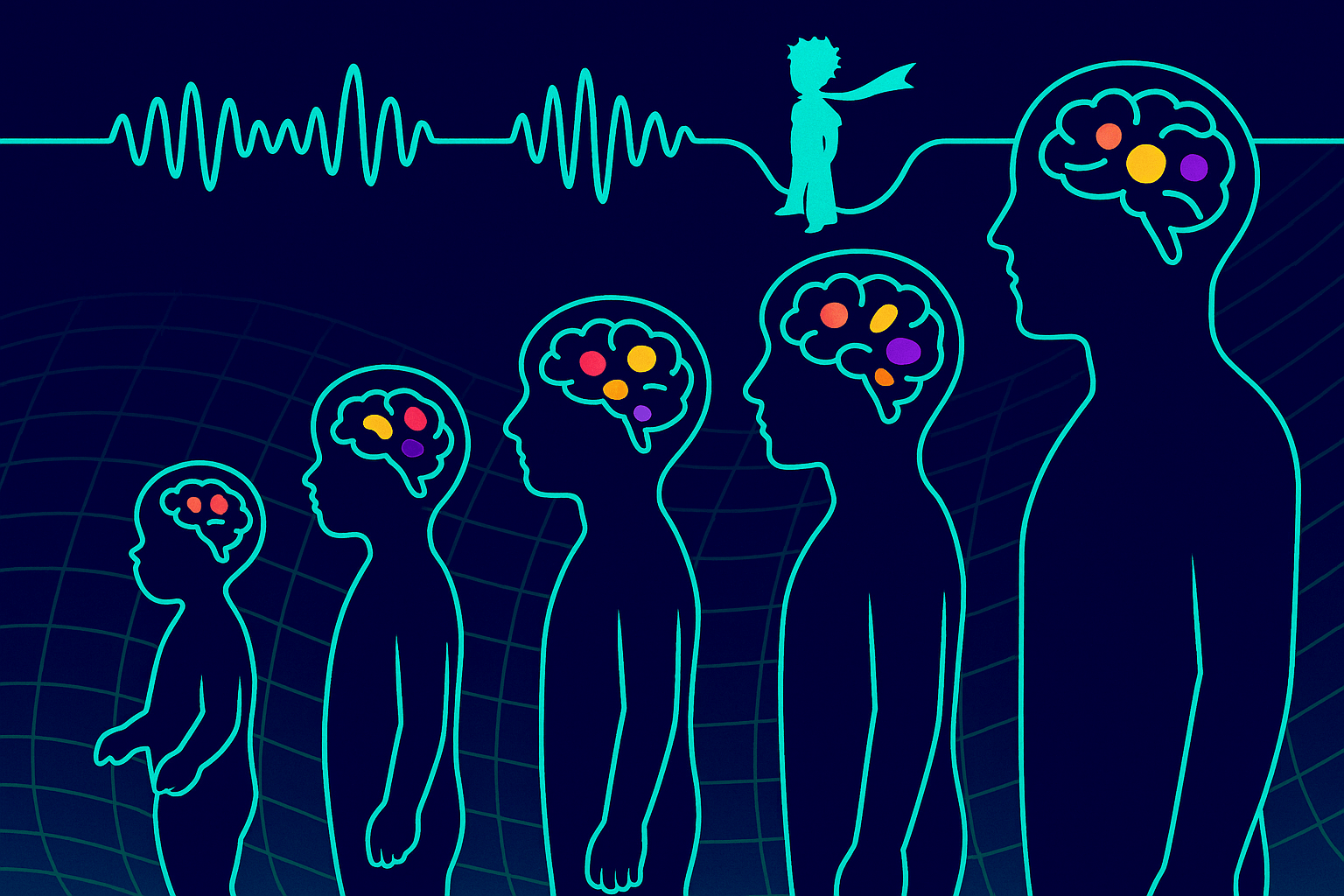

Ein Forschungsteam von Meta und französischen Kliniken hat neuronale Sprachrepräsentationen bei Kindern untersucht – und zeigt, dass KI-Modelle ähnliche Lernverläufe durchlaufen wie das menschliche Gehirn.

Kinder benötigen nur wenige Millionen Wörter, um Sprache zu lernen. Die neuronalen Mechanismen dahinter sind bislang jedoch kaum verstanden. Eine neue Studie von Meta AI und dem Pariser Rothschild Hospital liefert nun Hinweise auf die Entwicklung sprachlicher Repräsentationen im Gehirn – und zeigt dabei überraschende Parallelen zu großen KI-Sprachmodellen.

Die Forscher untersuchten die Gehirnaktivität von 46 französischsprachigen Personen im Alter von 2 bis 46 Jahren. Alle Probanden hatten im Rahmen einer Epilepsiebehandlung Elektroden im Gehirn implantiert. Während die Teilnehmenden einem Hörbuch von „Der kleine Prinz“ lauschten, wurden über 7.400 Elektroden ausgelesen. Ziel war es, herauszufinden, wie sich Sprachverarbeitung im Gehirn entwickelt.

Die Ergebnisse zeigen: Bereits bei Kleinkindern zwischen zwei und fünf Jahren zeigten sich dabei erkennbare Reaktionen auf Sprache – etwa auf Laute wie „b“ oder „k“. Diese Reaktionen traten in bestimmten Hörzentren des Gehirns auf und waren zeitlich klar strukturiert. Die Verarbeitung von ganzen Wörtern, also deren Bedeutung oder Grammatik, zeigte sich dagegen erst bei älteren Kindern – und in anderen, weiterentwickelten Bereichen des Gehirns.

Mit zunehmendem Alter breiten sich diese Sprachverarbeitungen auf größere Teile des Gehirns aus. Die Reaktionen auf Wörter setzten früher ein, dauerten länger und waren stärker ausgeprägt – ein Zeichen dafür, dass die Sprachverarbeitung mit der Zeit immer komplexer wird.

KI-Modelle lernen Sprache wie das menschliche Gehirn – zumindest teilweise

Um besser zu verstehen, wie sich diese Repräsentationen entwickeln, verglichen die Forscher die neuronalen Daten mit den Aktivierungen zweier Sprachmodelle: wav2vec 2.0 – ein KI-Modell, das aus Audiosignalen Sprachmerkmale lernt – und dem großen Sprachmodell Llama 3.1. Beide Modelle wurden vor und nach dem Training untersucht.

Das Ergebnis: Nach dem Training glichen die Reaktionen der Modelle stärker denen im menschlichen Gehirn. Besonders wav2vec, das mit Ton gelernt hatte, zeigte eine stufenweise Verarbeitung – erst einfache Laute, dann komplexere Bedeutungen. Llama 3.1 hingegen arbeitete von Anfang an mit ganzen Wörtern, ähnlich wie das Gehirn von älteren Kindern und Erwachsenen.

Die Repräsentationen von Llama 3.1 finden sich laut dem Team nur im Gehirn von älteren Kindern und Erwachsenen. Bei Kleinkindern (2–5 Jahre) lassen sich diese Repräsentationen nicht nachweisen – vergleichbar mit dem frühen Zustand eines untrainierten Modells. Erst mit zunehmender Sprachexposition lassen sich LLM-ähnliche Aktivierungen im Gehirn beobachten.

Die Studienautoren - darunter Metas Jean-Rémi King - schließen daraus, dass sich die Entwicklung der Sprachverarbeitung im Gehirn und die Reifung von Sprachmodellen durch Training strukturell ähneln. Beide Systeme – biologisch und künstlich – scheinen eine vergleichbare Hierarchie sprachlicher Repräsentationen auszubilden, auch wenn LLMs dafür deutlich mehr Daten benötigen.

Biologie bleibt effizienter – aber KI hilft beim Verständnis

Trotz dieser Parallelen bleiben klare Unterschiede: Während Kinder mit wenigen Millionen Wörtern Sprache erwerben, benötigen LLMs Milliarden. Zudem bleiben viele kognitive Fähigkeiten der KI verschlossen – etwa das Verständnis syntaktischer Abhängigkeiten oder semantischer Nuancen.

Dennoch zeigen die Ergebnisse, dass KI-Modelle dabei helfen können, die Entwicklung von Sprache im menschlichen Gehirn besser zu erforschen. Sie bieten eine neue Möglichkeit, Sprachverarbeitung über viele Altersstufen hinweg nachzuvollziehen – und ihre inneren Abläufe mit denen künstlicher Systeme zu vergleichen.

Eine wichtige Einschränkung: Kinder unter zwei Jahren konnten aus medizinischen Gründen nicht einbezogen werden – obwohl gerade diese frühen Lebensmonate für den Spracherwerb besonders wichtig sind.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.