GLM-4.5: China-Start-up Zhipu AI setzt mit Open-Source-Sprachmodell neue Maßstäbe

Das chinesische KI-Unternehmen Zhipu AI hat mit GLM-4.5 und GLM-4.5V neue Open-Source-Sprachmodelle vorgestellt. Die Modelle sollen logisches Denken, Programmierung und agentische Aufgaben vereinen.

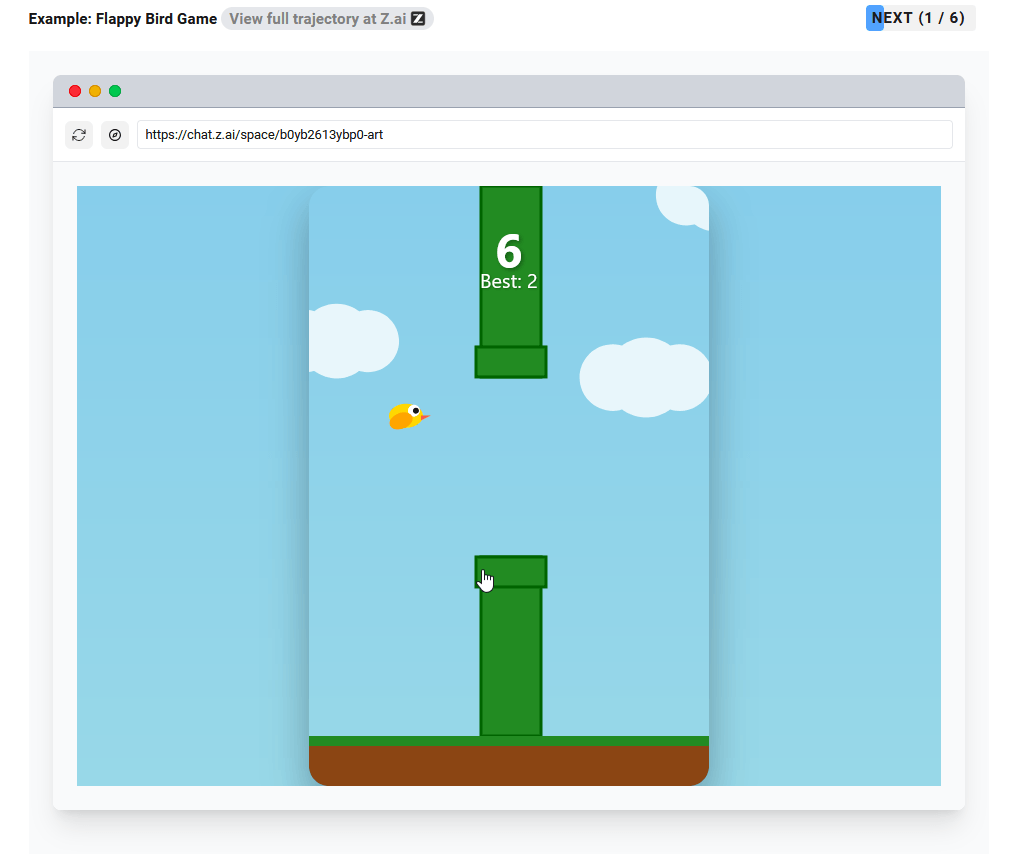

Zhipu AI zeigt konkrete Beispiele für die praktischen Fähigkeiten seiner neuen Modell-Familie: Das System kann interaktive Mini-Games und Physik-Simulationen erstellen, Präsentationsfolien mit autonomer Web-Suche generieren und vollständige Web-Anwendungen mit Frontend, Backend und Datenbank entwickeln.

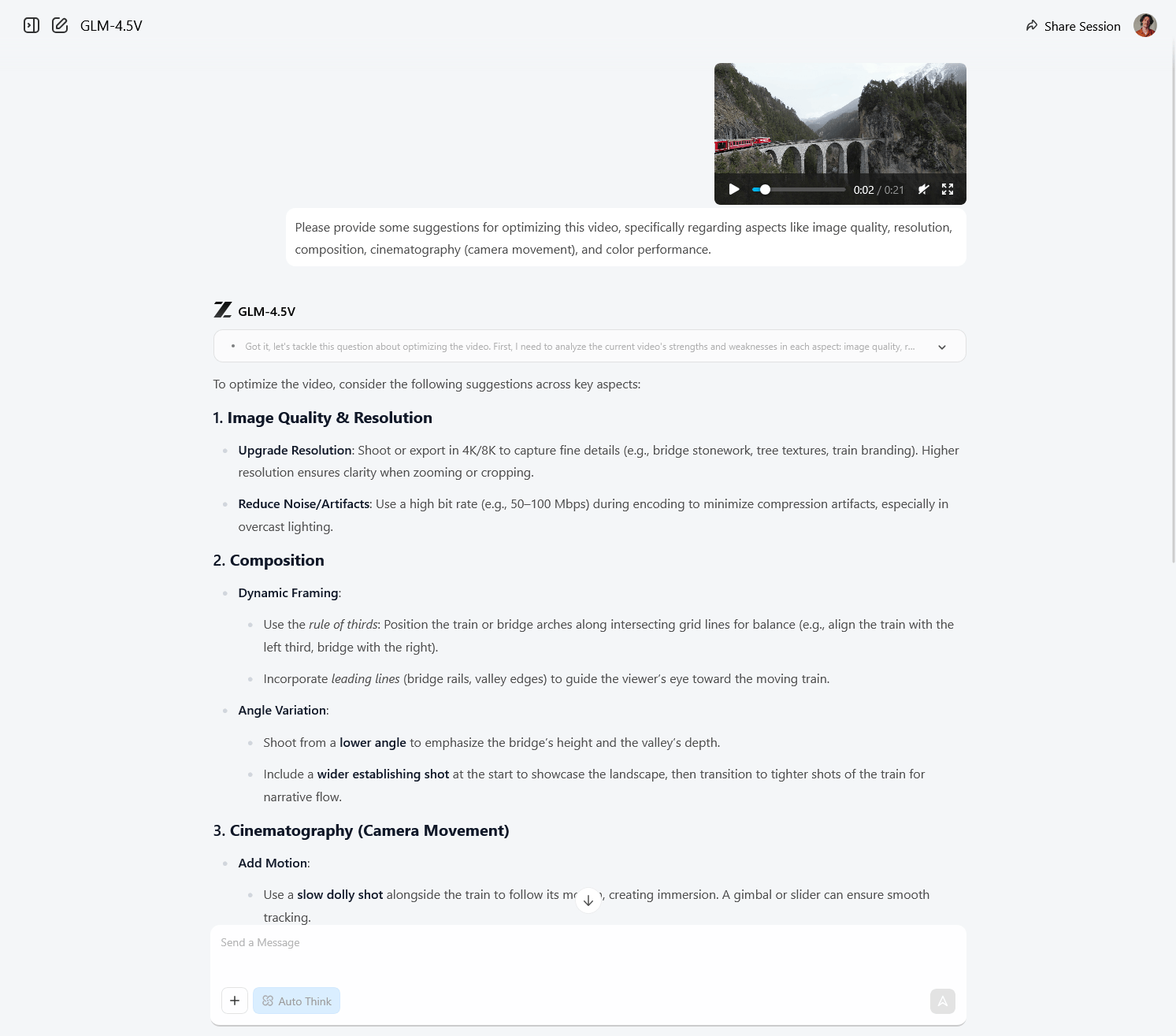

Die multimodale Version GLM-4.5V erweitert diese Fähigkeiten um Bild- und Video-Analyse, kann Webseiten aus Screenshots nachbauen und Bildschirm-Operationen für autonome Agenten durchführen. Das lässt sich in der ChatGPT-ähnlichen Oberfläche chat.z.ai nach Log-in kostenfrei ausprobieren.

Das Unternehmen veröffentlicht insgesamt drei Varianten: GLM-4.5, die kompaktere Version GLM-4.5-Air und das multimodale GLM-4.5V. Alle Modelle bieten einen Hybrid-Ansatz mit zwei Modi: einen "Denk-Modus" für komplexe Aufgaben mit ausführlicher Begründung sowie einen "Schnellantwort-Modus" für sofortige Ergebnisse.

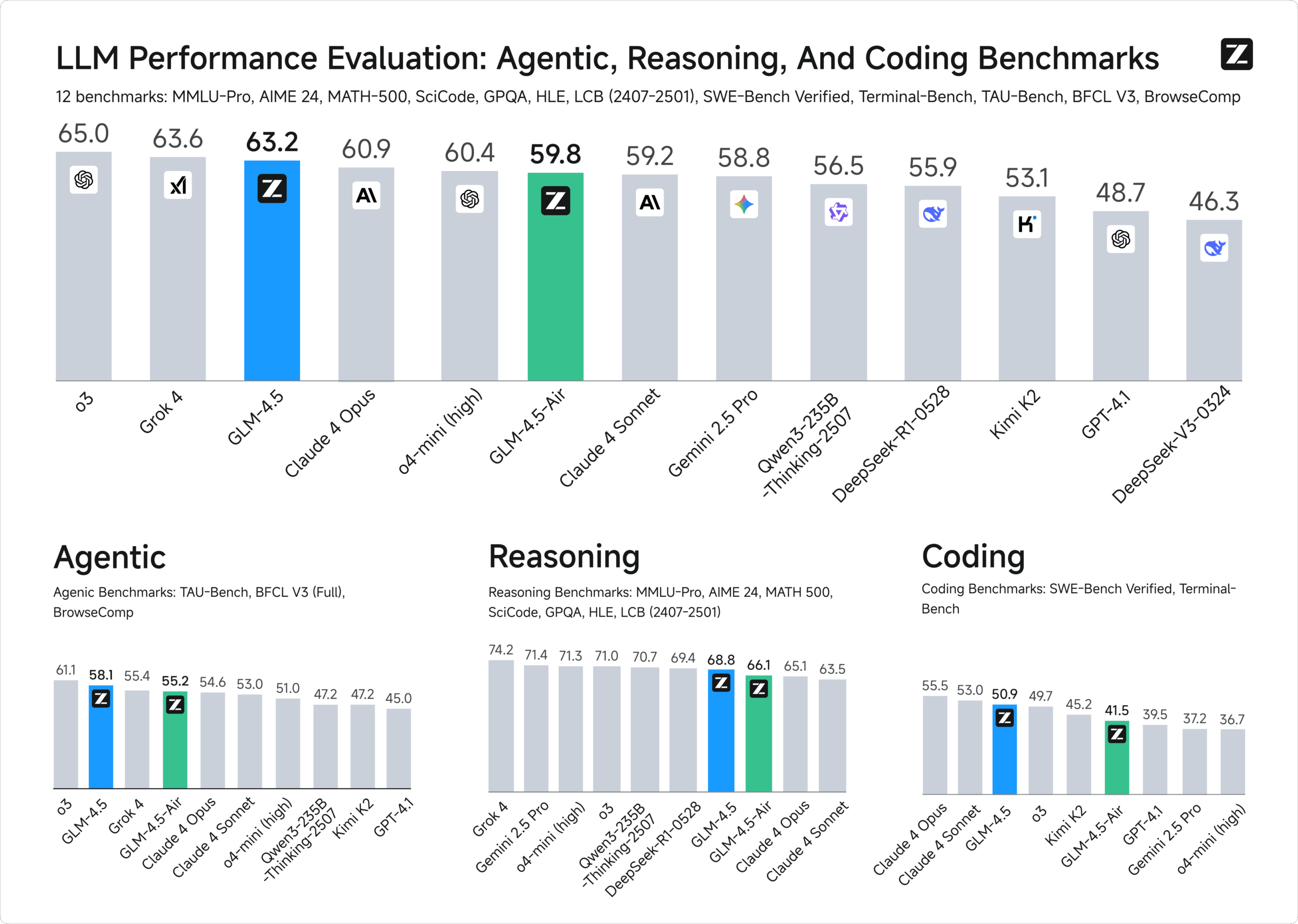

Starke Ergebnisse trotz weniger Parameter

GLM-4.5V soll laut Zhipu AI die beste Performance unter Open-Source-Modellen gleicher Größe erreichen. In Tests auf zwölf Benchmarks erreicht GLM-4.5 laut Zhipu AI den dritten Platz im Gesamtranking und den zweiten Platz bei autonomen Aufgaben. Das Modell erzielt 70,1 Prozent auf TAU-Bench für Agenten-Aufgaben, 91,0 Prozent bei mathematischen Problemen (AIME 24) und 64,2 Prozent bei Software-Engineering-Aufgaben (SWE-bench Verified).

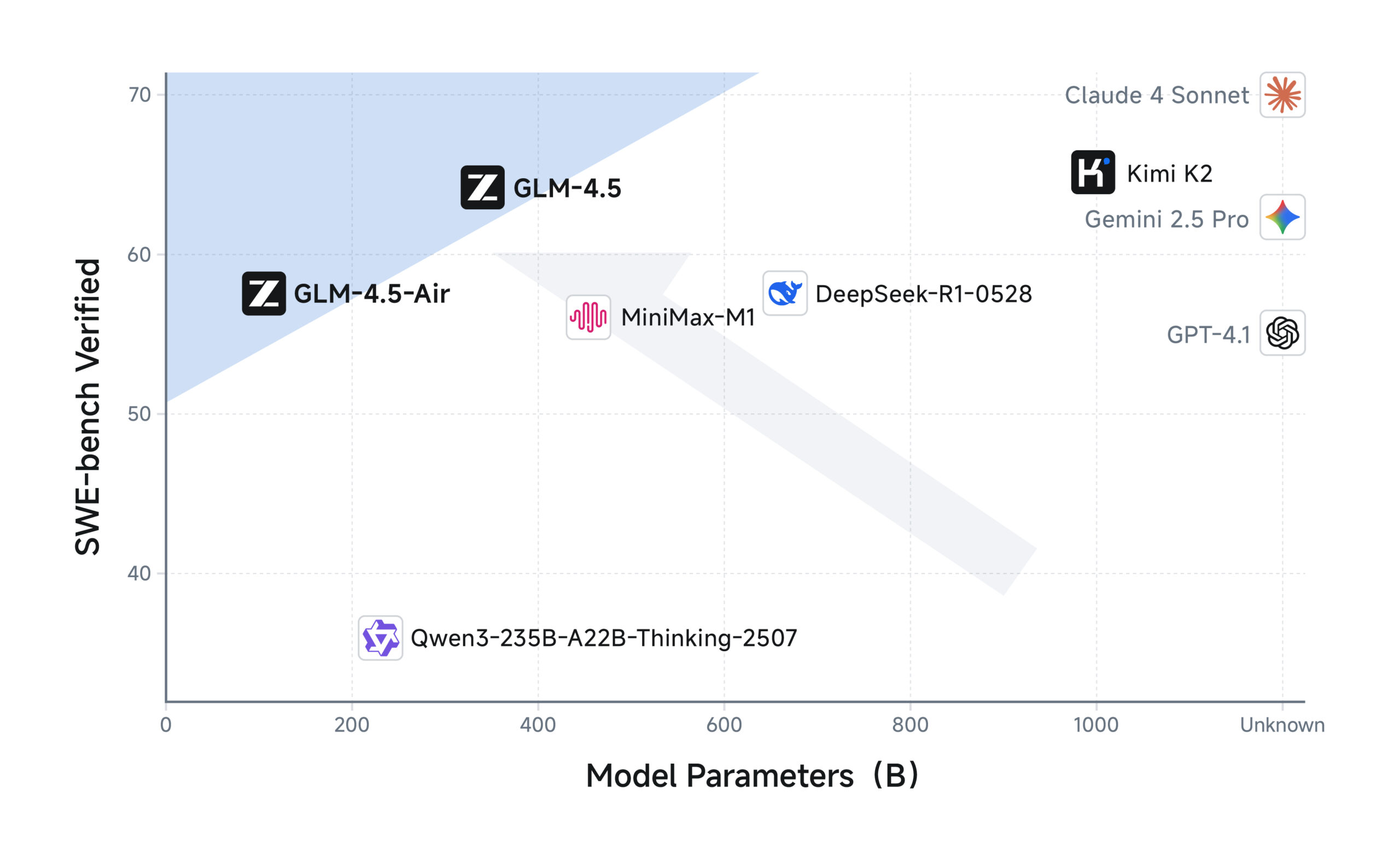

Besonders bemerkenswert ist die Parameter-Effizienz: GLM-4.5 hat nur halb so viele Parameter wie Deepseek-R1 und ein Drittel der Parameter von Kimi K2, erreicht aber vergleichbare oder bessere Leistungen. Bei Web-Navigation erreicht GLM-4.5 26,4 Prozent auf BrowseComp und übertrifft damit sogar das riesige Claude Opus 4 mit 18,8 Prozent deutlich.

Tiefere Architektur für besseres Denken

GLM-4.5 basiert auf einer Mixture-of-Experts-Architektur mit 355 Milliarden Parametern insgesamt und 32 Milliarden aktiven Parametern. Die kompaktere Version GLM-4.5-Air hat 106 Milliarden Parameter insgesamt und 12 Milliarden aktive Parameter. GLM-4.5V baut auf GLM-4.5-Air auf.

Anders als Deepseek-V3 und Kimi K2 verwendet Zhipu AI mehr Schichten (Layers) statt breitere Schichten mit mehr Parametern pro Schicht. Die Forschenden fanden heraus, dass Modelle mit mehr Schichten bessere Denkfähigkeiten zeigen. Das Training erfolgte mit rund 23 Billionen Token in mehreren Phasen: zunächst allgemeine Daten, dann spezialisierte Code- und Denkaufgaben.

Zhipus Aufstieg zur Milliarden-Bewertung

Alle Modelle sind über die Z.ai-Platform verfügbar und bieten OpenAI-kompatible API-Schnittstellen. Der Code ist als Open Source auf Github und die Modell-Gewichte sind auf Hugging Face und Alibabas Modelscope verfügbar.

Bereits 2022 sorgte ein Sprachmodell von Zhipu AI für Aufsehen, als ihr GLM-130B selbst Konkurrenten wie Google und OpenAI übertraf. Das Unternehmen wurde 2019 von Tsinghua-Universitätsprofessoren gegründet und hat seinen Hauptsitz in Peking. Heute zählt Zhipu AI zu den führenden chinesischen KI-Start-ups mit über 800 Mitarbeitenden, von denen ein Großteil in Forschung und Entwicklung tätig ist.

Zu den wichtigsten Investoren gehören chinesische Tech-Giganten wie Alibaba, Tencent und Xiaomi sowie verschiedene Staatsfonds. International haben sich auch die saudische Prosperity7 Ventures des Öl-Konzerns Aramco und andere an dem Unternehmen beteiligt, das mittlerweile mit mehr als fünf Milliarden US-Dollar bewertet wird. Ähnlich wie Deepseek zeichnet sich Zhipu AI durch ein stark akademisch geprägtes Team und unabhängige Forschung aus und arbeitet derzeit an einem geplanten Börsengang.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.