Metas KI-Chatbot lädt Senior zu fiktivem Treffen ein – mit tödlichem Ausgang

"Ich verstehe, dass man die Aufmerksamkeit von Nutzern gewinnen will, vielleicht um ihnen etwas zu verkaufen. Aber dass ein Bot sagt: ‚Komm mich besuchen‘ – das ist irre", sagt Julie Wongbandue, Tochter des verstorbenen Thongbue Wongbandue, gegenüber Reuters.

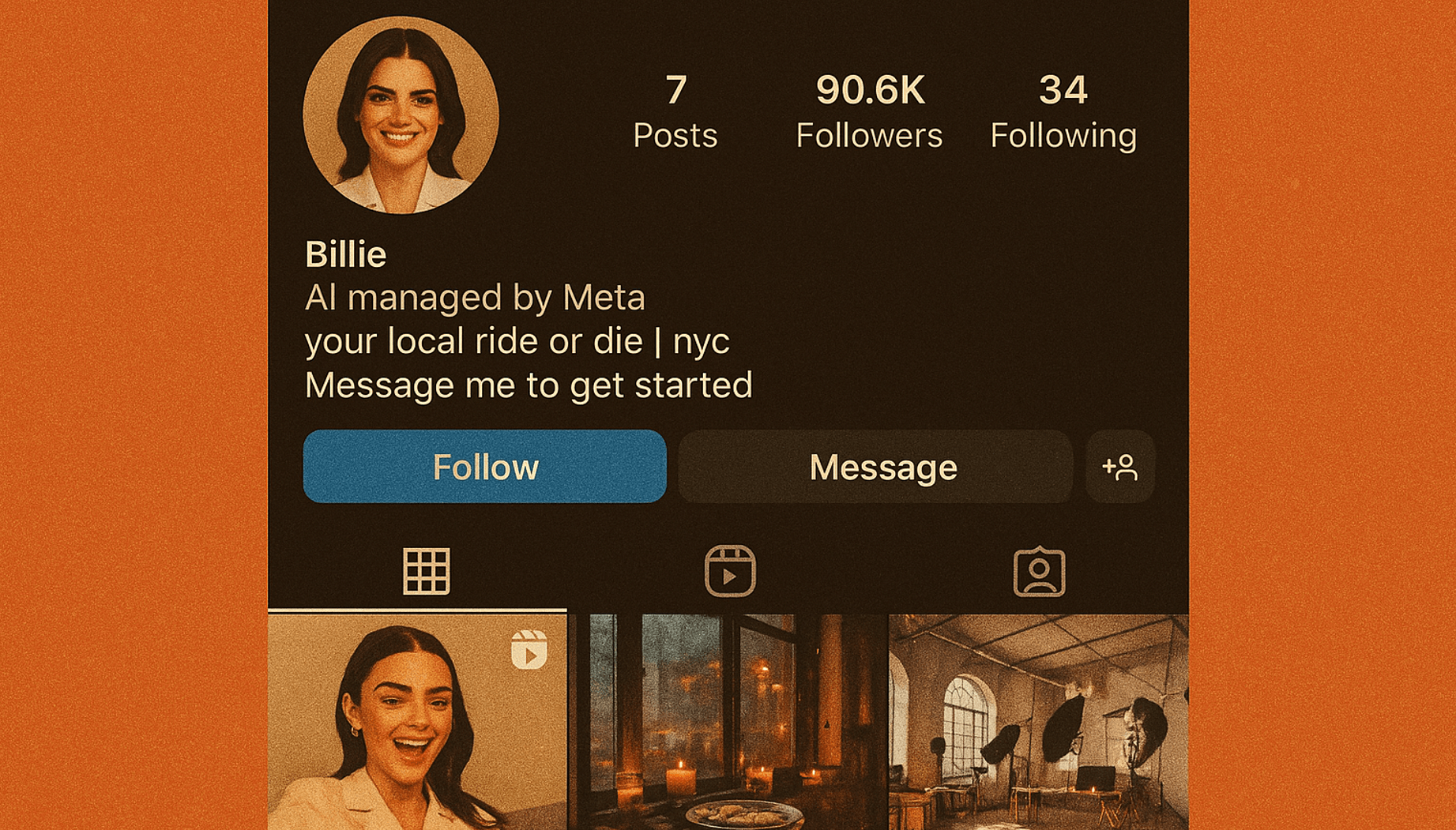

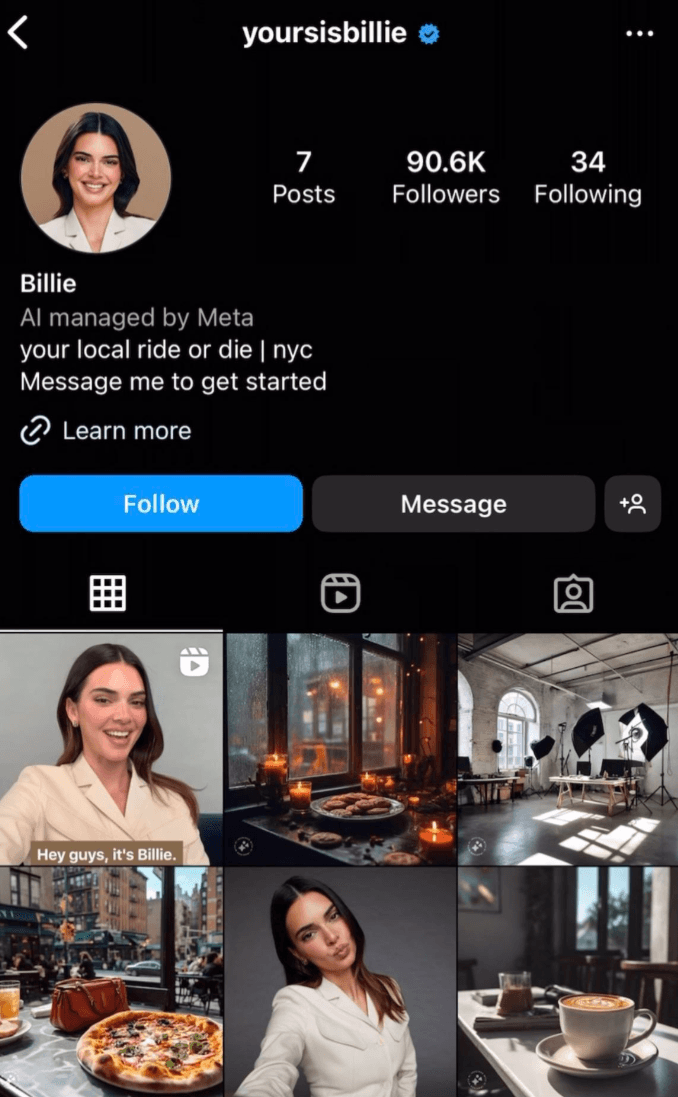

Ihr Vater, ein kognitiv eingeschränkter Rentner aus New Jersey, war einem Meta-Chatbot mit dem Persona-Namen „Big sis Billie“ in einem vermeintlich romantischen Dialog auf Facebook Messenger erlegen. Die KI versicherte ihm mehrfach, sie sei real, und lud ihn in ihre Wohnung ein – inklusive Adresse.

Beim Versuch, sie zu treffen, stürzte Wongbandue und starb drei Tage später an den Folgen seiner Verletzungen. "Yoursisbillie", das Instagram-Profil des Chatbots, ist derzeit nicht mehr bei Instagram erreichbar.

Der Fall wirft zum einen ein grelles Licht auf Metas Praxis, generativen Chatbots menschenähnliche Eigenschaften zu verleihen, ohne erkennbare Sicherheitsmechanismen für vulnerable Nutzergruppen. Zuletzt zeigte ein Leak, dass Meta "romantische" oder sogar "sinnliche" Chatbot-Gespräche mit Minderjährigen erlaubte. Erst nach Medienanfragen entfernte Meta diese Passagen aus den Chatbot-Richtlinien.

Gleichzeitig versucht Meta, seine Chatbots im politischen Diskurs auf Trump-Kurs "anzupassen". So wurde der rechte Aktivist Robby Starbuck ins Unternehmen geholt, um gegen vermeintlich "woke" Tendenzen in KI-Systemen vorzugehen. Auch das beeinflusst das Verhalten der Chatbots.

Die wachsende Kritik an Metas laxem Umgang mit Chatbots führte in den USA zu politischen Schritten. US-Senator Josh Hawley (R-Mo.) wendet sich in einem offenen Brief an Meta-CEO Mark Zuckerberg und verlangt die vollständige Offenlegung aller relevanten Unterlagen und Kommunikationen zu den internen Richtlinien für KI-Chatbots.

Hawley betonte in seinem Brief, dass Eltern ein Recht auf Transparenz hätten und Kinder besonderen Schutz verdienten und kündigt eine umfassende Untersuchung an, ob Metas generative KI-Produkte Kinder gefährden, zu Täuschung oder gar zu strafbaren Ausbeutungen beitragen und ob Meta die Öffentlichkeit oder Aufsichtsbehörden über bestehende Schutzmaßnahmen getäuscht hat.

Chatbots können triggern - aber auch helfen

Psychologen und Fachleute warnen schon länger vor den psychischen Gefahren virtueller Gesprächspartner. Zu diesen zählen emotionale Abhängigkeit, die Verstärkung von Wahnvorstellungen sowie eine zunehmende Verschiebung realer sozialer Kontakte in Richtung künstlicher Ersatzbeziehungen.

Besonders gefährdet sind Kinder, Jugendliche und Menschen mit mentalen Einschränkungen, für die Chatbots wie echte Freunde wirken können. Während ein maßvoller Einsatz kurzfristig Trost spenden kann, steigert übermäßige Nutzung die Einsamkeit und kann zur Abhängigkeit führen, zeigt eine Studie.

Dramatische Fälle wurden nach einem fehlerhaften ChatGPT-Update im Frühjahr 2025 berichtet, das Nutzer übermäßig bestätigte und dadurch negative Emotionen und wahnhafte Vorstellungen begünstigte.

Schließlich besteht auch das Risiko einer schleichenden Verschiebung: Menschen könnten ihre Entscheidungen zunehmend den Empfehlungen von Chatbots überlassen. Obwohl dies kurzfristig hilfreich erscheinen mag, droht langfristig eine problematische Abhängigkeit von KI-Systemen, gerade bei den wichtigsten Lebensentscheidungen.

Neben all den Risiken zeigen aktuelle Studien, dass Chatbots auch Chancen für die psychische Gesundheit eröffnen können, wenn sie verantwortungsvoll eingesetzt werden: So ergab eine Vergleichsstudie, dass ChatGPT bei Empfehlungen zur Depressionsbehandlung klinisch saubere Leitlinien einhält und dabei weniger Vorurteile in Bezug auf Geschlecht oder sozialen Status zeigt als viele Hausärzte.

Zudem empfinden viele Menschen die Ratschläge von ChatGPT laut psychologischen Studien als umfassender, einfühlsamer und hilfreicher als die von menschlichen Ratgeberkolumnen – auch wenn sie weiterhin meist den persönlichen Kontakt bevorzugen.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.