Einblick in die KI-Bildanalyse: KI sieht Texturen statt Formen

Bild-KIs erkennen Objekte - oder vielleicht doch nicht? Deutsche Forscher haben einen Blick in die Black Box KI geworfen und machten eine überraschende Feststellung.

Seit dem ImageNet Durchbruch 2012 hat die Leistung Künstlicher Intelligenz bei der Bilderkennung stetig zugenommen. Dieser Fortschritt ist eine der wesentlichen Grundlagen aktueller KI-Anwendungen wie etwa akkurate Gesichtserkennung, frühzeitige Krebsdiagnose oder fortschrittliche Augmented Reality.

Doch bei allen Erfolgsmeldungen gibt es immer wieder Fälle, in denen KIs bei der Bildanalyse versagen. Oft reichen schon Details, um die KI aus dem Tritt zu bringen: etwa eine geringere Auflösung oder veränderte Lichtverhältnisse. Ein unerwarteter Farbfleck lässt die KI beispielsweise statt einer Schildkröte ein Gewehr sehen.

Bild-KIs sind angreifbar – weil sie anders funktionieren als gedacht

Eine Forschergruppe aus Deutschland hat jetzt aufgedeckt, warum Bild-KIs zu Fehlern neigen - und wie man sie vermeiden kann.

Das ist wichtig, denn Hacker könnten die visuellen Schwächen ausnutzen und beträchtlichen Schaden anrichten, indem sie blinde Flecken gezielt angreifen: Ein autonomes Auto könnte ein Stoppschild übersehen oder ein Unschuldiger als Verbrecher identifiziert werden.

Doch woher kommen diese blinden Flecken?

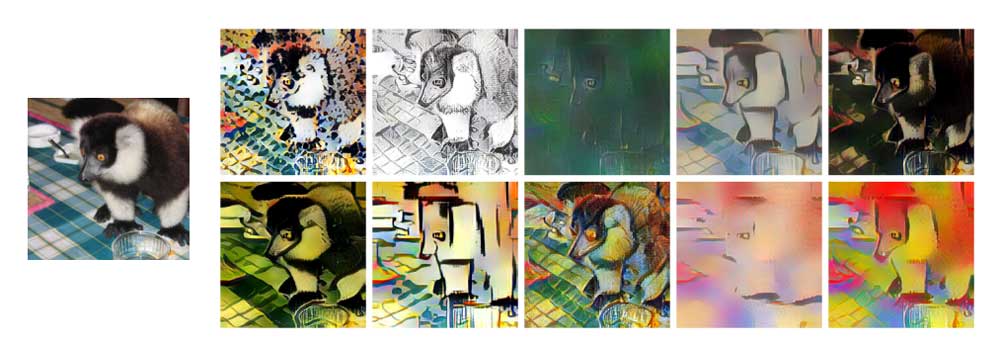

KIs identifizieren Objekte, indem sie stufenweise immer komplexere Formen erkennen. Am Anfang sieht die KI zum Beispiel nur einen ovalen Körper. Nach ausreichend Training erkennt sie die Konturen genauer und in ihnen eine Katze. So lautete zumindest bisher die Annahme.

Die Forscher zeigen jedoch, dass diese nicht richtig sein kann. Die Architektur der neuronalen Netze erlaubt zwar prinzipiell den beschriebenen Lermprozess. Aber KIs lernen anders: Sie orientieren sich stärker an Oberflächen und Texturen als an Formen.

Katzenelefant

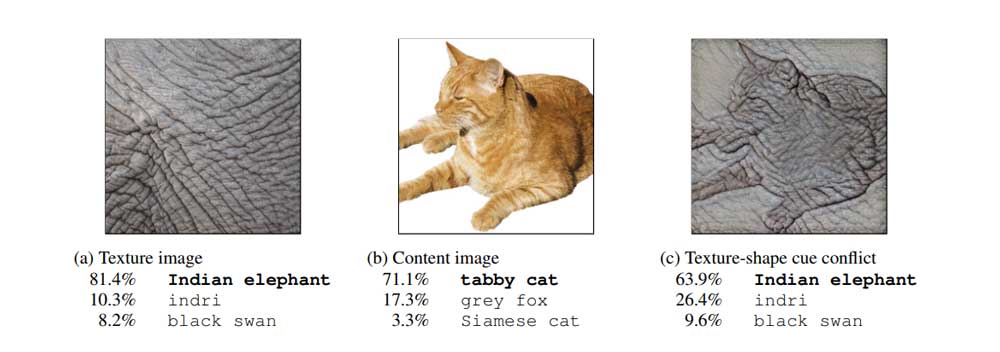

Um dem Analyseverhalten einer Bild-KI auf die Spur zu kommen, zeigen die Forscher ihr Fotos, auf denen die Form eines Objekts mit der Oberflächentextur eines anderen vermischt ist, etwa die Form einer Katze mit der Haut eines Elefanten.

Die veränderte Textur erzeugt bei der KI Fehler: Eine Katze mit Elefantenhaut wird nicht mehr als Katze erkannt, obwohl die Form ihres Körpers unverändert ist.

Die Erklärung der Forscher: Während Menschen Objekte anhand ihrer Form eindeutig zuordnen können, orientiert sich die KI an der Oberfläche des Objekts.

Diese Annahme ergibt Sinn, denn die KI sucht Pixel für Pixel das Bild nach wiederkehrenden Mustern ab. Genau solche Muster findet sie besonders gut in den Oberflächentexturen. Da ist die Künstliche Intelligenz dann doch ganz Mensch und geht den Weg des geringsten Widerstands.

Formen erkennen ist flexibler

Zwar täuschen sich mitunter auch Menschen und erkennen ein Objekt falsch, wenn es mit ungewöhnlicher Oberfläche erscheint. Aber die Objekterkennung anhand der Form ist insgesamt dennoch verlässlich:

Eine Form sieht unabhängig von externen Einflüssen fast immer gleich aus. Selbst wenn der Mensch nur einen Ausschnitt von ihr sieht, kann er die restliche Form gedanklich ergänzen.

Oberflächen hingegen können je nach Blickwinkel, Lichtverhältnissen und anderen Umwelteinflüssen recht unterschiedlich aussehen.

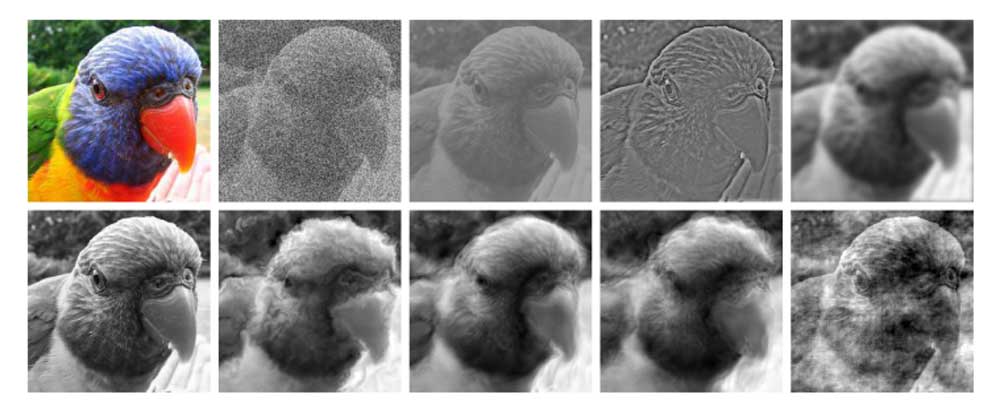

Die Forscher starteten daher einen ersten Versuch, eine Bild-KI mit Form- statt Texturerkennung zu entwickeln. Dafür trainierten sie die KI mit Fotos von Objekten, deren Texturen ständig wechselten, während die Form erhalten blieb.

Das neue Trainingsverfahren hatte gleich zwei positive Folgen: Die formbasiert trainierte KI erzielte in den Bilderkennungstests der Forscher eine überdurchschnittliche Leistung. Und sie lässt sich bei ihrer Analyse nicht so leicht durch Angriffe aus der Bahn werfen.

Titelbild: Geirhos et al., Quelle: Open Review

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.