Künstliche Intelligenz: Menschen können KI-Fehler vorhersehen

Eine Studie zeigt, dass Menschen die Fehler von Bildanalyse-KIs vorhersehen können. Das sind gute Neuigkeiten für die Kooperation zwischen Mensch und KI.

Künstliche Intelligenz für die Bildanalyse kann leicht ausgetrickst werden: Oft reichen schon einige veränderte Pixel oder ein bunter Sticker und statt einer Banane sehen sie einen Toaster. Oder schlimmer: Eine Banane statt eines Gewehrs. KI-Hacker könnten beispielsweise mit einem Sticker auf einem Straßenschild die Geschwindigkeit eines autonomen Fahrzeugs beeinflussen.

Das ist ein Problem, denn Künstliche Intelligenz soll mittels Bildanalyse Krankheiten diagnostizieren, Gesichter erkennen oder unsere Autos steuern, also unsere gesellschaftliche Organisation an ganz entscheidenden Stellen unterstützen. Wie soll das funktionieren, wenn sie leicht übertölpelt werden kann?

Forscher haben eine Idee: Maschinen-Empathie. Menschen sollen ein intuitives Verständnis für die Fehler unserer künstlichen Intelligenzen entwickeln können.

Schwächen kennlernen

Unser Alltag ist durchzogen von Technologie mit begrenzten Mitteln. Beispiele sind Sprachassistenten wie Alexa oder Google Assistant. Durch die regelmäßige Interaktion mit den Systemen entwickeln Menschen eine Art siebten Sinn für ihre Schwachstellen: Welche Fragen können die Assistenten noch sinnvoll beantworten? An welchen scheitern sie? Intuitiv wissen wir das häufig schon, bevor wir unsere Frage überhaupt stellen.

Die Forscher Zhenglong Zhou und Chaz Firestone glauben, dass wir auch für Bildanalyse-KIs ein solches Verständnis entwickeln müssen. Egal ob Krebsdiagnose oder autonomes Auto: Menschen sollen Situationen erkennen, mit der die KI überfordert ist, sagt Firestone.

Fehler sind logisch und Menschen können sie verstehen

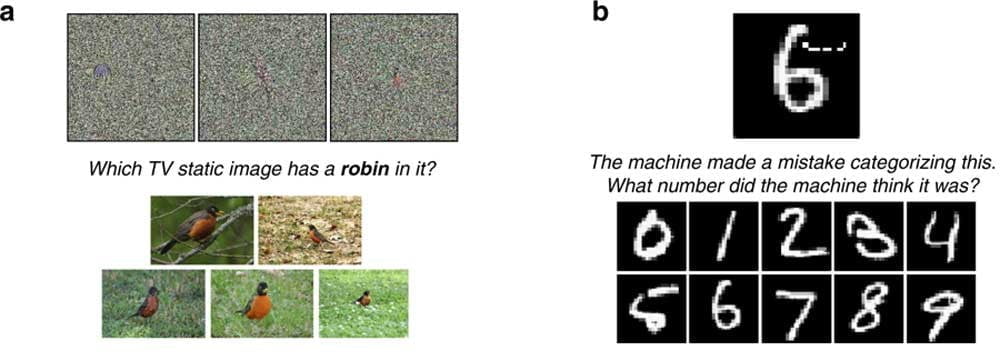

Damit das klappt, müssen diese Fehler jedoch vorhersehbar sein. Wie die Experimente der beiden Forscher zeigen, ist das tatsächlich der Fall: Menschen besitzen die Fähigkeit, die Fehler der Bild-KIs mit hoher Genauigkeit vorherzusagen.

Die Forscher griffen 48 der häufigsten Fehleinschätzungen typischer Bild-KIs auf. Anschließend gaben sie den etwa 1.800 Teilnehmern der Studie die Aufgabe, vorherzusagen, wie die Bild-KIs ein Foto kategorisiert hatten.

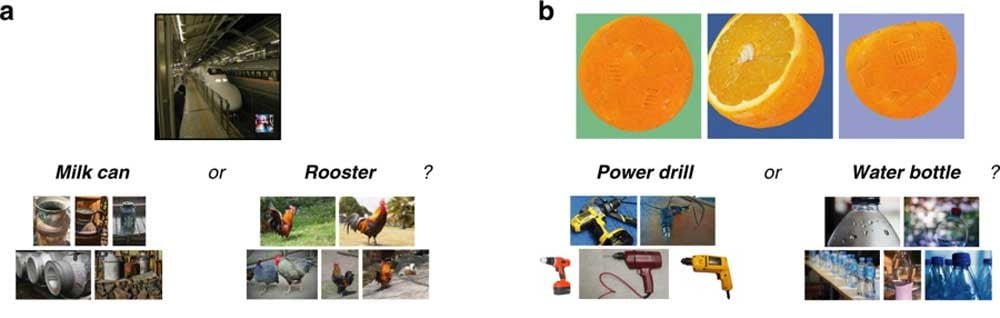

Beispiel: Hat die KI einen Zug als Milchkanne oder Hahn eingeordnet? Die Teilnehmer zeigten in allen Experimenten, dass sie Fehler der KI in mehr als 83 Prozent der Fälle korrekt vorhersehen konnten.

Mensch versteht Maschine

Dass der Mensch überhaupt zu dieser Leistung imstande ist, liegt wohl an der Evolution: Sich in die Perspektive anderer intelligenter Lebewesen zu versetzen, bringt Vorteile für das eigene Überleben und die soziale Interaktion.

Diese Fähigkeit scheint auch bei KIs zu greifen: Die Teilnehmer mussten sich in die KI hineinversetzen – denn häufig sind die Täuschungen für uns leicht zu durchschauen. Was würde die KI wohl im Bild erkennen?

Die Forscher kommen zu dem Schluss, dass "die menschliche Intuition eine zuverlässige Informationsquelle dafür ist, wie Maschinen Bilder klassifizieren werden."

Für Firestone ist klar: Menschen können ein intuitives Verständnis für Erfolg und Misserfolg von KI-gesteuerten Maschinen entwickeln. Das könne in Zukunft helfen, Bild-KIs sicherer gegen Hack-Angriffe zu machen, glauben die Forscher.

Quellen: Venturebeat, Nature

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.