KI-Assistenten im Intelligenztest: Google hängt sie alle ab

Das Risikokapitalunternehmen "Loup Ventures" hat Googles Assistenten, Alexa, Siri und Cortana auf Sprachfähigkeit getestet. Google liegt deutlich vorne.

Insgesamt stellte Loup Ventures den KI-Assistenten 800 identische Fragen, verteilt auf die Kategorien Lokales, Shopping, Navigation, Information und Anweisung. Untersucht wurde, ob die Assistenten die Frage korrekt verstehen und zufriedenstellend beantworten können.

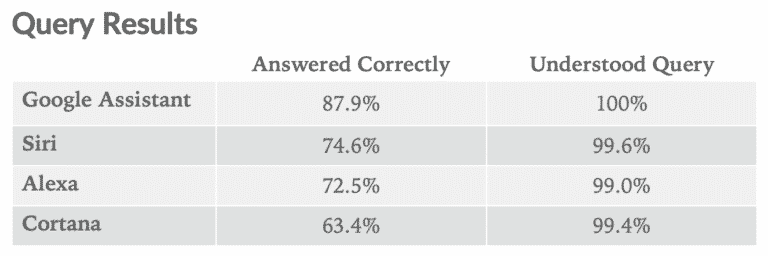

An den Ergebnissen für die Spracherkennung lassen sich gut die Deep-Learning-Fortschritte der letzten Jahre ablesen: Alle vier Assistenten knacken die 99-Prozent-Marke, Googles Assistent erreicht gar die 100 Prozent.

Bei den Antworten ist im Vergleich noch mehr Luft nach oben: Mit circa 88 Prozent korrekt beantworteten Fragen liefert der Google Assistent ein ordentliches Ergebnis. Siri (75 %), Alexa (72,5 %) und insbesondere Microsofts Cortana (63 %) sind nicht ansatzweise so verlässlich.

Im Vergleich zum Vorjahrestest stieg die Leistungsfähigkeit aller Assistenten: Google verbesserte sich von 81 auf 88 Prozent, Siri von 52 (Februar 2018) auf 75 Prozent, Alexa von 64 auf 72,5 Prozent und Cortana von 56 auf 63 Prozent.

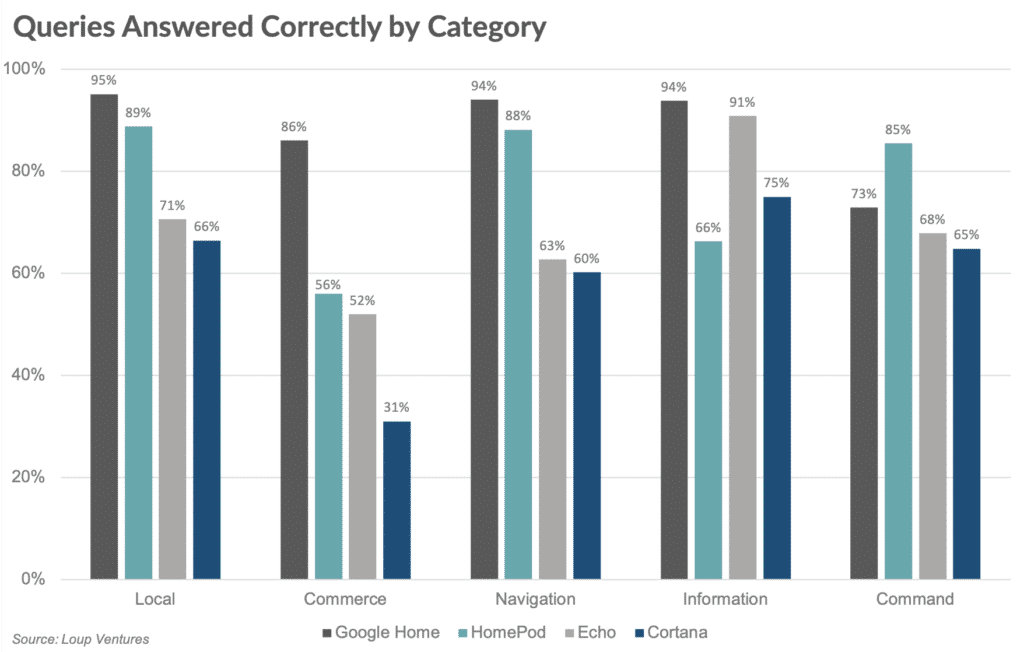

Interessant ist auch die Verteilung der korrekten Antworten auf die jeweiligen Kategorien. Google brilliert bei Fragen zur lokalen Umgebung, zur Navigation und Information. Bei Anweisungen für die Smart-Home-Steuerung hingegen hat Apples HomePod die Nase vorne. Überraschend ist das schwache Abschneiden von Alexa bei Produktfragen.

Getestet wurden die jeweiligen Assistenten in der Smart-Speaker-Version. Einen Vergleich der Smartphone-Varianten gab es zuletzt im Sommer 2018. Auch hier verwies der Google Assistent die Konkurrenz auf die Plätze. Im Vergleich zu den Vorjahresergebnissen waren alle KI-Assistenten deutlich verbessert.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar“‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.