Durchbruch bei der Morgenroutine: KI kann sich ein T-Shirt überziehen

Sich anziehen ist nicht banal: Mal steckt der Arm im Kragen oder das T-Shirt ist auf links gedreht. Wir Menschen kennen das. Künstliche Intelligenz jetzt auch.

Forscher des Georgia Institute of Technology und von Google Brain entwickeln eine KI, die T-Shirts, Pullis oder Jacken anziehen kann. Das klingt banal, dabei ist es der maschinelle Triumph über einen motorisch höchst anspruchsvollen Vorgang:

"Wir stecken unseren Kopf und unsere Arme in ein Shirt oder ziehen eine Hose hoch, ohne einen Gedanken daran zu verschwenden, wie komplex die Interaktion mit unserer Kleidung ist", schreiben die Forscher.

Sie konkretisieren diese Komplexität: "Mit einer Hand halten wir das Hemd auf, mit der zweiten greifen wir in den Ärmel, schieben unseren Arm hindurch und machen dann dasselbe für den anderen Arm - dabei verheddern wir uns nicht im Stoff und orientieren uns mit unserem Tastsinn."

Lernen in Teilschritten

Die Forscher unterteilten den komplexen Anziehvorgang in kleine Teilaufgaben, zum Beispiel den Arm durch einen Ärmel stecken. Mittels eines bestärkenden Lernverfahrens übte und meisterte die KI jede einzelne Teilaufgabe.

Bestärkende Lernverfahren trainieren Künstliche Intelligenz so ähnlich wie der Mensch das Tier: Für erwünschtes Verhalten gibt es ein digitales Leckerli, auf unerwünschte, nicht zielführende Handlungen folgt ein Malus. Googles Super-KI Alpha Zero wurde nach diesem Prinzip trainiert und meisterte so unter anderem das Strategiespiel Go auf übermenschlichem Niveau.

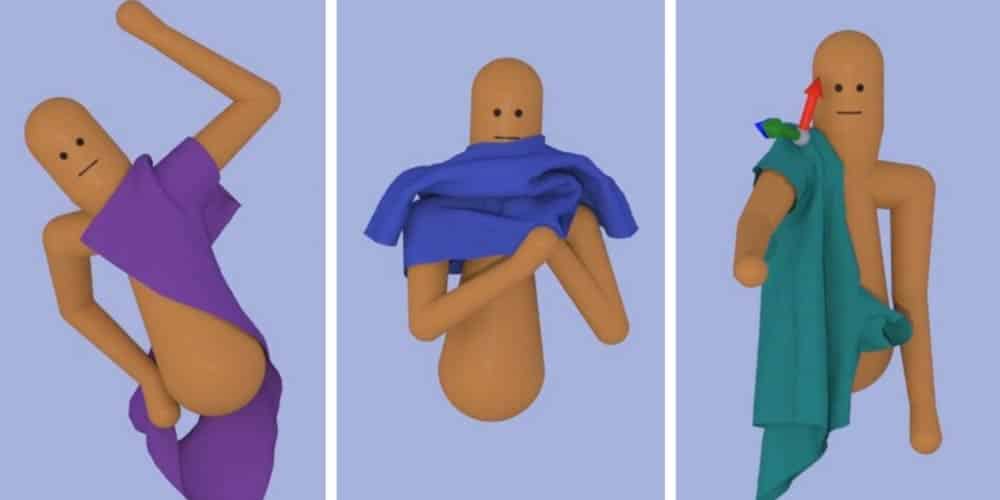

Das Ergebnis nach stundenlanger Anziehsimulation gibt es im Video unten zu bestaunen: Der KI-Algorithmus kann physikalisch korrekt simulierte Kleidung eigenständig überziehen. Der motorische Lernvorgang könnte für das Bewegungstraining von Robotern benutzt werden oder um digitale Charaktere für Filme und Spiele automatisch entlang physikalischer Gesetze zu animieren.

Die wissenschaftliche Veröffentlichung "Learning to Dress: Synthesizing Human Dressing Motion via Deep Reinforcement Learning" kann hier eingesehen werden. Die Forscher stellen ihre Arbeit auf der Siggraph Asia 2018 vor.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.