Wie OpenAI einer Künstlichen Intelligenz das Fernsehen abgewöhnt

Eine Künstliche Intelligenz mit einprogrammierter Neugierde lernt eigenständig und somit potenziell schneller und effizienter. Forscher von OpenAI vermelden jetzt einen wesentlichen Fortschritt.

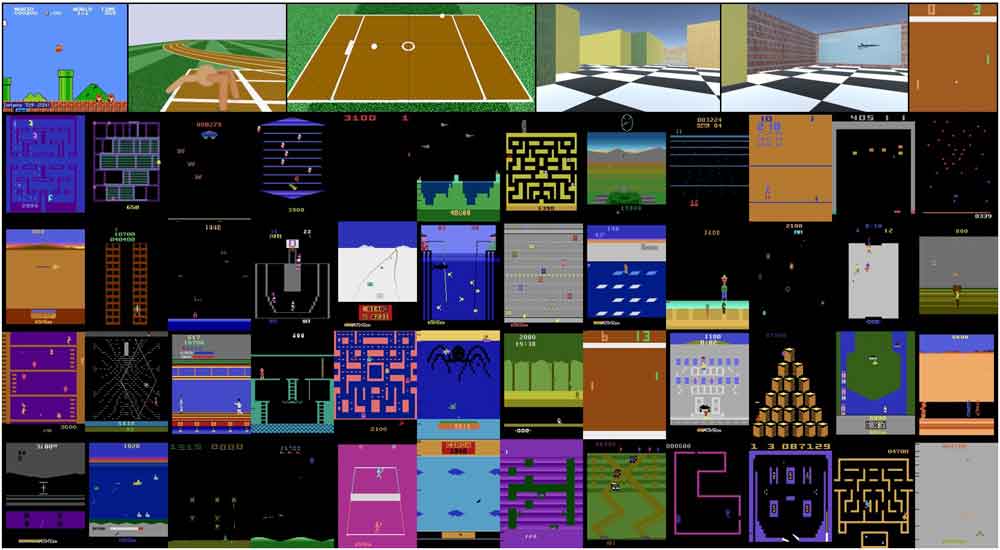

Im August stellten Forscher von OpenAI und den Universitäten Berkeley und Edinburgh eine KI mit Neugierdefunktion vor. Technisch übersetzen die Forscher Neugierde als den Drang, neue Pixel in klassischen Videospielen zu entdecken.

Das Funktionsprinzip: In den Spielen sagt die KI neue Pixelstrukturen vorher und überprüft die Vorhersage anschließend. Stimmt die Vorhersage, ist die Chance hoch, dass die KI diesen Teil des Spiels schon gesehen hat. Wenn sie nicht stimmt, wurde neuer Inhalt entdeckt ("Prediction-Error"-Prinzip). Dafür gibt es eine Belohnung.

Endstation Schneegestöber

Die KI agierte in den Spielen recht erfolgreich, beendete einige sogar auf eigene Faust. Aber sie stolperte immer dann, wenn Pixel zufällig generiert und eine Vorhersage somit unmöglich wurde - zum Beispiel verlor sie sich im Schneegestöber eines virtuellen TVs.

Ein weiteres Beispiel: Zwei neugierige KIs spielten sich beim Pong-Duell den Ball lieber permanent volley zu, anstatt ihn am Gegner vorbeizuschießen. Der Volley-Ballwechsel befriedigte die Neugierdefunktion der KI offensichtlich besser als das eigentliche Spielziel. Das ist zwar im Sinne der Neugierde, aber nicht der Zielerreichung.

Bessere KI-Neugierde

Die OpenAI-Forscher vergleichen die neugierige KI mit einem Spieler vor einem Glücksspielautomaten, der süchtig ist nach dem nächsten Zufallsergebnis und sich nicht von der Maschine lösen kann.

In den vergangenen Wochen entwickelten sie daher eine verbesserte Neugierdefunktion und stellen jetzt ihre Ergebnisse vor: Eine zusätzliche Gleichung ("Random Network Distillation") versteckt kleine Aufgaben in jedem einzelnen Bild - sogenannte Motivatoren.

Diese Motivatoren (z.B. "Was ist die Farbe oben links?") haben inhaltlich keinen tieferen Sinn. Sie stärken allerdings den Forschertrieb der Künstlichen Intelligenz und umgehen so das oben beschriebene Zufallspixelproblem.

Neugierige KI besiegt Montezuma

Mit der neuen Lernmethode konnte OpenAIs neugieriges KI-System erstmals das erste Level des Klassikspiels "Montezuma's Revenge" bewältigen. Und das mit einer deutlich höheren Punktzahl als menschliche Spieler (durchschnittlich 10.000 vs. 4.000 Punkte).

Montezuma gilt als Gradmesser für erforschende KIs, da es nicht klassisch auf Highscores und eindeutige, gut belohnbare Aktionen ausgelegt ist wie zum Beispiel Super Mario. Der Spielablauf ist nicht linear: Die KI muss sich einen Weg durch eine Pyramide bahnen, indem sie Gegnern ausweicht, Schlüssel einsammelt und damit in bereits besuchten Räumen Türen öffnet.

"Neugierde treibt den KI-Agenten an, neue Räume zu entdecken [...] und später erneut zu besuchen", schreiben die OpenAI-Forscher. Die neugierige KI ist laut OpenAI flexibel und kann in einer Vielzahl von Umgebungen eine grundlegende Kompetenz erreichen, ohne dass sie auf sorgfältig ausgearbeitete Belohnungen angewiesen ist.

Hinzu kommt, dass die Motivatorenfunktion schlank ist und wenig zusätzliche Rechenleistung benötigt, wodurch sie beim Training mit großen Datenmengen eingesetzt werden kann - zum Beispiel, wenn Roboter lernen sollen, sich in bislang unbekanntem Terrain in der Realität zu orientieren.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.