Neue Prompt-Methode lässt GPT-3 Fragen besser beantworten

Forschende stellen eine neue Prompt-Methode vor, mit der GPT-3 komplexere Fragen besser beantworten kann.

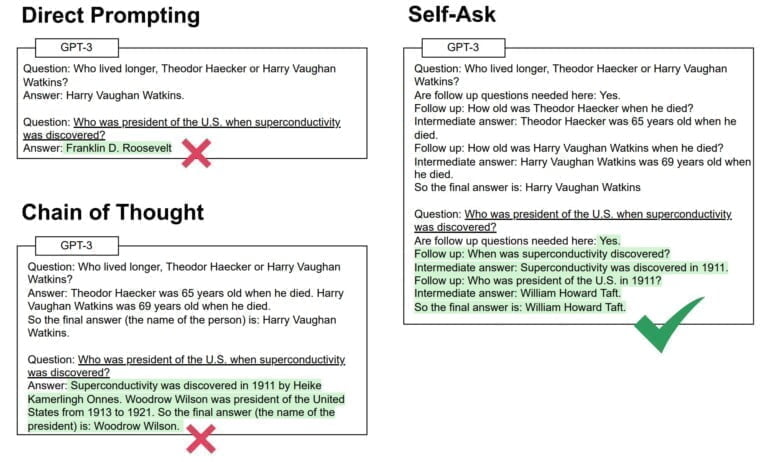

Die Forschenden nennen ihre Methode "Self-Ask": Anstatt eine Frage direkt zu beantworten, stellt sich das Sprachmodell eigenständig Folgefragen, deren Antworten zur finalen Antwort hinleiten. Das verbessert GPT-3s Fähigkeit, komplexe Fragen durch eine argumentative Vorgehensweise korrekt zu beantworten.

Die Selbstbefragung läuft vollautomatisch ab: Die erste Eingabe gibt ein Beispiel für den Selbstbefragungsprozess und stellt dann die eigentliche Frage. GPT-3 wendet den Prozess eigenständig auf die neue Frage an und stellt so viele Nachfragen, wie die Beantwortung der finalen Frage benötigt.

Self-Ask setzt auf dem Chain-of-Thought-Prompting auf, unterteilt den Prozess durch die Folgefragen aber in mehrere kleine Ausgaben, anstatt eine fortlaufende, nicht abgrenzbare Gedankenkette auszugeben.

Self-Ask verbessert GPT-3-Antworten

Die Forschenden untersuchten mit ihrer Methode auch etwas, das sie "Kompositionalitätslücke" nennen. Das ist die (Un)Fähigkeit großer Sprachmodelle, Teilfragen zwar korrekt zu beantworten, aber daraus für die Antwort auf die finale Frage eine falsche Schlussfolgerung zu ziehen.

Ein Beispiel ist die Frage nach dem amtierenden US-Präsidenten zum Zeitpunkt der Erfindung der Supraleiter. Dafür muss GPT-3 zunächst ermitteln, wann Supraleiter entdeckt wurden, um dann zu prüfen, welcher US-Präsident zu diesem Zeitpunkt im Amt war.

Bei diesem Beispiel scheitern das direkte Prompting und das Chain-of-Thought-Prompting, während die Self-Ask-Methode zum richtigen Ergebnis führt (siehe folgende Grafik).

Laut der Forschenden kann Self-Ask die zuvor beschriebene Kompositionalitätslücke in GPT-3 Modellen abhängig vom getesteten Modell verkleinern und zum Teil sogar schließen. Heißt im Klartext: GPT-3 beantwortet mit der Self-Ask-Methode komplexe Fragen mit höherer Wahrscheinlichkeit korrekt.

Genauigkeit steigt mit integrierter Google-Suche

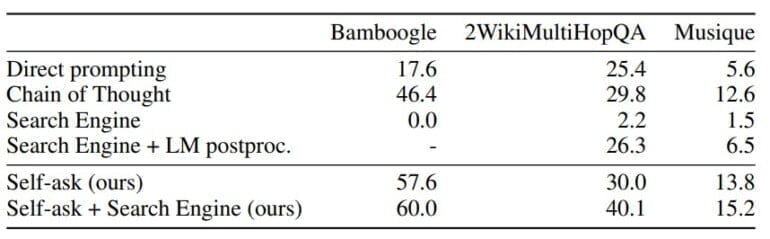

Die Kombination aus der Self-Ask-Methode mit einer Google-Suche generiert noch verlässlicher korrekte Antworten. Dabei sucht das Sprachmodell die Antwort auf eine einfache Zwischenfrage bei Google und speist sie wieder in den Self-Ask-Prozess ein. Sind alle Zwischenfragen beantwortet, entscheidet das Sprachmodell über die finale Antwort.

Bei Tests mit verschiedenen mehrstufigen Frage-Datensätzen schneiden sowohl Self-Ask als auch Self-Ask mit Google-Suche signifikant besser ab als direkte Prompts, Chain-of-Thought-Prompts und direkte Google-Suchen. Im letzteren Fall wurde eine mögliche Snippet-Ausgabe oder Text aus dem ersten Suchergebnis als Antwort gezählt.

Laut des Forschungsteams kann GPT-3 in Kombination mit Google Fragen beantworten, die GPT-3 oder Google nicht allein beantworten könnten. GPT-3 wurde 2019 trainiert, aktuelle Informationen sind nicht im Modell hinterlegt.

Bezüglich der Kompositionalitätslücke hatten die Forschenden eine weitere interessante Erkenntnis: Die Lücke wurde mit zunehmender Größe der Modelle nicht kleiner. Die Forschenden schlussfolgern aus diesem "überraschenden Ergebnis", dass größere Modelle zwar mehr Informationen speichern und abrufen, aber bei der Qualität der Schlussfolgerungen keine Vorteile gegenüber kleineren Modellen haben.

We've found a new way to prompt language models that improves their ability to answer complex questions

Our Self-ask prompt first has the model ask and answer simpler subquestions. This structure makes it easy to integrate Google Search into an LM. Watch our demo with GPT-3 🧵⬇️ pic.twitter.com/zYPvMBB1Ws— Ofir Press (@OfirPress) October 4, 2022

OpenAI (WebGPT), Deepmind (Sparrow) und Meta (Blenderbot 3) stellten bereits auf großen Sprachmodellen basierende Chatbots vor, die ebenfalls im Internet Antworten auf Fragen von Nutzenden recherchieren können.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.