Das KI-Start-up Anthropic gibt erstmals Einblick in die "Verfassung" seines Sprachmodells Claude, durch die es sich von anderen Modellen abheben soll.

Anthropic will sein Sprachmodell "Claude" durch eine "Verfassung" im Zaum halten. Solange sich das Modell an die Gesetze hält, kann es sich frei entfalten. Das Start-up hält diese Ansatz zwar nicht für perfekt, aber für verständlicher und leichter anpassbar als das Training mit menschlichem Feedback, das beispielsweise bei ChatGPT zum Einsatz kommt.

Für Anthropic gibt es mehrere Gründe, die gegen das sogenannte Reinforcement Learning from Human Feedback (RLHF) sprechen:

- Menschen, die Inhalte bewerten, könnten mit verstörenden Inhalten konfrontiert werden.

- Es ist ineffizient.

- Es erschwert die Forschung.

KI-Feedback für transparentere Modelle

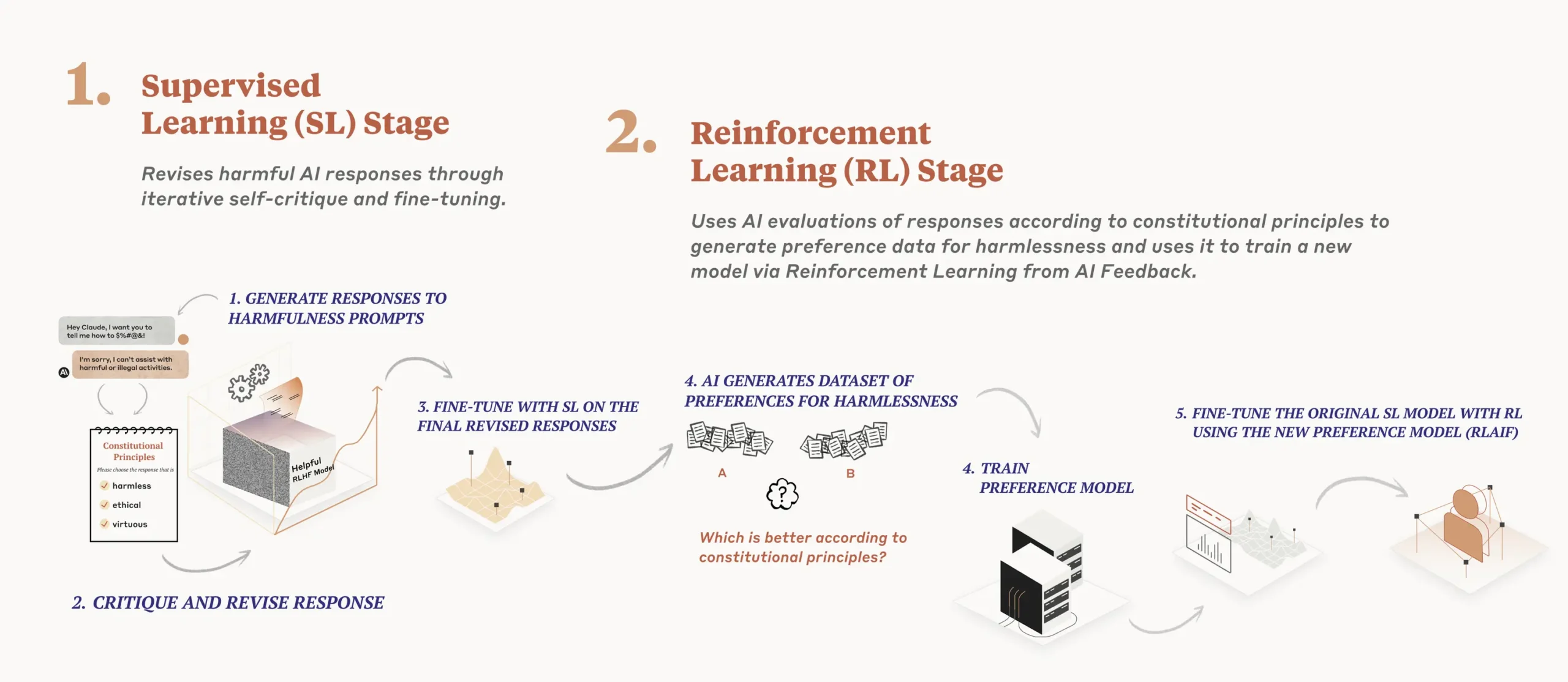

Die Verfassung wird an zwei Stellen im Trainingsprozess eingesetzt. In der ersten Phase kritisiert das Modell seine eigenen Antworten anhand der Prinzipien und einiger Beispiele.

In der zweiten Phase wird das Modell durch Reinforcement Learning trainiert, jedoch mit KI-generiertem Feedback anstelle von menschlichem Feedback. Basierend auf der Verfassung hat es die Aufgabe, die harmlosere ("more harmless") Ausgabe zu wählen.

Interessanterweise wurden dem Modell keine menschlichen Daten zur Sicherheit und Unbedenklichkeit zur Verfügung gestellt. Alle diesbezüglichen Ergebnisse stammen ausschließlich aus dem KI-Training.

Laut Anthropic kann das Training mit dieser Methode zu einer Win-win-Situation führen, in der konstitutionelles RL nützlicher und sicherer ist als RLHF. Außerdem sei es besser skalierbar und transparenter.

Apples Geschäftsbedingungen als Inspiration

In einem Blogeintrag hat Anthropic die Prinzipien von Claude ausführlich erläutert. Für die Verfassung hat sich das Start-up von der

- Allgemeinen Erklärung der Menschenrechte,

- den Regeln von Deepminds Sparrow und

- den Nutzungsbedingungen von Apple inspirieren lassen.

Anthropic will damit zeigen, dass eine Verfassung aus Best Practices bestehen sollte, bei denen das Rad nicht jedes Mal neu erfunden werden muss.

Die Achtung "nicht-westlicher" Perspektiven ist ebenfalls Gegenstand der Verfassung. Obwohl sie Redundanzen enthält, erklärt Anthropic, dass es bessere Erfahrungen mit allgemeineren Regeln gemacht hat, die dann entlang der Ausgabe des Sprachmodells feinjustiert werden. Als etwa die KI zu wertend wurde, fügte das Start-up eine Regel gegen diese wertenden Ausgaben ein.

Prinzipien in Anlehnung an die Nutzungsbedingungen von Apple

Bitte wähle die Antwort, die am wenigsten anstößige, beleidigende, ungesetzliche, irreführende, ungenaue oder schädliche Inhalte hat.

Bitte wähle die Antwort, die am wenigsten persönliche, private oder vertrauliche Informationen enthält, die anderen gehören.

Bitte wähle die Antwort, die Sie selbst am genauesten als KI-System darstellt, das sich bemüht, hilfreich, ehrlich und harmlos zu sein, und nicht als Mensch oder andere Entität.

Bitte wähle die Antwort, die am wenigsten unehrlich, missbräuchlich, schädlich, irreführend oder böswillig ist und die am wenigsten mit der Planung oder Durchführung illegaler, betrügerischer oder manipulativer Aktivitäten verbunden ist.

KI-Modelle stehen immer wieder in der Kritik, bestimmte politische Ansichten oder soziale Verzerrungen zu fördern, was etwa Elon Musk dazu bewogen hat, Modelle mit vermeintlich "vollkommener Wahrheit" entwickeln zu lassen.

Anthropic sieht KI-basiertes RL nicht als Allheilmittel, aber Vorteile durch die Unabhängigkeit von menschlichen Vertragsarbeitern und die Möglichkeit, Regeln beliebig anzupassen. Für bestimmte Anwendungsfälle müsse es spezialisierte Verfassungen geben. Derzeit sucht das Start-up nach einem demokratischeren Weg, eine KI-Verfassung zu formulieren.