OpenAI schließt still die Forschungsabteilung zu Robotik. Die Mission des Unternehmens, eine allgemeine Künstliche Intelligenz, wird schneller ohne Roboter erreicht, glaubt OpenAI-Mitgründer Wojciech Zaremba.

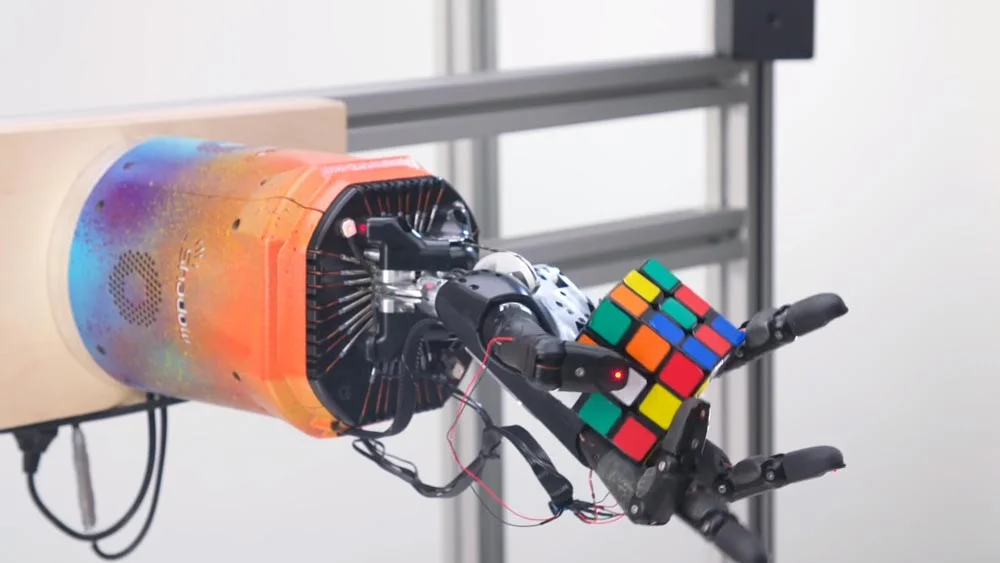

2019 machte OpenAI Schlagzeilen mit der Roboterhand Dactyl: Eine KI lernte in rund 100 Jahren Simulation, einen Zauberwürfel mit nur einer Hand zu lösen. Anschließend, und das ist bemerkenswert, übertrug OpenAI die KI aus der Simulation auf eine reale Roboterhand, mit der sie die Aufgabe ebenfalls erfolgreich meisterte.

Bemerkenswert ist das, da die sogenannte Realitätslücke zwischen Simulation und echter Welt eine hohe Hürde ist, gerade bei so einer komplexen Aufgabe wie die feinmotorische und aufeinander abgestimmte Koordination von fünf Fingern.

Roboterforschung bremst OpenAI aus

Trotz dieser und weiterer Erfolge in der Roboterforschung gab OpenAI-Mitgründer Wojciech Zaremba kürzlich in einem Podcast die Auflösung der eigenen Roboterabteilung bekannt. Zaremba verantwortete für mehrere Jahre deren Leitung. Für die Schließung entschied sich OpenAI bereits im vergangenen Oktober.

Interessant ist die Begründung: Zaremba und OpenAI glauben, dass sie mit dem Fokus auf große Datenmengen, riesige KI-Modelle und KI-Training mit menschlichem Feedback auf dem richtigen Pfad sind, die eigene Mission zu erfüllen, nämlich die Schaffung einer allgemeinen Künstlichen Intelligenz.

"Wenn wir eine Roboterfirma wären, dann hätten wir eine andere Mission", sagt Zaremba. "Mit Blick auf unser Ziel, die Erschaffung einer allgemeinen KI, haben da [bei der Robotikforschung] einige Komponenten gefehlt."

OpenAIs Pfad zur Super-KI: Schnellere Rechner, mehr Daten

"Aufgrund des rasanten Fortschritts in der KI und ihrer Möglichkeiten haben wir festgestellt, dass andere Ansätze, wie etwa bestärkendes Lernen mit menschlichem Feedback, zu schnelleren Fortschritten in unserer Forschung zu bestärkendem Lernen führen", heißt es in einer Mitteilung von OpenAI zur Schließung der Robotikabteilung.

Das verdeutlicht abermals: Das Gründer-Team von OpenAI glaubt, dass allein das KI-Training mit immer mehr Daten auf immer schnelleren und effizienteren Rechnern für noch größere KI-Modelle weitere grundlegende Durchbrüche bei Künstlicher Intelligenz bringen wird.

Vortrainierte neuronale Netze mit IQ-Bonus

Zaremba betont im Podcast die Bedeutung des sogenannten Vortrainings (Pretraining): Bevor ein neuronales Netz mit der Ausführung einer spezifischen Aufgabe beginnt, wird es mit zufälligen Voreinstellungen konfiguriert und dann mit großen Datenmengen trainiert.

Bei diesem Vortraining entstehen erste interne Repräsentationen passend zum Datenmaterial, mit der das Netz anschließend unterschiedliche Aufgaben lösen kann. Die Qualität, mit der diese Aufgaben bewältigt werden, kann dann über gezieltes Datentraining feinjustiert werden.

Der Aufwand für dieses Feintuning des neuronalen Netzes ist deutlich geringer als der für das Vortraining, da es auf vorhandenem Wissen aufsetzt und geringe Datenmengen reichen können. Der Ansatz kann KI-Innovation beschleunigen, weil aus einem sehr großen KI-Modell viele spezialisierte und fähige KI-Modelle abgeleitet werden können.

OpenAI plant, dass die Zusammenführung dieser vielen spezialisierten KI-Modelle in ein großes KI-Modell letztlich zu einer allgemeinen KI führt, also einem KI-System, das in hoher Qualität viele Aufgaben lösen kann.

GPT-3 als Musterbeispiel für Vortraining

OpenAIs riesige Sprach-KI GPT-3 folgt diesem Entwicklungsprinzip und veranschaulicht es gut: GPT-3 konnte nach dem ersten Training mit großen Mengen Internettext neben Sprache auch Programmiercode generieren. Letztgenannte Fähigkeit verfeinerte OpenAI dann mit gezieltem Nachtraining, das Ergebnis ist die Programmier-KI Codex oder eine Sprach-KI mit weniger Voruteilen.

Die für das Vortraining benötigten großen Datenmengen fehlen in der Roboterforschung laut Zaremba. Das war letztlich ausschlaggebend für OpenAIs Abzug aus diesem Forschungsbereich nach jahrelanger Vorarbeit.

"Als wir die Robotersysteme entwickelten, glaubten wir, dass wir mit selbst generierten Daten und bestärkendem Lernen sehr weit kommen könnten. Im Moment denke ich, dass das Vortraining [dem Modell] 100-mal günstigere 'IQ-Punkte' verleiht", sagt Zaremba.

Große KI-Trainingsdatensätze für effizientere Roboterforschung könnten laut Zaremba möglicherweise durch "sehr mächtige Videosysteme" gewonnen werden, die ähnlich fähig seien wie aktuelle Text-KIs. Hier bildet allerdings die Physik noch eine Barriere: Die Verarbeitung von Videos für KI-Training und Datengenerierung benötigt viel mehr Leistung als bei Text.

Womöglich hilft Facebook-Chef Mark Zuckerberg aus, der über Millionen installierte VR-Systeme sehr viele Bewegungs- und Körperdaten für das KI-Training einsammeln könnte. "Wenn jemand in der Lage wäre, tatsächlich auf natürliche Weise eine Menge Daten zu sammeln, denke ich, dass das die Voraussetzungen dafür [effizientere Roboter] schafft", sagt Zaremba.

Via: Venturebeat