Avengers Thanos, Nvidias Siren, David Bowie oder DigiDoug. Künstliche Intelligenz ist in der VFX-Industrie angekommen und ermöglicht glaubwürdige, digitale Avatare. Aber Moment: Wer ist "DigiDoug"?

Auf dem diesjährigen Silicon-Valley-Festival "Infinity" zeigte die Agentur MacInnes Scott einen digitalen David Bowie. Die Firma entwickelt XR-Erfahrungen und stellte ihre neueste Produktion "David Bowie is Unreal" vor.

Ein Schauspieler steuert den in Echtzeit berechneten Digital-Bowie mit Ganzkörper-Tracking-Anzug und einer vor das Gesicht montierten Kamera, die seine Mimik überträgt.

In dem kurzen Clip wird deutlich, dass MacInnes Scott noch nicht die Qualität der von Nvidia im März vorgestellten Computerfrau „Siren“ erreicht – doch der Clip zeigt auch: Die Technologie für digitale Echtzeit-Menschen hat die Labore verlassen.

Künstliche Intelligenz für digitale Echtzeit-Avatare

Auf der diesjährigen Computergrafik-Konferenz Siggraph sprach Doug Roble, Softwarechef des Visual-Effect-Studios Digital Domain, über digitale Menschen. Das 1993 unter anderem vom Regisseur James Cameron gegründete Unternehmen hat an Spezialeffekten und computergenerierten Grafiken für „Titanic“, „Der seltsame Fall des Benjamin Button“ oder für Marvel-Filme gearbeitet.

Zuletzt entwickelte Digital Domain den Bösewicht Thanos für die Avengers-Filme. Der digitale Thanos wurde dabei vom echten Schauspieler Josh Brolin verkörpert.

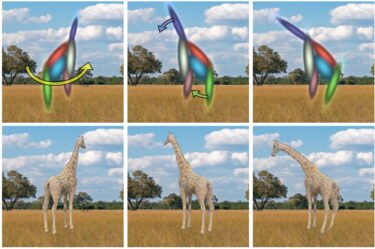

Um dessen schauspielerische Leistung in Echtzeit auf den digitalen Charakter zu übertragen, entwickelte Digital Domain ein KI-System: Zunächst erstellte das Unternehmen Scans von allen erdenklichen Gesichtsausdrücken Brolins. Diese dienten dann der KI „Masquerade“ als Trainingsmaterial.

Sie lernte anhand der Scans, wie sich zum Beispiel Brolins Lippen bewegen und wann sich Falten um seine Augen bilden. Aus diesen Daten wurde eine digitale Kopie von Brolins Gesicht erstellt.

Bei den Dreharbeiten wurden dann mit einer vor dem Gesicht montierten Kamera 150 Punkte auf seinem Gesicht getrackt. Diese Punkte dienen der KI als Orientierungshilfe, um die reale Mimik auf den digitalen Schauspieler zu übertragen und ihn lächeln, weinen oder schreien zu lassen.

Für komplexe Gesichtsbewegungen sind diese 150 Punkte allerdings viel zu wenig: Genau hier kommt die KI ins Spiel. Durch das vorherige Gesichtstraining konnte sie die 150 auf circa 40.000 Trackingpunkte hochrechnen und Brolins Mimik mit verhältnismäßig geringem technischen Aufwand sehr detailliert aufzeichnen.

Das System „Direct Drive“ überträgt anschließend die von „Masquerade“ erstellten 3D-Daten in Echtzeit auf eine digitale Kreatur – im Avengers-Beispiel ist es Thanos.

Mit Künstlicher Intelligenz durchs Uncanny Valley

Digital Domains KI-Kreationen sind sogar außerhalb von Kinos unterwegs. Im April 2019 hielt Doug Roble einen TED-Vortrag, in dem seine digitale Echtzeit-Kopie parallel auf einem Bildschirm zu sehen war.

Mit Ganzkörper-Tracking-Anzug, Manus-VR-Handschuhen (Test) und einer Gesichtskamera ausgerüstet, spricht er über den Weg zu seinem Double DigiDoug.

Das Besondere an Digital Domains Technologie: Die Eingaben können problemlos auf eine Vielzahl Charaktere übertragen werden. Im TED-Talk wird DigiDoug plötzlich durch einen Gnom ersetzt – und spricht anschließend über all die Anwendungen, die er für die Technologie sieht: Videotelefonie in Virtual Reality, digitale Schauspieler oder menschliche Hüllen für digitale Assistenten.

Auf der Siggraph-Konferenz wiederholt Roble seinen Optimismus für die Vorteile digitalisierter Menschen und verspricht noch mehr: Aktuell versuche man, mit den von Deepfakes bekannten GAN-Netzwerken die Figure noch echter aussehen zu lassen.

Weshalb der ganze Aufwand? Man habe erkannt, dass man sich bei Echtzeit-Avataren auf lernende Computer statt auf Künstler verlassen müsse.

Denn Künstlern gelang es laut Roble bislang nicht nicht, die Akzeptanzlücke (Uncanny Valley) bei digitalen Menschen vollständig zu überwinden – gut trainierte Maschinen hingegen könnten womöglich selbst die kleinsten Details originalgetreu darstellen.

Titelbild: Marvel, Quelle: Nvidia, Siggraph Vortrag