Forscher unter anderem von Adobe zeigen eine GAN-KI, die 3D-Repräsentationen von Objekten lernt und diese anschließend in Bildern positionieren kann.

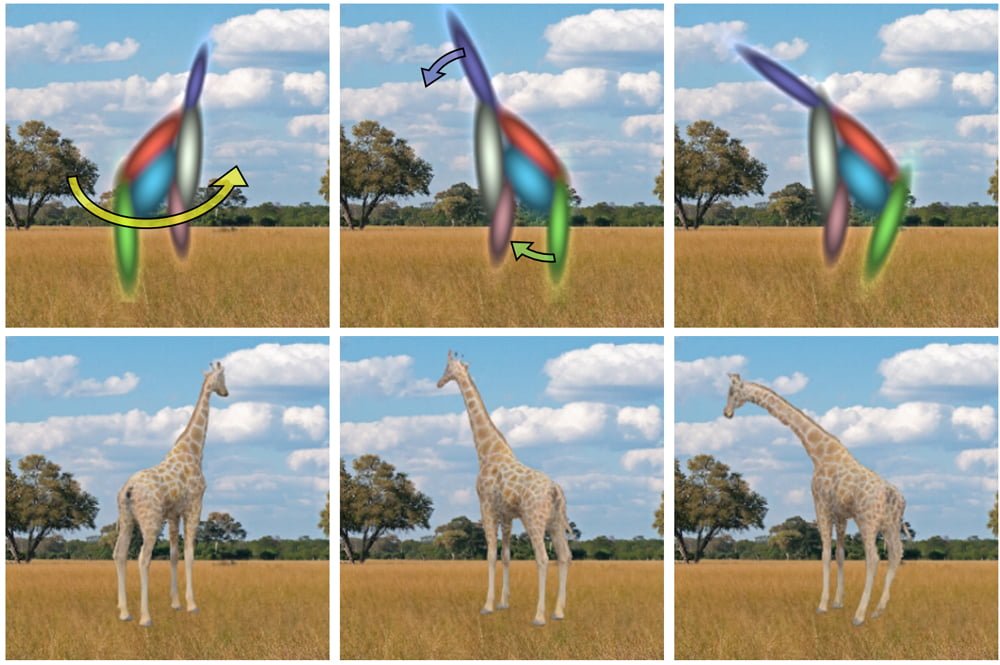

Über ein archaisch wirkendes Werkzeug platziert ein Forscher eine rudimentäre 3D-Form einer Giraffe in das Bild einer Savanne. Per Knopfdruck generiert die KI anschließend eine texturierte Giraffe, deren Ausleuchtung sich automatisch der des Bildes anpasst.

Was wirkt wie eine Mischung aus 90er-Jahre Science-Fiction und 3D-Clipart-Spielerei, könnte in Zukunft die Bildbearbeitung im großen Stil verändern: Die von einem KI-System gelernten 3D-Repräsentation der Giraffe verfügt über Abschnitte für Hals, Beine, Rücken, Brust und Rumpf und kann so in verschiedene Körperpositionen gebracht werden - mal dreht sich der Hals, mal beugt er sich zu einem Baum. Die generierte Textur passt sich dabei immer automatisch der neuen Körperhaltung an. Und das alles per Mausklick.

Das System heißt GaussiGAN und setzt auf ein Generative Adversarial Network (Erklärung). Die an der Entwicklung beteiligten Forscher arbeiten für die University of Bath, die Cornell University, dem Ulsan National Institute of Science and Technology, die Brown University und für den Bildbearbeitungsspezialisten Adobe. Der könnte die KI-Technologie sicher gut in seine Bildbearbeitungsprogramme integrieren.

GaussiGAN kann mehr als Giraffen

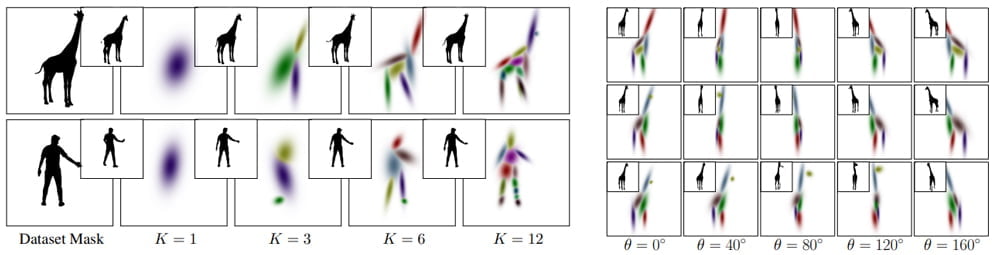

GaussiGAN lernt die flexibel anpassbaren 3D-Repräsentationen von Objekten anhand von mehreren 2D-Bildern, die Objekte aus unterschiedlichen Blickwinkeln während einer Bewegung zeigen. Durch die Veränderungen in der Körperhaltung und die verschiedenen Blickwinkel lernt das Netz immer genauere, Mannequin-artige Repräsentationen eines Objekts.

So wird im Laufe des KI-Trainings etwa aus einem simplen, dreiteiligen Mischmasch schnell eine erkennbare menschliche Form inklusive Kniegelenk.

Neben der Form lernt GaussiGAN auch die Texturierung der Figur aus verschiedenen Blickwinkeln und in verschiedenen Körperhaltungen. Nach dem KI-Training kann die KI so die 3D-Repräsentation in einer neuen Umgebung platzieren und texturieren und dabei sogar die Beleuchtung im Zielbild analysieren und bei der Integration des Objekts beachten.

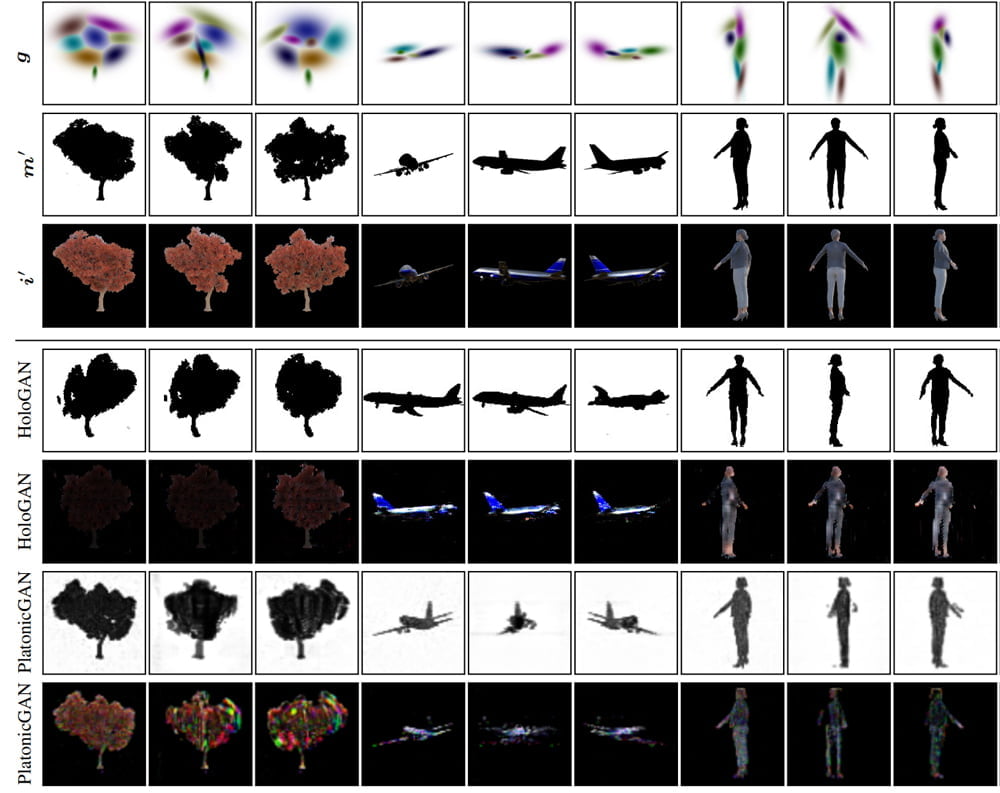

GaussiGAN kann neben Giraffen auch Personen, Flugzeuge, Roboter und andere Objekte platzieren und erzeugt im Vergleich mit älteren Ansätzen (HoloGAN und PlatonicGAN), die keine veränderbaren 3D-Repräsentationen lernen, deutlich glaubwürdigere Bilder.

Weiterentwicklungen von GaussiGAN sollen in Zukunft auch mit Echtwelt-Aufnahmen trainiert werden können, die keine perfekten Bedingungen für das KI-Training bieten wie etwa wenige Blickwinkel und komplexe Hintergründe, die die Bildanalyse erschweren. Ein so trainiertes robusteres KI-Modell könnte in Bildbearbeitungsprogrammen verlässlich neue Objekte platzieren oder vorhandene neu texturieren.

Ein ausführliches Erklärvideo und weitere Informationen gibt es auf der Webseite des Projekts.

Via: Arxiv