Bekannter KI-Forscher hört auf: Missbrauchspotenzial zu groß

Der bekannte KI-Forscher Joe Redmon entwickelte eine viel genutzte Bildanalyse-KI. Jetzt stellt er die Arbeit daran ein, da er Missbrauch durch das Militär und eine Überwachungsmaschinerie befürchtet.

Spätestens seit der Atombombe ist klar, wie schnell aus einer mächtigen und potenziell nützlichen Technologie eine Bedrohung wird. Ähnlich ist es bei Künstlicher Intelligenz: Bildanalyse-KIs können Katzen erkennen – oder Menschen überwachen. Die gleiche KI-Technologie, die täglich Millionen von Smartphones entsperrt, setzt China für die Massenüberwachung der eigenen Bevölkerung ein.

Durch ihre Erfolge der letzten Jahre ist die KI-Forschung immer stärker zum Ziel öffentlicher und innerhalb der Branche geäußerter Kritik geworden. Das KI-Äquivalent zur Atombombe wurde zwar noch nicht erfunden, aber gerade die Möglichkeiten zur Bildmanipulation oder Massenüberwachung haben weltweit Kritiker aufgeschreckt.

Auf der wichtigen KI-Konferenz NeurIPS zum Beispiel müssen in Zukunft alle eingereichten Arbeiten ein Kapitel zu den möglichen Konsequenzen einer Forschung enthalten.

KI-Forscher befürchtet Missbrauch seiner Forschung

Als die NeurIPS-Konferenz diese neue Regel bekanntgab, machte das den amerikanischen KI-Forscher Joe Redmon hellhörig. Redmon ist Macher der weit verbreiteten Bildanalyse-KI "You only look once" (YOLO).

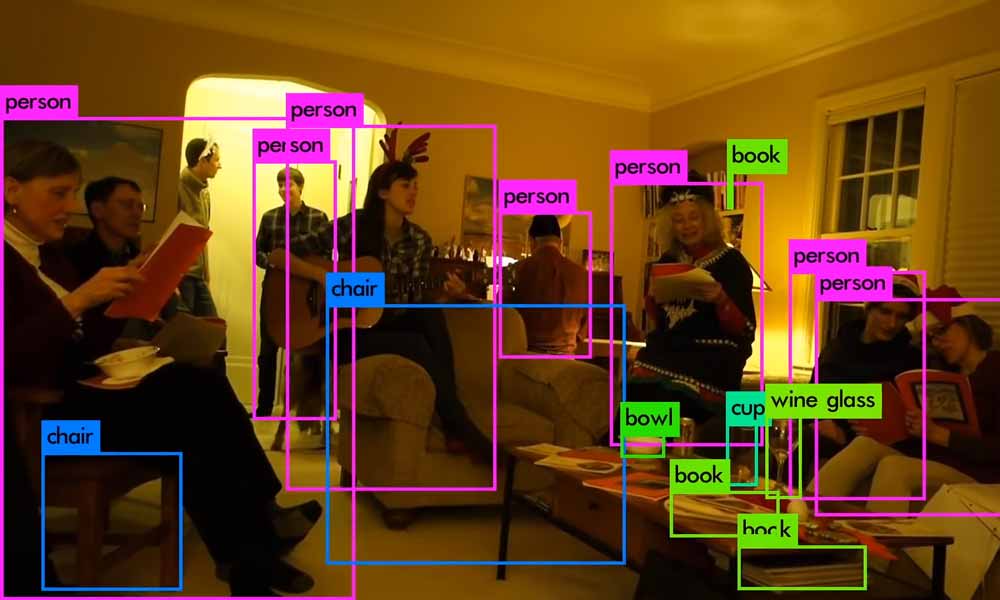

YOLO ist eine Open-Source Bildanalyse-KI, die in Echtzeit Objekte erkennt. Sie ist genau und benötigt dafür keinen Supercomputer: Die aktuelle Version YOLOv3 kann auf einer Nvidia Titan X 30 Bilder pro Sekunde analysieren.

Redmon veröffentlichte die erste Version von YOLO bereits 2016. Version 3 erschien dann im Frühjahr 2018.

Schon in einer wissenschaftlichen Veröffentlichung 2018 lies Redmon ungewohnt kritische Töne anklingen: "Was machen wir mit diesen Detektoren, jetzt wo wir sie haben? Viele der Leute, die diese Forschung betreiben, sind bei Google und Facebook. Ich schätze, zumindest wissen wir, dass die Technologie in guten Händen ist und definitiv nicht dazu verwendet wird, Ihre persönlichen Daten zu sammeln und sie zu verkaufen... warten Sie, wollen Sie damit sagen, dass sie genau dafür verwendet wird? Oh."

Ein weiterer Geldgeber sei das Militär und das "habe ja wohl noch nie schlimme Dinge getan", merkt Redmon im weiteren Verlauf zynisch an. Forscher seien in der Verantwortung, möglichen Schaden ihrer Arbeit zu bedenken und zu mindern. "So viel schulden wir der Welt", schreibt Redmon.

Redmon hört wegen ethischer Bedenken mit der KI-Forschung auf

Etwa ein Jahr später zieht Redmon nun drastische Konsequenzen aus dem anhaltenden Trend, Bildanalyse-KIs für die Überwachung zu nutzen und stoppt seine Forschung an der KI-Technologie. Eine vierte Version von YOLO wird es nicht geben – zumindest nicht von Redmon direkt.

Er habe die Arbeit an seiner Bildanalyse-KI geliebt, aber militärische Anwendungen und die Eingriffe in die Privatsphäre könne er nicht mehr ignorieren, schreibt Redmon auf Twitter.

I stopped doing CV research because I saw the impact my work was having. I loved the work but the military applications and privacy concerns eventually became impossible to ignore.https://t.co/DMa6evaQZr

— Joe Redmon (@pjreddie) February 20, 2020

In Fachkreisen stößt er auf Verständnis – aber auch auf Kritik. Andere KI-Forscher sehen in ihm den perfekten Kandidaten für weitere Forschung, denn einen Wissenschaftler mit ethischem Kompass könne die KI-Branche gut gebrauchen. Umgekehrt wird Redmons Rückzug die KI-Forschung sicher nicht zurückhalten.

Quelle: Twitter, Arxiv

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.