Cerebras Systems hat seinen dritten Waferscale-KI-Chip WSE-3 vorgestellt, der die doppelte Leistung seines Vorgängers erreichen soll und einen 8-Exaflops-Supercomputer in Dallas antreiben wird.

Cerebras Systems hat mit dem WSE-3 die dritte Generation seines Wafer-Scale-KI-Megachips vorgestellt. Nach Angaben des Unternehmens soll der Chip bei gleichem Stromverbrauch doppelt so leistungsfähig sein wie sein Vorgänger.

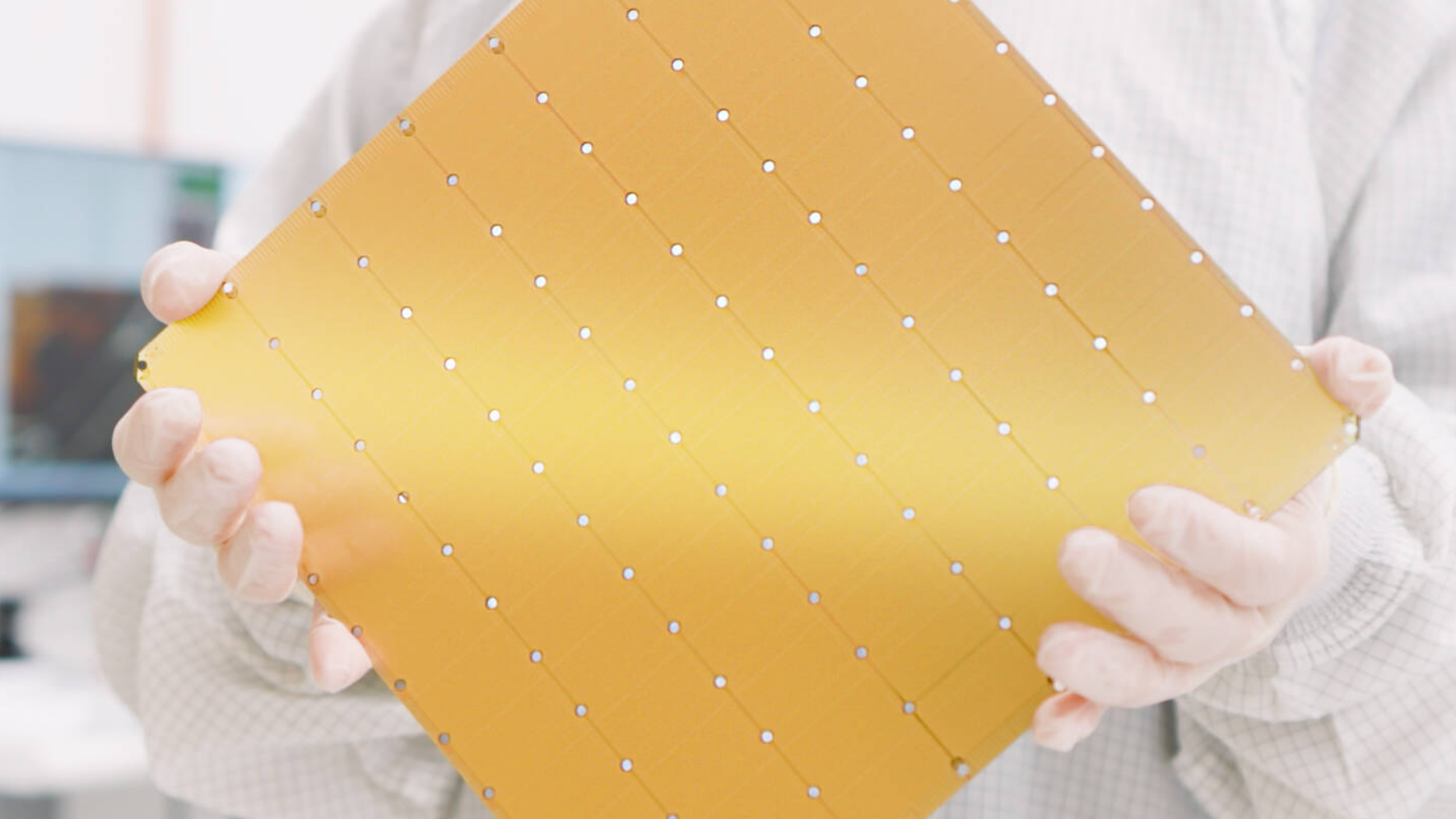

Mit 4 Billionen Transistoren und einer um mehr als 50 Prozent erhöhten Transistordichte dank neuester Chipfertigungstechnologie setzt Cerebras seine Tradition fort, den größten Einzelchip der Welt herzustellen. Der quadratische Chip mit einer Kantenlänge von 21,5 Zentimetern nutzt fast eine ganze 300-Millimeter-Siliziumscheibe.

Seit dem ersten Megachip WSE-1 im Jahr 2019 hat sich die Anzahl der Transistoren damit mehr als verdreifacht. Der neueste Chip, WSE-3, wird mit der 5-Nanometer-Technologie von TSMC gebaut, nachdem der WSE-2 2021 mit der 7-Nanometer-Technologie des Unternehmens debütieren wird.

WSE-3 basierte Supercomputer sollen KI-Training auf einer neuen Skala ermöglichen

Der um den neuen KI-Chip herumgebaute Computer, der CS-3, soll in der Lage sein, neue Generationen riesiger Sprachmodelle zu trainieren, die zehnmal größer sind als OpenAIs GPT-4 und Googles Gemini. Cerebras gibt an, dass der CS-3 neuronale Netzwerkmodelle mit bis zu 24 Billionen Parametern trainieren kann, ohne auf Softwaretricks zurückgreifen zu müssen, die andere Computer benötigen.

Bis zu 2.048 Systeme können kombiniert werden, eine Konfiguration, die ein Training eines Sprachmodells wie Llama 70B in nur einem Tag durchführen könnte. Der erste auf CS-3 basierende Supercomputer, Condor Galaxy 3 in Dallas, wird aus 64 CS-3s bestehen und soll so auf 8 Exaflops Leistung kommen. Besitzer des Systems ist wie bei den CS-2-basierten Schwesteranlagen Abu Dhabis G42.

Cerebras hat außerdem eine Partnerschaft mit Qualcomm getroffen, die darauf abzielt, Preise für KI-Inferenz um das Zehnfache zu reduzieren. Dafür will das Team KI-Modelle CS-3-Systemen trainieren und anschließend mit Methoden wie Pruning effizienter machen. Die von Cerebras trainierten Netzwerke sollen dann auf Qualcomms neuem Inferenzchip, dem AI 100 Ultra, laufen.