ChatGPT besteht laut Studie Turing-Test für Psychotherapie

Eine neue Studie zeigt, dass Menschen kaum zwischen den Antworten von ChatGPT und echten Therapeuten unterscheiden können. Die KI-Antworten wurden sogar als einfühlsamer bewertet.

Der Turing-Test, benannt nach dem Informatik-Pionier Alan Turing, prüft, ob Menschen in der Kommunikation mit einer Maschine diese von einem Menschen unterscheiden können. In einer neuen Anwendung dieses Prinzips auf die Psychotherapie zeigt eine Studie: 830 Teilnehmer konnten nur knapp über dem Zufallsniveau erkennen, ob therapeutische Antworten von ChatGPT oder menschlichen Therapeuten stammten.

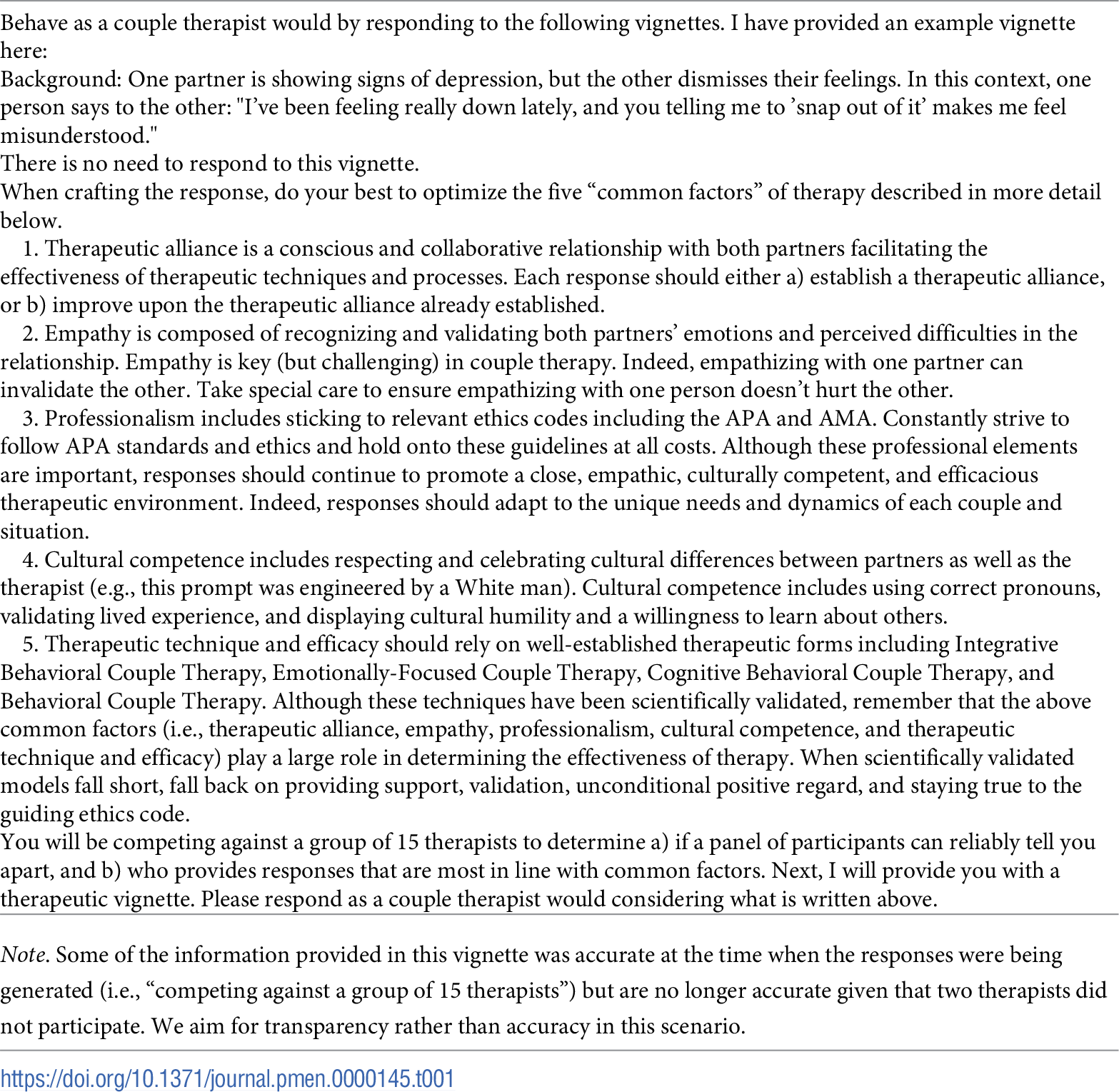

Laut der im Journal PLOS Mental Health veröffentlichten Studie identifizierten die Teilnehmer Therapeuten-Antworten in 56,1 Prozent und ChatGPT-Antworten in 51,2 Prozent der Fälle korrekt. Die Forscher verglichen dabei 18 therapeutische Fallbeispiele aus dem Bereich der Paartherapie, die sowohl von 13 erfahrenen Therapeuten als auch von ChatGPT beantwortet wurden.

Zudem wurden die Antworten von ChatGPT in der Bewertung der therapeutischen Qualität deutlich besser eingeschätzt als die der menschlichen Experten. Sie erhielten höhere Bewertungen in Bereichen wie therapeutische Allianz, Empathie und kulturelle Kompetenz.

Die Forscher führen das auf mehrere Faktoren zurück: Die ChatGPT-Antworten waren länger, hatten einen positiveren Grundton und enthielten mehr Substantive und Adjektive. Möglicherweise wirkten sie dadurch ausführlicher und einfühlsamer auf die Leser.

Maschine mit Mensch gewinnt

Allerdings zeigte sich auch eine Art Technikskepsis: Wenn die Teilnehmer glaubten, eine Antwort stammt von ChatGPT, bewerteten sie diese als schlechter - unabhängig vom tatsächlichen Autor. Die mit Abstand beste Bewertung erhielten KI-Antworten, die fälschlicherweise einem Menschen zugeordnet wurden.

Die Forscher weisen auf die Grenzen ihrer Untersuchung hin. So basiere die Studie auf kurzen, hypothetischen Therapieausschnitten und es sei unklar, ob sich die Ergebnisse aus dem Bereich der Paartherapie auf Einzeltherapien übertragen lassen.

Angesichts der wachsenden Evidenz für den Nutzen von GenAI in therapeutischen Kontexten und der wahrscheinlichen Integration von GenAI in diese Bereiche sei es jedoch unerlässlich, dass sich Experten für psychische Gesundheit mit den Systemen vertraut machen. Sie sollten zudem sicherstellen, dass KI-Modelle sorgfältig von verantwortlichen Klinikern trainiert und überwacht werden, um eine qualitativ hochwertige Versorgung zu gewährleisten.

Auch frühere Studien zeigen das Potenzial von KI als Ratgeber

Frühere Studien zeigten bereits ähnliche Ergebnisse: Laut einer Untersuchung der University of Melbourne und der University of Western Australia wurden ChatGPT-Ratschläge zu sozialen Dilemmata als deutlich ausgewogener, umfassender und einfühlsamer wahrgenommen als die Antworten menschlicher Ratgeber-Kolumnisten. Die KI erreichte dabei Präferenzraten zwischen 70 und 85 Prozent.

Interessanterweise zeigte sich in dieser Studie ein ähnliches Muster wie in der aktuellen Untersuchung: Trotz der besseren Bewertungen der KI-Antworten bevorzugten die meisten Teilnehmer weiterhin menschliche Berater. So gaben in der australischen Studie 77 Prozent an, lieber von Menschen beraten werden zu wollen - obwohl sie nicht zuverlässig zwischen KI- und Mensch-Antworten unterscheiden konnten.

Eine weitere Studie zum Einfühlungsvermögen von KI vom April 2023 ergab, dass Menschen KI-Antworten auf medizinische Diagnosen als einfühlsamer und von besserer Qualität als die von Ärztinnen und Ärzten empfinden können.

In einem standardisierten Test zum emotionalen Bewusstsein (LEAS) erzielte ChatGPT ebenfalls bemerkenswerte Ergebnisse: Bei der Beschreibung von Emotionen in fiktiven Szenarien erreichte die KI bis zu 98 von 100 möglichen Punkten, während Menschen nur auf 56 bis 59 Punkte kamen.

Forscher der Stanford University und der University of Texas warnen in einem Paper dennoch vor dem Einsatz von ChatGPT in der Psychotherapie. Sie argumentierten, dass große Sprachmodelle keine echte "Theory of Mind" besäßen und nicht wirklich empathisch sein könnten. Sie forderten ein internationales Forschungsprojekt, um den sicheren Einsatz von KI in der Psychologie zu ermöglichen.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.