CLIPN: Neue Computer-Vision-Methode bringt KI das "Nein"-Sagen bei

CLIPN bringt CLIP die "Semantik von Negationen" bei. Das soll in der Computer Vision helfen, Klassen zu erkennen, die nicht Teil der Trainingsdaten waren.

Computer-Vision-Modelle erkennen Objekte in den Bildern, mit denen sie trainiert wurden. In realen Anwendungen stoßen diese Modelle jedoch häufig auf unbekannte Objekte außerhalb ihrer Trainingsdaten, was zu schlechten Ergebnissen führt. KI-Forschende haben verschiedene Techniken vorgeschlagen, um KI-Modelle in die Lage zu versetzen, zu erkennen, wenn Eingaben "out-of-distribution" (OOD) sind - also aus unbekannten Klassen stammen, die während des Trainings nicht gesehen wurden. Bisherige Methoden haben jedoch ihre Grenzen, wenn es darum geht, OOD-Beispiele zu identifizieren, die bekannten Klassen ähneln.

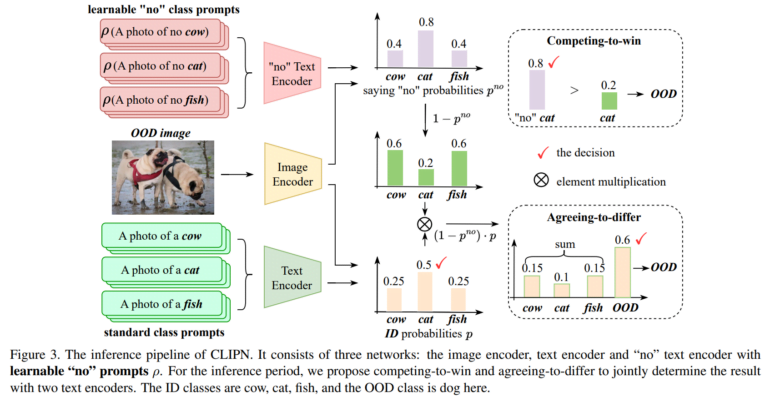

Forschende der Hong Kong University of Science and Technology haben nun eine neue Technik namens CLIPN entwickelt, die die OOD-Erkennung verbessern soll, indem sie dem bekannten CLIP-Modell beibringen, unbekannte Eingaben abzulehnen. Die Grundidee besteht darin, sowohl positive als auch negative Texthinweise zusammen mit benutzerdefinierten Trainingstechniken zu verwenden, um CLIP ein Gespür dafür zu geben, wann eine Eingabe OOD ist.

Die Herausforderung: Schwer zu unterscheidende Unbekannte

Angenommen, ein Modell wurde mit Bildern von Katzen und Hunden trainiert. Wenn es ein Bild eines Eichhörnchens verarbeiten soll, ist das Eichhörnchen eine "Out-of-Distribution"-Klasse, da es nicht zu den bekannten Klassen Katze und Hund gehört.

Viele OOD-Erkennungsmethoden bewerten, wie gut eine Eingabe zu bekannten Klassen passt. Diese Methoden könnten jedoch das Bild des Eichhörnchens fälschlicherweise als Katze oder Hund klassifizieren, da es visuelle Ähnlichkeiten aufweist.

CLIPN erweitert CLIP daher um neue lernbare "Nein"-Prompts und "Nein" Text-Encoder, um die Semantik von Negationen zu erfassen. Auf diese Weise lernt CLIP, wann und wie es "Nein" sagen soll, um zu erkennen, wann ein Bild außerhalb der bekannten Klassen liegt. Die CLIPN-Technik bringt dem Modell also bei, im Fall des Eichhörnchens "Nein, das ist keine Katze/kein Hund" zu sagen und damit die Klasse als OOD zu markieren.

In Experimenten zeigt das Team, dass CLIPN OOD-Beispiele identifiziert, die das Standard CLIP nicht erkennt. Den Forschenden zufolge verbessert CLIPN die OOD-Erkennung in 9 Referenzdatensätzen im Vergleich zu bestehenden Methoden um bis zu knapp 12 Prozent.

Es sei jedoch noch unklar, ob die Methode auch für spezialisierte Datensätze wie medizinische oder Satellitenbilder funktioniert und ob sie für andere Anwendungen wie Bildsegmentierung geeignet ist.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.