Cosine Genie: Neue Coding-KI schlägt Konkurrenz um Längen, weil es wie ein Entwickler denkt

Das KI-Startup Cosine hat mit Genie ein neues Modell zur Unterstützung von Softwareentwicklern vorgestellt. In Benchmarks übertrifft es die Konkurrenz deutlich. Der Schlüssel zum Erfolg soll die Nachahmung menschlichen Denkens sein.

Cosine, ein KI-Startup aus San Francisco, hat mit Genie ein neues KI-Modell vorgestellt, das - wie viele Konkurrenten auch - Software-Entwickler:innen bei ihrer Arbeit unterstützen soll.

In Zusammenarbeit mit OpenAI konnten sie jedoch eine GPT-4o-Variante mit hochwertigem Material trainieren, die zumindest in Benchmarks überzeugende Ergebnisse zeigt. Schlüssel zum Erfolg soll es gewesen sein, "menschliches Denken" zu kodieren. Das soll nicht nur Vorteile in der Softwareentwicklung bringen.

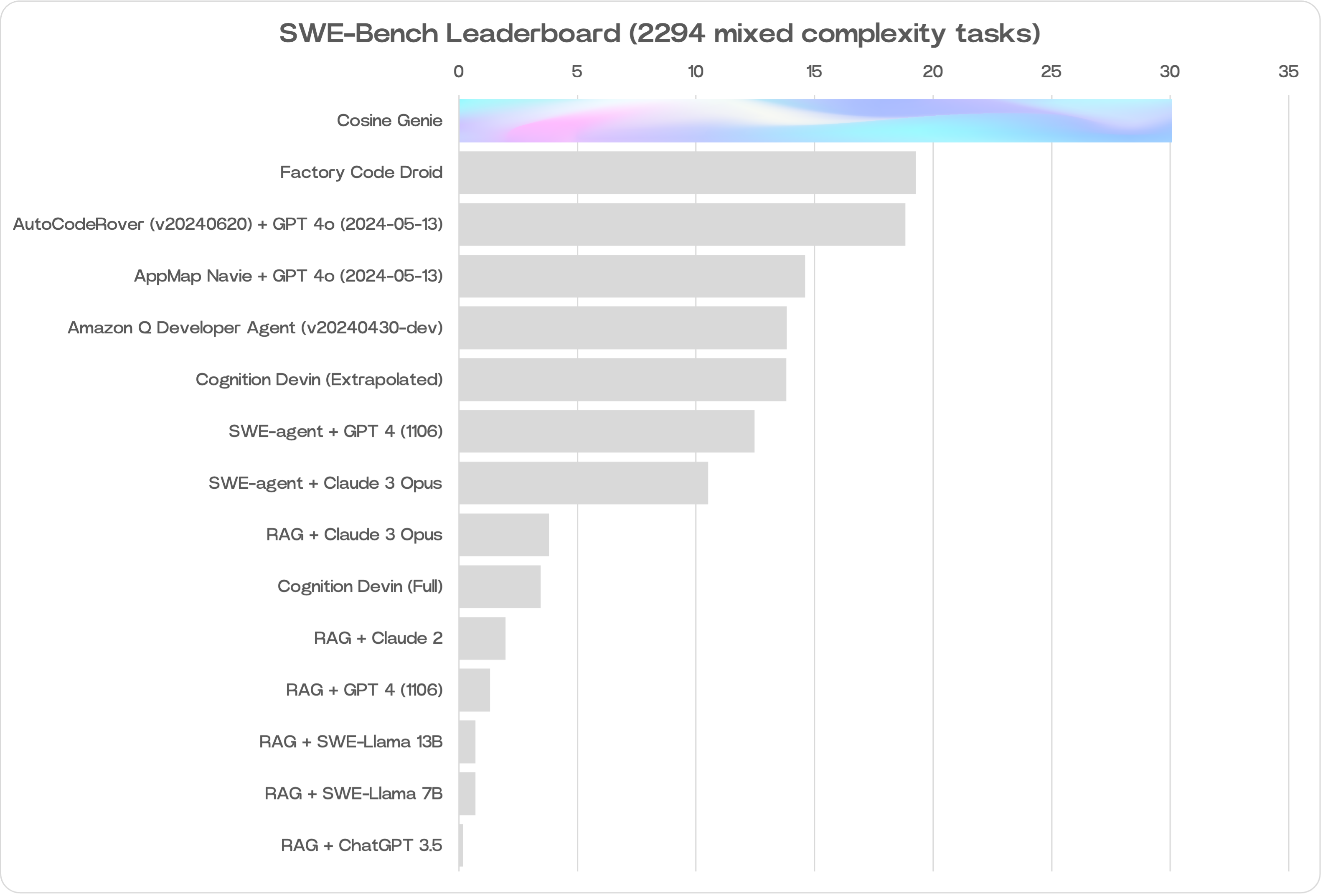

Großer Abstand in SWE-Bench

Laut Cosine-Mitbegründer und CEO Alistair Pullen erreichte Genie eine Punktzahl von 30 Prozent im SWE-Bench-Test. Das ist die höchste Punktzahl, die je von einem KI-Modell in diesem Bereich erzielt wurde.

Genie übertrifft daran gemessen die Leistung anderer auf Coding spezialisierter Sprachmodelle wie denen von Amazon (19 Prozent) oder Devin von Cognition (13,8 Prozent auf einem Teil von SWE-Bench). Letzteres weckte bei seiner Vorstellung im März mit ähnlichen Behauptungen wie solchen von Cosine große Erwartungen, ist aber noch immer nicht frei zugänglich.

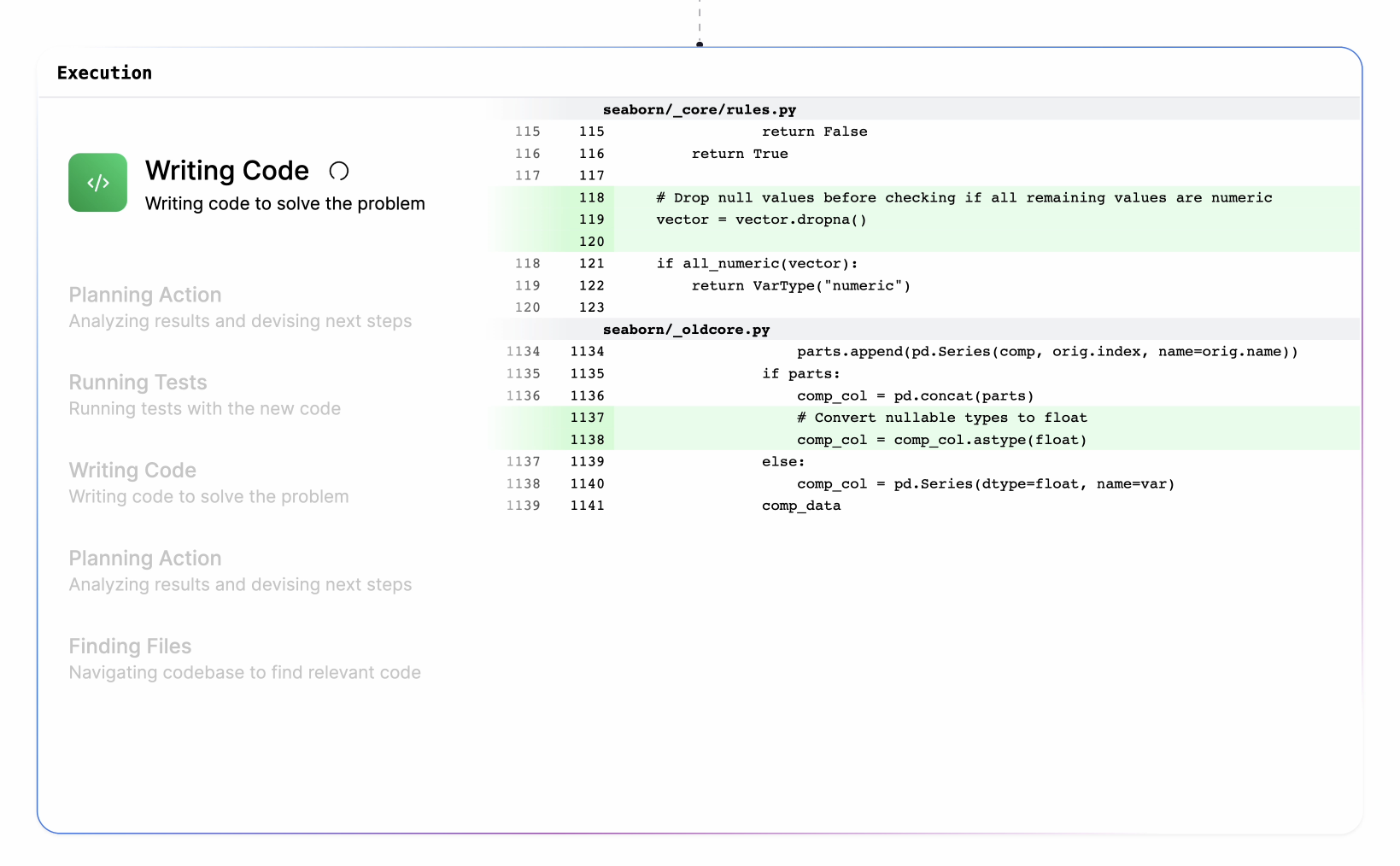

Die Architektur von Genie ist darauf ausgelegt, die kognitiven Prozesse menschlicher Entwickler:innen nachzuahmen, sodass es sowohl selbstständig als auch in Zusammenarbeit Fehler beheben, neue Softwarefunktionen entwickeln, Code umstrukturieren und verschiedene programmierbezogene Aufgaben ausführen kann.

Die KI wurde mit einem proprietären Verfahren entwickelt, bei dem eine nicht öffentliche Variante des neusten OpenAI-Modells GPT-4o mit Milliarden von Token an hochwertigen Daten trainiert und feinabgestimmt wurde, die Cosine fast ein Jahr lang mithilfe von erfahrenen Entwickler:innen kuratiert hatte. Der Mix besteht zu jeweils 21 Prozent aus JavaScript und Python, zu jeweils 14 Prozent aus TypeScript und TSX sowie zu jeweils drei Prozent aus weiteren Sprachen von Java über C++ bis Ruby.

Ein wesentlicher Faktor für Genies Leistungssteigerung sei das selbstverbessernde Training gewesen. Zunächst lernte das Modell hauptsächlich anhand von perfektem, funktionierendem Code, konnte dadurch aber auch schlecht mit eigenen Fehlern umgehen.

Hier schafften synthetische Daten Abhilfe: War Genies erster Lösungsvorschlag fehlerhaft, zeigte man dem Modell anhand des korrekten Ergebnisses, wie es sich verbessern kann. Mit jeder Wiederholung dieses Prozesses wurden Genies Lösungen besser und erforderten immer weniger Korrekturen.

Technologie holt die Vision ein

Pullen sah schon Anfang 2022 das Potenzial von großen Sprachmodellen, menschliche Softwareentwickler:innen zu unterstützen. Damals jedoch habe die Technik noch nicht ausgereicht, um die Vision von Genie in die Realität umzusetzen.

Vor allem das Kontextfenster, zu der Zeit in vielen Fällen bei nur 4.000 Tokens, stellte sich als Flaschenhals heraus. Mittlerweile können Modelle wie Gemini 1.5 Pro bis zu zwei Millionen Tokens in einem Prompt verarbeiten. Mit wie vielen Tokens Genie umgehen kann, verrät Cosine nicht.

Cosine sieht sich vor allem gegenüber Codinghilfen im Vorteil, die lediglich generelle Modelle wie GPT-4 in einem eigenen Produkt verpacken. "Jeder, der an diesem Problem arbeitet, stößt an dieselbe Grenze der Modellintelligenz, weshalb wir uns dafür entschieden haben, eher zu trainieren als zu prompten", erklärt Pullen.

Video: Alistair Pullen/X

Software ist nur der Anfang

In Zukunft plant Cosine, sein Portfolio auf kleinere, spezialisierte und größere, allgemeinere Modelle zu erweitern, seine Arbeit in Open-Source-Communities auszudehnen und die Fähigkeiten von Genie basierend auf Feedback seiner Kund:innen regelmäßig zu erweitern. Künftig sei bei der Größe des Datensets auch ein vollständiges Modelltraining nicht ausgeschlossen.

Nicht nur Programmierer:innen sollen von dem Konzept profitieren: "Wir glauben fest daran, dass wir in der Lage sind, das menschliche Denken für jeden Beruf und jede Branche zu kodifizieren. Software ist nur der intuitivste Ausgangspunkt, und wir können es kaum erwarten, euch zu zeigen, woran wir sonst noch arbeiten."

Das Unternehmen plant, Genie in zwei Preisstufen anzubieten: eine Option für rund 20 US-Dollar mit einigen Funktions- und Nutzungseinschränkungen und ein Angebot auf Unternehmensebene mit erweiterten Funktionen und praktisch unbegrenzter Nutzung. Bisher können sich Interessenten nur auf eine Warteliste setzen lassen.

Die Ausgründung des bekannten Inkubators Y Combinator hat kürzlich 2,5 Millionen US-Dollar an Seed-Finanzierung von verschiedenen Risikokapitalfirmen erhalten, um die Entwicklung von Genie und zukünftige Pläne zu unterstützen.

Cosine scheint logische Erkenntnisse aus der jüngsten KI-Entwicklung sinnvoll kombiniert zu haben. Training kann zu besseren Ergebnissen führen als reines Prompt Engineering, die Nachahmung menschlicher Arbeit ebenfalls und die Qualität der Datenbasis spielt ohnehin eine übergeordnete Rolle. Dass aber die Kombination dieser Bausteine zu einem so signifikanten Benchmark-Vorsprung führt, ist durchaus überraschend.

Die potenziellen Auswirkungen von KI-Modellen wie Genie auf die Softwareentwicklungsbranche sind erheblich, da sie die Produktivität steigern und es den Teams ermöglichen könnten, sich auf strategischere Initiativen zu konzentrieren. Bislang gibt es jedoch nur die vom Unternehmen selbst veröffentlichten Benchmarks, um sich ein Bild von der angeblichen Leistung zu machen.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.