Hollywood verliert dank neuer KI-Verfahren das Monopol auf lebensechte Spezialeffekte: Forscher zeigen, wie man in Videos mit dem Gesicht einer anderen Person sprechen kann.

Im Dezember 2017 hatte der Reddit-Nutzer "Deepfakes" seinen großen Auftritt: Ein von ihm entwickelter KI-Algorithmus ersetzt das Gesicht einer Person in einem Video durch ein anderes - und zwar glaubhaft, einfach und schnell. Deepfakes und seine Anhänger nutzten die Technologie, um Promi-Pornos zu fälschen (Hintergrundinfos).

Das sorgte für eine Ethik-Debatte zu KI und Video-Manipulation, in deren Folge die Deepfakes-Gruppe bei Reddit und anderen Online-Plattformen gesperrt wurde. Zu spät, versteht sich, denn die Deepfakes Fake-App ist längst frei im Internet verfügbar. Ohnehin basiert der Algorithmus auf Googles frei verfügbarer Software-Bibliothek Tensorflow.

Deep Video Portrait ist krasser als Deepfakes

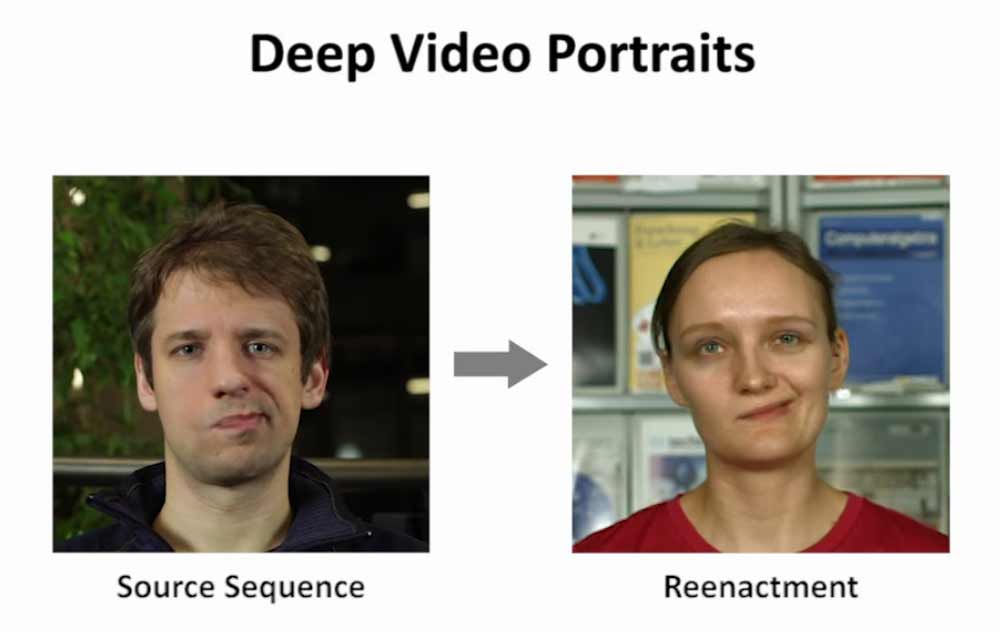

Mit "Deep Video Portrait" stellen Forscher auf der Siggraph 2018 eine neue Methode zur Video-Manipulation mittels Deep-Learning-Verfahren vor, die für noch mehr Zündstoff sorgen könnte als Deepfakes.

Die Mimik wird - das ist neu - samt Kopfbewegungen von einer Person auf das Gesicht einer zweiten Person in einem Video projiziert.

Das System erkennt und überträgt laut den Entwicklern Kopfbewegungen in drei Dimensionen, Kopfdrehung, den Gesichtsausdruck, die Blickrichtung und Blinzler. Sogar der Schatten, den der Kopf auf den Hintergrund wirft, wird im Nachhinein perspektivisch korrekt in das Video gerechnet.

Die Stimme wird zwar noch nicht angepasst, aber dafür gibt es andere Algorithmen.

Glaubhaft gefälschte Videos im Handumdrehen

Laut den Forschern kann das KI-System schon jetzt gefälschte Videos erstellen, die kaum mehr als solche zu erkennen sind. Wenige Minuten Videomaterial der Zielperson, zum Beispiel aus Web-Videos, und eine schnelle Spielegrafikkarte sollen für das KI-Training und die notwendigen Berechnungen ausreichen.

In einem Demovideo (siehe unten) stellen die Forscher den Qualitätssprung ihres Verfahrens im Vergleich zu ähnlichen Manipulationstechniken aus 2016 und 2017 vor. Das zeigt, wie schnell die Entwicklung voranschreitet.

Wissenschaftler wollen aufklären

Man sei sich den ethischen Implikationen dieser Software bewusst, sagt Mitentwickler Justus Theis von der TU München gegenüber der Webseite The Register. Gerade daher habe man sich dafür entschieden, die Ergebnisse zu publizieren.

"Ich denke, es ist wichtig, dass die Leute Bescheid wissen über diese Manipulationsmethoden", sagt Theis. Menschen müssten zukünftig kritischer mit Videos umgehen, insbesondere wenn deren Ursprung unbekannt sei.

Theis ist laut The Register involviert in eine von der US-Behörde DARPA finanziell unterstützte Forschergruppe, die Erkennungssysteme für KI-Fakes entwickeln soll.