Die KI-Forscher von Deepmind haben einem neuronalen Netz antrainiert, die Auswirkungen einfacher Objekte aufeinander zu verstehen. Das Experiment zeigt, dass Deep Learning symbolische KI-Systeme ersetzen könnte.

Innerhalb der KI-Forschung existiert eine zentrale Debatte über die Zukunft Künstlicher Intelligenz: Auf der einen Seite stehen Forscher wie Geoffrey Hinton, die im Deep Learning-Ansatz die ultimative Lösung für alle Aufgaben sehen.

Auf der anderen Seite sind Forscher wie Gary Marcus, die hybride Systeme fordern, die Deep Learning und per Hand programmierte symbolische Systeme verbinden.

Der symbolische Ansatz orientiert sich am menschlichen Denken und soll KI zu logischen Schlussfolgerungen befähigen sowie ein Verständnis von Kausalität ermöglichen. Das gilt als notwendiger Schritt auf dem Weg zu menschengleicher Künstlicher Intelligenz.

KI-Forscher Yoshua Bengio etwa nennt diese Fähigkeit zur hochstufigen Kognition in Anlehnung an den Psychologen Daniel Kahneman „System-2“-Kognition und sieht darin einen der drei notwendigen Bausteine für bessere KI.

Neurosymbolische Modelle

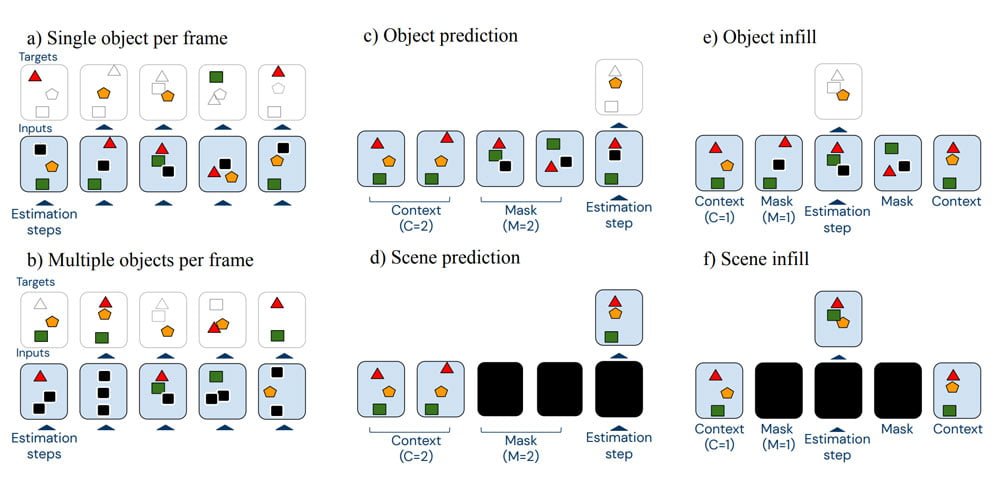

KI-Systeme, die Deep Learning und symbolische KI verbinden, werden auch neurosymbolische Modelle genannt. Sie treten in speziellen Benchmarks wie CLEVRER gegeneinander an. Der Datensatz enthält 20.000 fünf Sekunden kurze Videoschnipsel kollidierender Objekte und 300.000 Fragen und Antworten zu den Inhalten.

Alle Fragen fokussieren sich auf vier Elemente des logischen Denkens: beschreibend („Welche Farbe hat ein Objekt?“), erklärend („Was ist für ein Ereignis verantwortlich?“), vorhersagend („Was passiert als Nächstes?“) und kontrafaktisch („Was würde passieren, wenn?“).

Eine KI, die den CLEVRER-Benchmark knacken soll, muss in der Lage sein, einzelne Objekte auseinanderzuhalten, sie als physikalische Objekte zu verstehen, sie über mehrere Sekunden als das gleiche Objekt zu identifizieren und zugehörige Eigenschaften wie Farben korrekt zuzuweisen. Sie muss außerdem erkennen, dass die Bewegung eines Objekts durch ein anderes ausgelöst wurde.

Nun hat Deepmind eine Forschungsarbeit veröffentlicht, die zeigt, dass ein neuronales Netz mit dem richtigen Training besser im CLEVRER-Benchmark abschneidet als aktuelle neurosymbolische Modelle.

Damit ist zwar die große Debatte innerhalb der KI-Forschung noch nicht beendet, aber Deepminds Arbeit zeigt deutlich, dass noch nicht endgültig geklärt ist, wo die Grenzen neuronaler Netze (Erklärung) liegen.

Ein bisschen mehr Aufmerksamkeit

Deepminds KI setzt wie nahezu jeder große KI-Fortschritt der letzten Monate auf die Transformer-Architektur (Erklärung). Der vorgeschaltete Objekterkennungsalgorithmus MONet liefert Objektinformationen an den Transformer-Baustein, ein weiterer Algorithmus repräsentiert die zu den Bildern zugehörigen Fragen und gibt sie an den Transformer. Der verknüpft beide Informationen, um die Antwort auf die Frage zu finden.

Beim KI-Training maskiert Deepmind einzelne Objekte oder ganze Bilder aus dem Videoclip. Die KI muss dann anhand der noch zu erkennenden Objekte und ihrem Verhalten Rückschlüsse auf die verdeckten Objekte ziehen.

Dieser selbstüberwachte Lernansatz – eine Variante des unüberwachten Lernens - wird auch bei anderen Transformer-KIs genutzt, etwa bei Googles Sprach-KI BERT oder Microsofts DeBERTa, die damit jüngst den Sprach-Benchmark SuperGLUE schlug.

Deepminds KI schlägt neurosymbolische Modelle

Deepminds Forscher schreiben, ihr Ansatz schlage die besten neurosymbolischen Modelle ohne aufwendig per Hand aufgearbeitete Daten und das bei knapp 40 Prozent weniger Trainingsdaten.

Bei der Szenen-Beschreibung erreicht Deepmind knapp 94 von 100 Punkten und liegt damit vier Punkte vor den bis dato besten Modellen. Bei Erklärungen liegt sie knapp 14 Punkte vorne, bei der Vorhersage von Ereignissen etwa 5 Punkte und bei den als besonders schwer geltenden kontrafaktischen Aufgaben sogar fast 30 Punkte.

Zusätzlich generalisiert die für CLEVRER trainierte KI zum verwandten CATER-Benchmark, einer Objekt-Tracking-Aufgabe, wo die Position eines bestimmten Objekts im letzten Bild eines Videos vorhergesagt werden muss.

Die Ergebnisse zeigten, dass neuronale Netze tatsächlich lernen könnten, effektiv über die „kausale, dynamische Struktur physikalischer Ereignisse nachzudenken“, schreiben die Forscher. Nun brauche es neue Benchmarks dieser Art, damit das ganze Potenzial neuronaler Netze empirisch bestimmt werden könne.

Via: Arxiv | Titelbild: via MIT IBM Watson AI Lab