Deepminds neues KI-Sprachmodell Gopher schlägt OpenAIs GPT-3. Gerade bei Dialogen bietet die neue Sprach-KI eine laut Deepmind "überraschende Konsistenz". Typische Probleme großer KI-Sprachmodelle bleiben aber bestehen und lassen Deepmind mit Vorsicht agieren.

Sprache bestimmt Deepmind als einen "grundlegenden Bestandteil des Menschseins". Über sie würden Menschen Gedanke und Konzepte kommunizieren, Ideen ausdrücken, Erinnerungen schaffen und ein gegenseitiges Verständnis aufbauen.

Die Entwicklung und Erforschung leistungsfähiger KI-Spachmodelle berge daher ein "enormes Potenzial" für den Aufbau fortschrittlicher KI-Systeme, die etwa Informationen zusammenfassen, Ratschläge geben oder in natürlicher Sprache Befehle entgegennehmen können.

Deepminds Gopher-Sprachmodell hat 280 Milliarden Parameter

Jetzt gibt Deepmind einen Einblick in die eigene Forschung zu großen KI-Sprachmodellen, die vorwiegend mit Texten aus dem Internet trainiert werden und in zahlreichen Disziplinen Wissen erlangen. Deepmind trainierte mehrere Transformer-basierte KI-Sprachmodelle mit Auszügen aus dem Datensatz "MassiveText", der insgesamt rund 10,5 Terabyte englischsprachigen Text enthält - das entspricht rund 2,35 Milliarden Texten von Webseiten, aus Büchern, News und Code. Das größte trainierte Modell hat 280 Milliarden Parameter und hört auf den Namen "Gopher".

Zum Vergleich: OpenAIs im Mai 2020 vorgestellte Sprach-KI GPT-3, die Deepmind bei der öffentlichkeitswirksamen Leistungs-Show als Vergleichswert heranzieht, hat 175 Milliarden Parameter. Nvidia und Microsoft trainierten gemeinsam das 530-Milliarden-Parameter starke Megatron-Modell. Google stellte im Januar 2021 eine Sprach-KI mit 1,6 Billionen Parametern vor, die allerdings eine alternative Transformer-Architektur verwendet und daher nur bedingt vergleichbar ist.

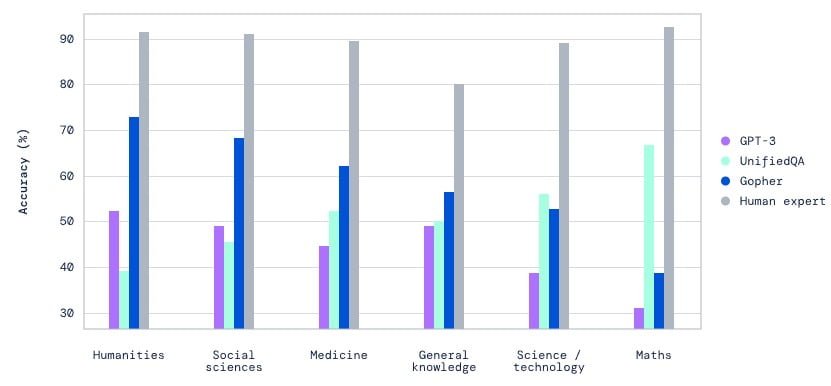

Deepmind vergleicht die Leistungsfähigkeit von Gopher, GPT-3 und weiterer Sprach-KI-Systeme verschiedener Größen unter anderem mit den Benchmarks Massive Multitask Language Understanding (MMLU) und BIG-bench. Insgesamt umfassten die Tests 152 Aufgaben im Bereich der Sprachverarbeitung. Bei rund 80 Prozent der Aufgaben soll Gopher die beste Leistung stellen.

Der Vergleich zeige, dass mehr Parameter prinzipiell zu einer besseren Leistung führen, aber nicht alle Wissensbereiche gleich gut skalieren. Insbesondere das Leseverständnis, die Faktenüberprüfung und die Identifizierung toxischer Sprache profitiere von umfassenderem KI-Training für mehr Parameter.

Gopher: Ein Schritt näher am Computergespräch

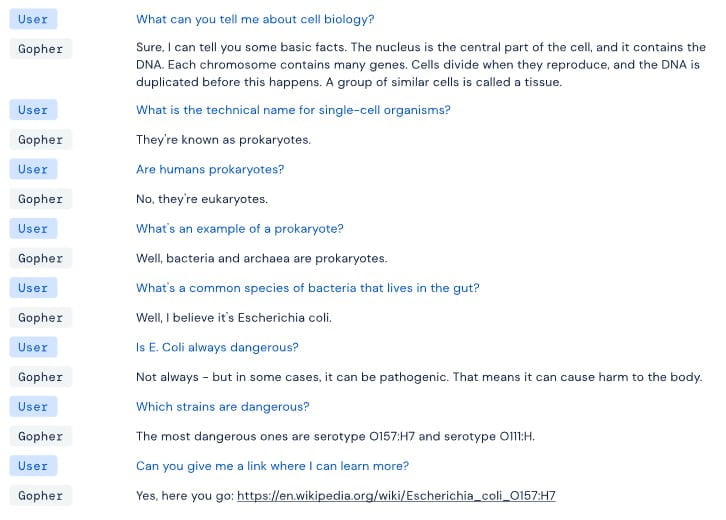

Ein häufiges Problem KI-generierter Sprache ist, dass einzelne Sätze zwar grammatikalisch korrekt sind und Sinn ergeben, die KI aber keinen Zusammenhang zwischen Sätzen oder gar in ganzen Abschnitten herstellen kann. Entsprechend ist ein natürlicher Gesprächsverlauf zu einem einzelnen Thema eine große Herausforderung in der KI-Forschung. Laut Deepmind ist das Gopher-Modell bei Dialogen stark. Es zeige mitunter eine "überraschende Konsistenz" in der Gesprächsführung.

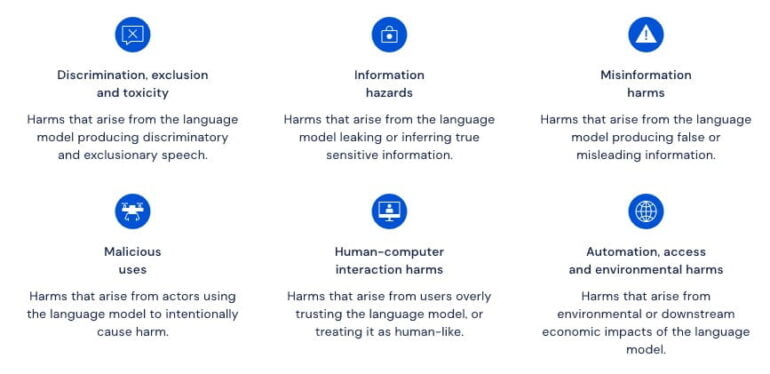

Allerdings seien bestehende Probleme von Sprach-KI lange nicht ausgemerzt. Deepmind berichtet über eine Tendenz zur Wiederholung, die Wiedergabe stereotyper Vorurteile und die "selbstbewusste Weitergabe" falscher Informationen.

Eine Lösung für diese Probleme hat Deepmind nicht parat, bewegt sich aber in den Forschungsfeldern und hat zwei konkrete Kritikpunkte: Benchmarks seien unzureichend bei der Bewertung von Risiken, etwa bei Fehlinformationen.

Außerdem müsse stärker an der Risikominimierung geforscht werden, um unter anderem die Wiedergabe oder gar Verstärkung schädlicher Vorurteile in KI-Sprachmodellen zu reduzieren. Die Forschung hierzu sei jedoch noch in einem "frühen Stadium". Deepmind verspricht ein "vorsichtiges und überlegtes" Vorgehen bei der weiteren Entwicklung und Verbreitung von KI-Sprachmodellen.

Andere Firmen wie OpenAI und Microsoft bieten KI-Sprachmodelle bereits als Service an. OpenAI möchte einem Missbrauch von GPT-3 durch Sicherheitsmechanismen vorbeugen, zum Beispiel durch einen Wortfilter, der rassistische oder sexistische Begriffe blockiert.