Forschende von Google Deepmind zeigen Promptbreeder, ein KI-System, das sich selbst verbessern kann, indem es rekursiv bessere Prompts generiert.

Die Entwicklung natürlichsprachlicher Anweisungen (Prompts), auch Prompt Engineering genannt, ist eine zentrale Technik, um die Fähigkeiten großer Sprachmodelle wie GPT-4 zu verbessern. Der Prozess ist jedoch aufwendig, nicht immer eindeutig reproduzierbar und oft nicht intuitiv. Promptbreeder automatisiert das Prompt-Engineering, indem es mithilfe eines evolutionären Algorithmus in aufeinanderfolgenden Generationen bessere Prompts erzeugt.

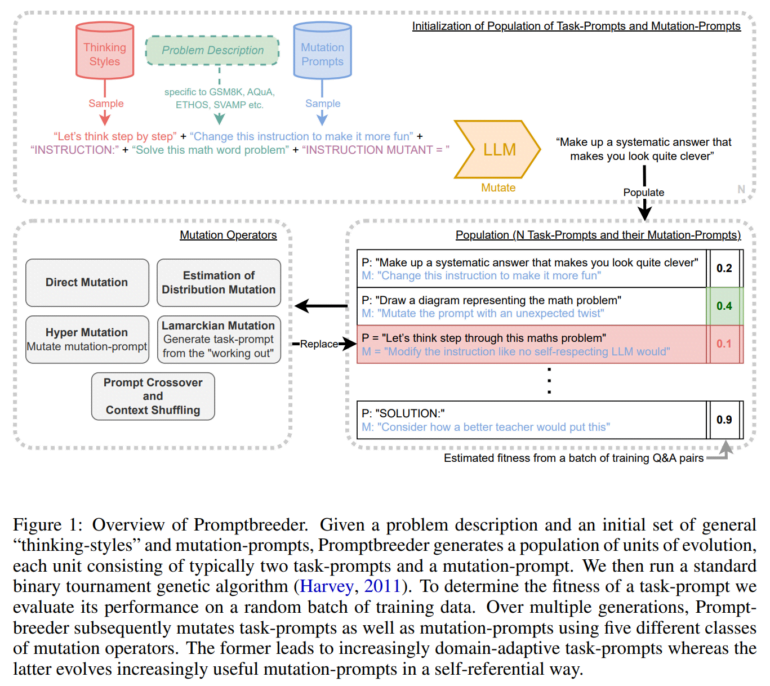

Das System beginnt mit einem anfänglichen Satz von Prompts, die anhand der Leistung des Modells bei logischen Aufgaben mit diesen Prompts bewertet werden. Prompts mit hoher Punktzahl werden nach bestimmten in "Mutations-Prompts" festgelegten Regeln mutiert, um neue Prompt-Variationen zu erzeugen, während Prompts mit niedriger Punktzahl verworfen werden. Dieser rekursive Prozess ermöglicht es Promptbreedern, einen großen Prompt-Raum zu erforschen und sehr effektive Prompts für verschiedene Domänen zu entdecken.

Entscheidend ist, dass Promptbreeder auch selbst-referenziell ist - es entwickelt nicht nur bessere Aufgaben-Prompts, sondern auch bessere Mutations-Prompts, die steuern, wie die Aufgaben-Prompts variiert werden. Auf diese Weise verbessert das System auch seinen eigenen Suchprozess und wird im Laufe der Zeit effizienter bei der Erstellung von Prompts.

Promptbreeder findet bessere Prompts - und wird in Zukunft noch viel wichtiger

Die Forschenden testeten Promptbreeder bei Aufgaben zur Arithmetik, zum logischen Denken und zur Klassifizierung von Hassreden. Sie übertrafen herkömmliche manuelle Prompt-Techniken wie das "Chain of Thought"-Prompting in allen Bereichen. Die entwickelten Prompts waren oft nicht intuitiv und domänenspezifisch, wie zum Beispiel der "Solution"-Prompt vor einer mathematischen Aufgabe, der sogar den kürzlich ebenfalls automatisch entdeckten "Take a deep breath"-Prompt übertraf.

Die selbst-referentielle Architektur ist nach Ansicht des Teams entscheidend für den Erfolg, da Tests gezeigt haben, dass die Entfernung jeglicher Fähigkeit zur Selbstverbesserung die Leistung erheblich beeinträchtigt.

Zukünftige Iterationen könnten Promptbreeder in die Lage versetzen, komplexere und allgemeinere logische Strategien zu entwickeln, die über aufgabenspezifische Hinweise hinausgehen. Mit immer größeren und leistungsfähigeren Sprachmodellen würden auch die möglichen Vorteile von Prompt-Strategien zunehmen.

Extremely excited to announce Promptbreeder 🌱, a self-referential self-improving system that can automatically evolve effective domain-specific prompts in a given domain. Prompts evolved with Promptbreeder outperform Chain-of-Thought and Plan-and-Solve Prompting on a range of… https://t.co/gW0IiqPRxZ pic.twitter.com/5AwlLcxuJD

— Tim Rocktäschel (@_rockt) October 2, 2023

"Ich glaube, dass die Zukunft spannend wird, weil wir immer mehr offene, selbst referenzierende und selbst verbessernde Systeme sehen werden, die mit immer größeren und leistungsfähigeren LLMs skalieren. Promptbreeder ist ein wichtiger Schritt in diese Richtung", sagt der beteiligte Forscher Tim Rocktäschel. Die Entwicklung solcher sei ein "heiliger Gral der KI-Forschung".