Forscher arbeiten an einer Künstliche Intelligenz, die Emotionen am Gang erkennen soll. Das soll sozial intelligenten Robotern helfen.

Die Evolution des Menschen ist die eines sozialen Wesens. Elementarer Bestandteil dieser Entwicklung ist unsere Fähigkeit, die Emotionen anderer Menschen in deren Gesichtern und Körpersprache zu lesen.

KI-Forscher arbeiten an Lösungen, diese Fähigkeit an Künstliche Intelligenz weiterzugeben. Primäres Forschungsfeld der KI-gestützten Emotionserkennung ist die Analyse von Gesichtsausdrücken. Andere Forscher versuchen, Emotionen anhand der Stimmlage oder dem geschriebenen Wort zu erkennen.

Forscher der Universität Maryland gehen nun - nicht nur bildlich gesprochen - einen Schritt weiter: Sie wollen Emotionen am Gang erkennen.

Soziale Roboter müssen uns verstehen

Die Forschungsgruppe "Geometric Algorithms for Modeling, Motion, and Animation" (GAMMA) arbeitet an sozial intelligenten Robotern. GAMMA-Forscher Aniket Bera ist überzeugt, dass immer mehr Roboter unser Zuhause, Arbeitsplätze und öffentliche Straßen bevölkern werden.

Dort werden sie im engen Kontakt mit Menschen stehen und sollten sich sozial intuitiv verhalten. Das heißt: möglichst nicht im Weg rumstehen, Wünsche erkennen und so weiter. Dafür müssen sie menschliche Emotionen verstehen, Absichten antizipieren, soziale Grenzen einhalten und soziale Erwartungen kennen.

Das sind hohe Ansprüche an eine Maschine: Jeder der schon mal auf dem Bürgersteig seinem Gegenüber ausweichen wollte, nur um ihn ebenfalls in die gleiche Richtung tänzeln zu sehen, weiß, wie komplex selbst simple Bürgersteignavigation mit dem eigensinnigen Verkehrsteilnehmer Mensch sein kann.

Körpersprache ist wichtig

Das Beispiel des Bürgersteigs zeigt, wie wichtig unsere Fähigkeit ist, Körpersprache zu lesen. Je mehr Menschen unterwegs sind, desto weniger Gesichter schauen wir uns an. Körpersprache verrät uns, in welche Richtung jemand möchte, ob er gehetzt oder entspannt ist.

Bera und sein Team starten daher auf ihrem Weg zum sozial intelligenten Roboter mit Körpersprache – denn im Alltag sind Gesichter häufig gar nicht oder nur teilweise zu sehen. Hinzu kommt: Die Forschung hinter der Emotionsanalyse von Gesichtsausdrücken steht nach Ansicht mancher Forscher auf wackeligen Füßen.

Künstliche Rücksichtnahme

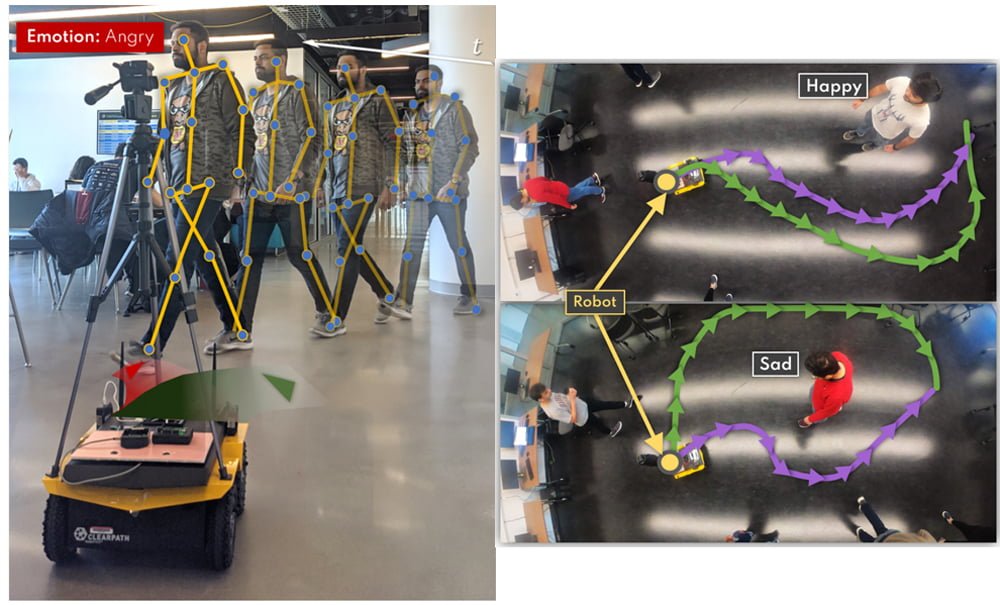

Beras Team stellt jetzt die KI ProxEmo vor, die Emotionen am Gang erkennen soll. Trainiert wurde ProxEmo mit etwa 2.000 Aufnahmen von laufenden Menschen.

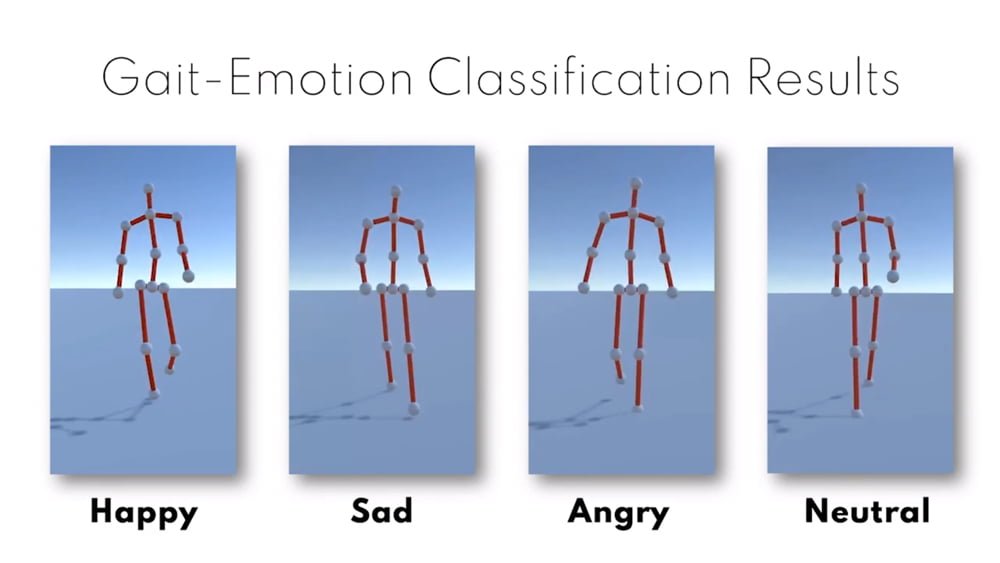

In Tests mit dem etablierten Datensatz Emotion-Gait erreichte ProxEmo eine durchschnittliche Genauigkeit von etwa 82 Prozent in der Emotionserkennung von vier Stimmungen (Wütend, Fröhlich, Traurig, Neutral). Das ist mehr, als vergleichbare Ansätze, schreiben die Forscher. Wie Menschen bei der Bewertung abschneiden, verraten sie nicht.

In einem Experiment nutzen die Forscher ProxEmo für die Steuerung eines Roboters. Erkennt die KI etwa einen wütenden Menschen, ändert sie ihre geplante Route und weicht dem Menschen aus. Erkennt sie einen traurigen Menschen, hält sie mehr Abstand, um nicht zu stören.

Noch fehlen Daten und mehr Informationen

ProxEmo ist Grundlagenforschung, die Anwendungsszenarien begrenzt, die Datensätze klein und die maschinellen Reaktionen auf menschliche Emotionen sind einfach gehalten. Doch wenn unsere Zukunft tatsächlich voller Roboter ist, sollten sie unsere Körpersprache lesen können. Andernfalls müssten sich Menschen den Maschinen anpassen – oder auf Robo-Assistenz verzichten.

Die Forscher wollen ihre KI daher weiterentwickeln: Sie soll neben der Gangart noch weitere Informationen zur Emotionserkennung verwenden und mehr Emotionen erkennen. Als Beispiele nennen die Forscher etwa Aufregung, Ekel oder Verwirrung. Außerdem soll die KI auch kulturunabhängig funktionieren – die Forscher planen kulturelle Kontexte, die menschliche Emotionen beeinflussen, in das Training mit einzubeziehen.

Quelle: Arxiv