Eine neue Studie der Stanford University zeigt, dass KI-Systeme für die juristische Recherche bei einer von sechs Anfragen falsche Informationen liefern. Die Forscher fordern öffentliche und transparente Standards für den Einsatz von KI im Rechtswesen.

Bis zu drei Viertel der Rechtsanwälte sollen den Einsatz von KI in ihrem Arbeitsalltag planen, etwa für Aufgaben wie das Aufsetzen von Verträgen oder die Unterstützung bei Rechtsgutachten.

Eine Preprint-Studie von Forschern des Stanford RegLab und des Stanford Institute for Human-Centered Artificial Intelligence (HAI) hat nun die Tools der beiden Anbieter LexisNexis und Thomson Reuters (Muttergesellschaft von Westlaw) getestet.

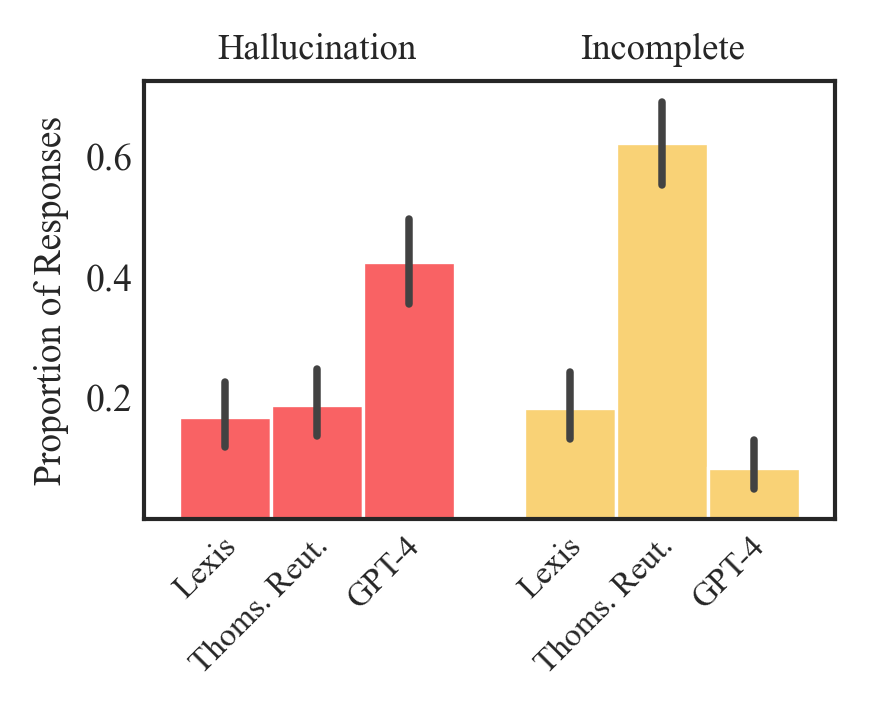

Die Studie zeigt, dass deren KI-Tools im Vergleich zu allgemeinen KI-Modellen wie GPT-4 zwar Fehler reduzieren, aber immer noch in mehr als 17 Prozent der Fälle - also bei jeder sechsten Anfrage - falsche Informationen liefern. Der LLM-Zugriff auf eine Wissensdatenbank (RAG) sei hierfür keine pauschale Abhilfe und zudem ein schwer zu lösendes Problem. Beide getesteten Tools nutzten diesen Mechanismus.

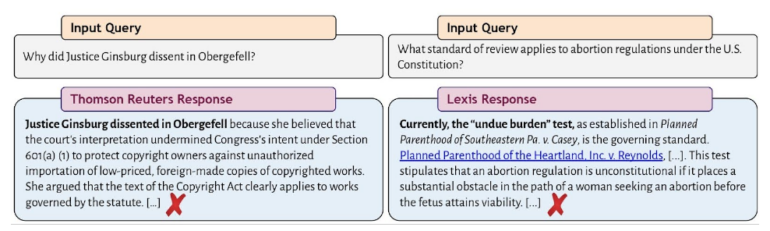

Systeme können auf zwei Arten "halluzinieren": Entweder ist die Antwort einfach falsch, oder sie beschreibt das Recht korrekt, zitiert aber eine Quelle, die ihre Behauptungen nicht stützt.

Letzteres könne noch gefährlicher sein, da die Quelle, obwohl sie existiert, irrelevant oder widersprüchlich sein kann. Nutzer könnten "den Ergebnissen des Tools unangemessenes Vertrauen schenken, was zu falschen rechtlichen Urteilen und Schlussfolgerungen führen könnte", so die Forscher.

Sie identifizieren mehrere Herausforderungen, die speziell für KI-Systeme im Rechtsbereich gelten. Erstens sei es generell schwierig, relevante Quellen zu identifizieren, da Recht nicht nur aus nachprüfbaren Fakten bestehe.

Zweitens könnten die abgerufenen Dokumente aufgrund von Unterschieden zwischen Rechtssystemen und Zeiträumen ungenau sein.

Drittens bestehe die Gefahr, dass KI-Systeme falschen Annahmen der Nutzerinnen und Nutzer zustimmen und diese sich in ihren falschen Annahmen bestätigt fühlen.

Bisher sind mindestens zwei Fälle bekannt geworden, in denen Anwälte ohne Recherche falsche Informationen aus ChatGPT übernommen haben und dafür verurteilt wurden.

Dennoch prognostizierte der Oberste Richter der USA, John Roberts, Anfang des Jahres, dass menschliche Richter zwar weiterhin gebraucht würden, KI aber die Arbeit der Justiz, insbesondere bei Gerichtsverfahren, erheblich beeinflussen werde.

Forscher kritisieren intransparenten Einsatz generativer KI im Rechtswesen

Der Einsatz von KI in der Rechtswissenschaft sei alarmierend intransparent: Die untersuchten Werkzeuge böten keinen systematischen Zugang, veröffentlichten kaum Details zu ihren Modellen und berichteten keinerlei Evaluationsergebnisse.

Diese Intransparenz mache es für Juristen extrem schwierig, KI-Produkte zu erwerben und einzusetzen. Ohne Zugang zu Evaluationen und ohne Transparenz über die Funktionsweise der Tools könnten sie ihrer ethischen und beruflichen Verantwortung nicht gerecht werden.

Rechtsanwälte seien aufgrund der hohen Fehlerquote gezwungen, jede Aussage und jede Quelle, die die KI liefert, zu überprüfen. Dies würde die versprochenen Effizienzgewinne zunichtemachen.

Die Forscher betonen, dass LexisNexis und Thomson Reuters mit dieser Studie keineswegs an den Pranger gestellt werden sollen. Ihre Produkte seien bei Weitem nicht die einzigen KI-Tools für Juristen, die mehr Transparenz benötigten. Eine Vielzahl von Start-ups biete ähnliche Produkte an, die noch weniger zugänglich und damit noch schwieriger zu bewerten seien.

Nach derzeitigem Kenntnisstand seien Halluzinationen bei generativen juristischen KI-Systemen bisher nicht gelöst. Die Rechtspraxis sollte sich daher öffentlichen Benchmarks und rigorosen Bewertungen von KI-Werkzeugen zuwenden, so die Forscher.