Gefälschte Bilder von Trumps Verhaftung läuten endgültig Deepfake-Ära ein

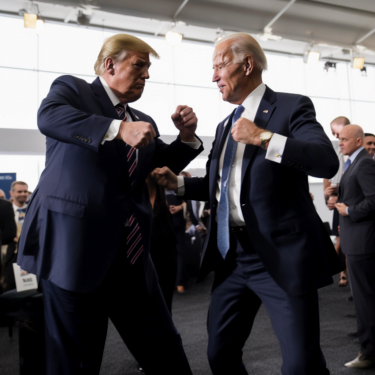

KI-Technologie kann fotorealistische Bilder erzeugen, die kaum von echten Bildern zu unterscheiden sind. Ein Beispiel dafür ist die imaginäre Verhaftung von Donald Trump. Dies wirft erneut die Frage nach der Regulierung von KI-Bildern auf.

Gerade die Veröffentlichung von Midjourney v5 unterstreicht die Risiken von KI-Bildmodellen in sozialen und redaktionellen Medien. Die Ergebnisse des aktuellsten KI-Bildmodells sind noch fotorealistischer als in den Vorgängerversionen. Auch die oft fehlerhafte Darstellung von Händen und Fingern, an der man KI-Generierungen bisher schnell entlarven konnte, ist seit Midjourney v5 deutlich verbessert.

Am Montag, den 20. März, war ein Thema in den sozialen Medien besonders präsent: die mögliche Verhaftung von Ex-US-Präsident Donald Trump. Eliot Higgins, Gründer der niederländischen Investigativ-Organisation Bellingcat, verbrachte seine Zeit damit, diese Szenen mit KI zu visualisieren.

Making pictures of Trump getting arrested while waiting for Trump's arrest. pic.twitter.com/4D2QQfUpLZ

— @eliothiggins.bsky.social (@EliotHiggins) March 20, 2023

Tweet erreichte mehr als fünf Millionen Menschen

"Ich mache Bilder von Trumps Verhaftung, während ich auf Trumps Verhaftung warte", kommentierte er einen Tweet mit zwei von insgesamt 50 generierten Bildern, der zum jetzigen Zeitpunkt weit mehr als fünf Millionen Mal gesehen wurde. Auch andere Medien haben die Bilder aufgegriffen und sorgten so für eine noch größere Reichweite.

Higgins Kommentar, zusammen mit den offensichtlichen Bildfehlern, wie die merkwürdige Darstellung von Beinen, sollte in seinen Augen ausreichen, um zu zeigen, dass die Bilder keine Tatsachen zeigen. "Ich hatte nicht die Absicht, eine intelligente Kritik oder so etwas zu machen. Aber es hat sich irgendwie verselbständigt."

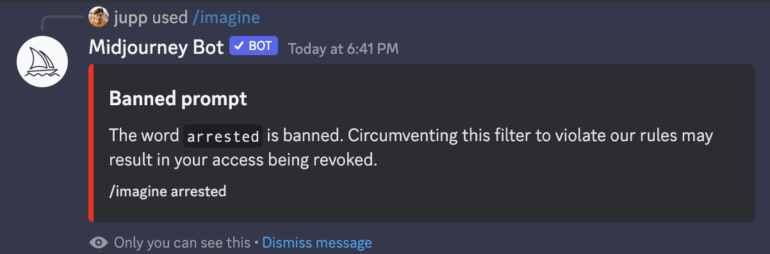

Auf Twitter sind die Bilder immer noch verfügbar - Higgins vermutet jedoch, dass er aufgrund dieses Vorfalls keinen Zugang mehr zu Midjourney hat, über das er die Bilder ursprünglich erstellt hatte. Während Buzzfeed News keine Antwort von Midjourney erhalten hat, ist ein Indiz dafür, dass das Wort "arrested" inzwischen auf die Liste der verbotenen Wörter gesetzt wurde. Jemand bei Midjourney hat den Vorfall bemerkt und reagiert.

Midjourney verbietet politische KI-Bilder nicht explizit

Midjourney verbietet in seinen recht knapp gehaltenen Community Guidelines nur sehr breit gefasst Bilder, die "von Natur aus respektlos, aggressiv oder anderweitig missbräuchlich sind" neben "Erwachseneninhalten oder blutige Szenen". Von explizit politischen Inhalten ist nicht die Rede.

Bislang hat sich Midjourney nicht zu dem Vorfall geäußert und zur Frage, ob etwa eine Verschärfung der Regeln passieren könnte, die etwa die Generierung von politischen Personen ausschließt. Bei eigenen Tests konnten wir etwa problemlos Bilder mit Putin, Trump, Merkel oder Biden erstellen, während "Xi Jinping" gesperrt ist.

Die Sperrung einzelner Prompt-Wörter ist jedenfalls keine nachhaltige Lösung, da sie erst im Nachhinein greift - wie im Fall der Trump-Bilder, die bereits eine enorme Reichweite erzielt haben, wäre der mögliche Schaden dann bereits angerichtet.

Zudem sind im Fall Trump alternative Formulierungen wie "Trump in Handschellen" immer noch möglich, und die generelle Verbannung des Wortes "verhaftet" stößt in der Midjourney-Community auf Kritik, da der Begriff in anderen, legitimen Kontexten verwendet werden kann.

"Nicht, dass es irgendwo in den Metriken auftaucht, aber ich habe gerade meinen 50-Dollar/Monatsvertrag gekündigt, weil ich es dumm finde, dass das Wort "verhaftet" jetzt verboten ist, nachdem die völlig unvermeidlichen Bilder einer gefälschten Verhaftung von Donald Trump auf Twitter in Umlauf gebracht wurden", schreibt ein Nutzer auf Discord.

"Ich bin nicht einverstanden mit der ganzen Donald-Trump-Sache, das ist völlig übertrieben, weil es nicht wirklich ein Verstoß gegen die AGB ist. Es scheint nur, dass sie keine negative PR wollen", schreibt ein anderer.

Mit der zu erwartenden Weiterentwicklung des KI-Fotorealismus dürfte die Kritik an Midjourney und ähnlichen Bildgeneratoren zunehmen, wobei der Damm für Fake-Bilder mit Blick auf Open-Source-Lösungen wie Stable Diffusion ohnehin schon gebrochen sein dürfte.

Es scheint, als würde die Prognose von Ian Goodfellow, dem Erfinder der ursprünglichen Deepfake-Technologie Generative Adversarial Networks (GANs), aus dem Jahr 2017 wahr werden: dass die Menschen Bildern und Videos im Netz nicht mehr vertrauen können. Jetzt muss es nur noch jemand den Menschen sagen.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.