Gen-1: Stable Diffusion Start-up stellt generative KI für Video vor

Mit dem Gen-1-Modell von Runway können bestehende Videos per Textbefehl visuell bearbeitet werden.

Im vergangenen Jahr startete das New Yorker KI-Videoeditor Start-up Runway zusammen mit Stability AI, der LMU München, Eleuther AI und Laion die Open Source Bild-KI Stable Diffusion.

Jetzt zeigt es ein neues Modell: "Gen-1" kann bestehende Videos visuell in neue verwandeln. Aus einer realistisch gefilmten Bahn-Tür wird per Textbefehl eine Tür in Cartoon-Optik.

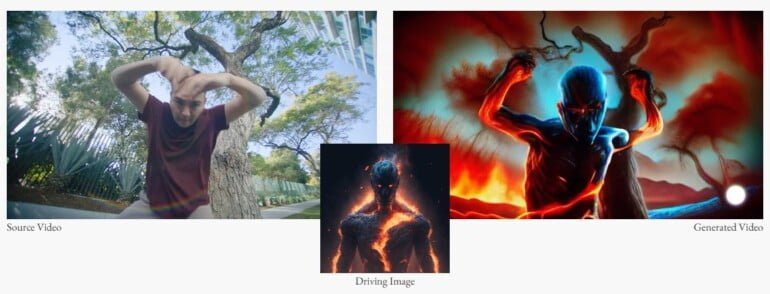

Aus einem Schauspieler in einem Video wird ein Comic-Superheld. Seine Verwandlung erfolgt anhand eines eingegebenen Bildes. Das Modell kann für bessere Transformationen mit eigenen Bildern verfeinert werden.

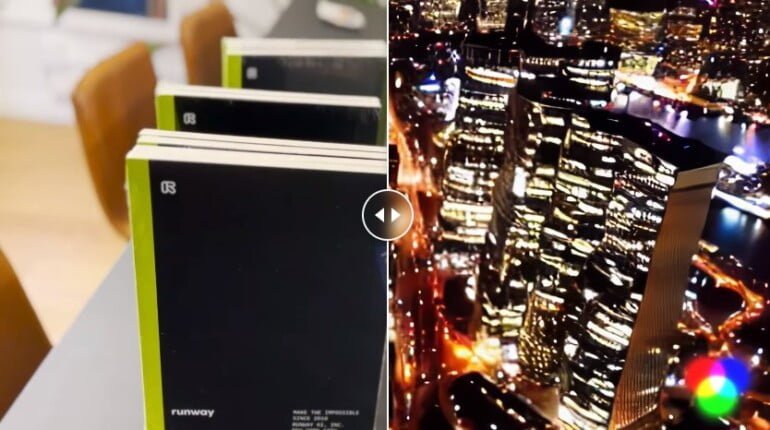

Die Abstraktionsebene führt noch eine Ebene weiter: Aus ein paar lose zusammengestellten Notizbüchern kann Gen-1 per Textbefehl eine Großstadtkulisse mit Wolkenkratzern rendern. "Es ist, als würde man etwas Neues filmen, ohne überhaupt etwas zu filmen", schreibt Runway.

Gen-1 kann zudem Objekte in Videos isolieren und verändern, sodass aus einem Golden Retriever ein Dalmatiner wird, und Texturen auf untexturierte 3D-Objekte anwenden. Auch die Texturen werden per Textbefehl erzeugt.

Runway erwartet rasche Fortschritte bei der KI-Videobearbeitung

Mit KI bearbeitete Videos können noch nicht mit professionell bearbeiteten Videos mithalten. Sie enthalten Bildfehler, schiefe Geometrien oder wirken schlicht unecht, unwirklich. Doch das Projekt steckt noch in den Kinderschuhen.

"KI-Systeme für die Bild- und Videosynthese werden immer präziser, realistischer und kontrollierbarer", schreibt das Start-up.

Video: Runway

Betrachtet man die enormen Fortschritte, die bilderzeugende KI-Systeme in den vergangenen Jahren gemacht haben, braucht es wenig Fantasie, um sich vorzustellen, dass Systeme wie Gen-1 in einigen Jahren eine wichtige Rolle in der Videobearbeitung spielen könnten.

Offene Open-Source-Frage

Stable Diffusion erlangte insbesondere dadurch Bekanntheit, dass es als Open Source im Netz frei verfügbar ist. Wer sich ein wenig mit Computern auskennt und zudem gerne Software konfiguriert, erhält damit eine kostenlose und unzensierte Alternative zu DALL-E 2 oder Midjourney, die auch für Apps genutzt werden kann.

Laut Ian Sansavera, dem Video-Workflow-Architekten von Runway, hat das Start-up bei Gen-1 noch keine Entscheidung in der Open-Source-Frage getroffen. Die Software befinde sich noch am "Tag Null". Interessenten können sich hier auf eine Warteliste setzen lassen, das wissenschaftliche Paper soll demnächst veröffentlicht werden. Weiterführende Informationen gibt es auf der Projektseite.

Runway wird das Modell voraussichtlich in erster Linie für seine eigene Videosoftware entwickeln. Das Start-up ist auf einen KI-gestützten Videoeditor spezialisiert, der die Videobearbeitung durch KI-Tools vereinfachen und automatisieren soll. Im Herbst 2022 zeigte das Start-up eine Integration von Stable Diffusion in das eigene Toolkit. Runway wurde Anfang 2018 gegründet und hat seitdem rund 100 Millionen US-Dollar von Investoren eingesammelt.

Neben Runway arbeitet Google an Text-zu-Video-KI-Systemen, die Videos bearbeiten und von Grund auf generieren können. Dreamix ist dabei speziell auf die Videobearbeitung per Textbefehl spezialisiert. Auch Meta stellte schon ein Text-zu-Video-Modell vor.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.