GET3D: Nvidia Open-Source-KI generiert 3D-Modelle aus 2D-Bildern

Nvidias neues KI-Modell GET3D soll die Erstellung von 3D-Inhalten beschleunigen. Das Modell gibt anhand von 2D-Fotos texturierte 3D-Polygonnetze aus, die nahtlos in Standard-Grafik-Engines verwendet werden können.

GET3D steht für "Generate Explicit Textured 3D" und ist ein generatives 3D-Modell, das hochwertige 3D-Polygonnetze mit beliebiger Topologie synthetisieren kann. Als Input für die Generierung reicht ein einzelnes 2D-Bild.

Die generierten Polygonnetze bestehen aus texturierten Dreiecken - ein Standardformat, das den nahtlosen Import in 3D-Programme, Spiele-Engines oder Film-Renderer ermöglicht.

Die 3D-Objekte sind nach dem Import vollständig bearbeitbar, können etwa skaliert, rotiert und ausgeleuchtet werden. In Kombination mit Nvidias StyleGAN-Nada können Entwickelnde rein per Textbefehl die Form oder Textur des 3D-Modells weiter verändern, etwa ein herkömmliches Auto in ein Polizeiauto verwandeln.

3D-Modell-Generierung anhand synthetischer 2D-Bilder

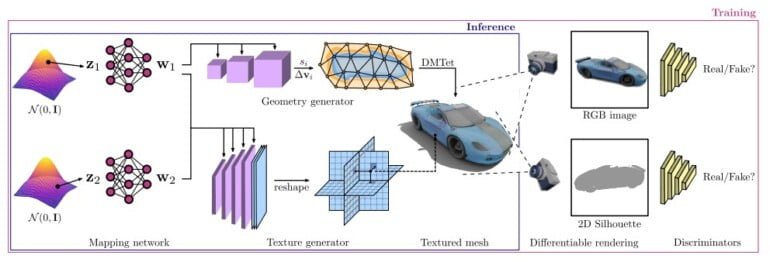

Nvidias Forschungsteam entwickelte einen zweistufigen Generierungsprozess: Der Geometriezweig generiert das Polygonnetz mit beliebiger Topologie. Der Texturzweig erzeugt ein Texturfeld, das an den Oberflächenpunkten des Poylgonnetzes Farben und etwa bestimmte Materialien darstellen kann.

Wie bei GA-Netzen beurteilen abschließend Diskriminatoren anhand synthetischer Fotos des 3D-Modells die Qualität des Outputs und optimieren diesen kontinuierlich passend zum Zielbild.

Trainiert wurde GET3D mit etwa einer Million synthetischer 2D-Bilder von 3D-Modellen aus verschiedenen Perspektiven. Das Training dauerte laut Nvidia rund zwei Tage auf Nvidia A100 GPUs.

Schneller zu mehr 3D-Content

Die von GET3D generierbaren 3D-Modelle sind an die Trainingsdaten gekoppelt: Trainiert man das System etwa mit Auto- oder Tierbildern, kann es 3D-Autos oder -Tiere erzeugen. Je größer und variantenreicher der Trainingsdatensatz ist, desto detaillierter und abwechslungsreicher sind die generierten 3D-Modelle.

Auf einer einzelnen handelsüblichen Nvidia GPU kann das Modell nach dem Training rund 20 Formen pro Sekunde erzeugen, die sich zu einem 3D-Modell zusammensetzen. Die Generierung erfolgt lokal auf dem eigenen Rechner, was sie unabhängig macht von inhaltlichen Restriktionen, wie man sie von Cloud-KI-Services kennt.

"GET3D bringt uns der Demokratisierung der KI-gestützten Erstellung von 3D-Inhalten einen Schritt näher", sagt Sanja Fidler, Leiterin von Nvidias Forschungslabor in Toronto. Dort wurde das Tool entwickelt.

Eine Einschränkung von GET3D ist laut Nvidias Forschungsteam, dass das Training derzeit nur mit 2D-Silhouetten synthetischer Bilder aus bekannten Kamerapositionen möglich ist. Für zukünftige Versionen könnten Fortschritte bei der Kamerapositionsschätzung die Grundlage für das Training mit realen Aufnahmen sein.

Derzeit würde GET3D zudem nur pro Kategorie trainiert. Ein kategorieübergeifendes Modell könne die Vielfalt der generierten 3D-Modelle erhöhen und würde die Flexibilität des Systems verbessern.

Als Open-Source-Modell ist GET3D kostenlos bei Github verfügbar.

Mehr zum Thema Künstliche Intelligenz für Computergrafik gibt’s in unserem DEEP MINDS KI-Podcast mit Thomas Müller von Nvidia.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.