Google Gemini mit Vision startet: Live Bild- und Videoanalyse mit KI

Update vom 7. April 2025:

Die im März angekündigte Kamera- und Bildschirmfreigabe für Gemini Live steht ab sofort zur Verfügung. Laut Google erhalten zunächst Gemini-Advanced-Abonnenten mit kompatiblen Android-Geräten Zugriff auf die neue Funktion. Zudem rollt Google das Update für alle Nutzerinnen und Nutzer der Gemini-App auf Pixel-9- sowie Samsung-S25-Smartphones aus.

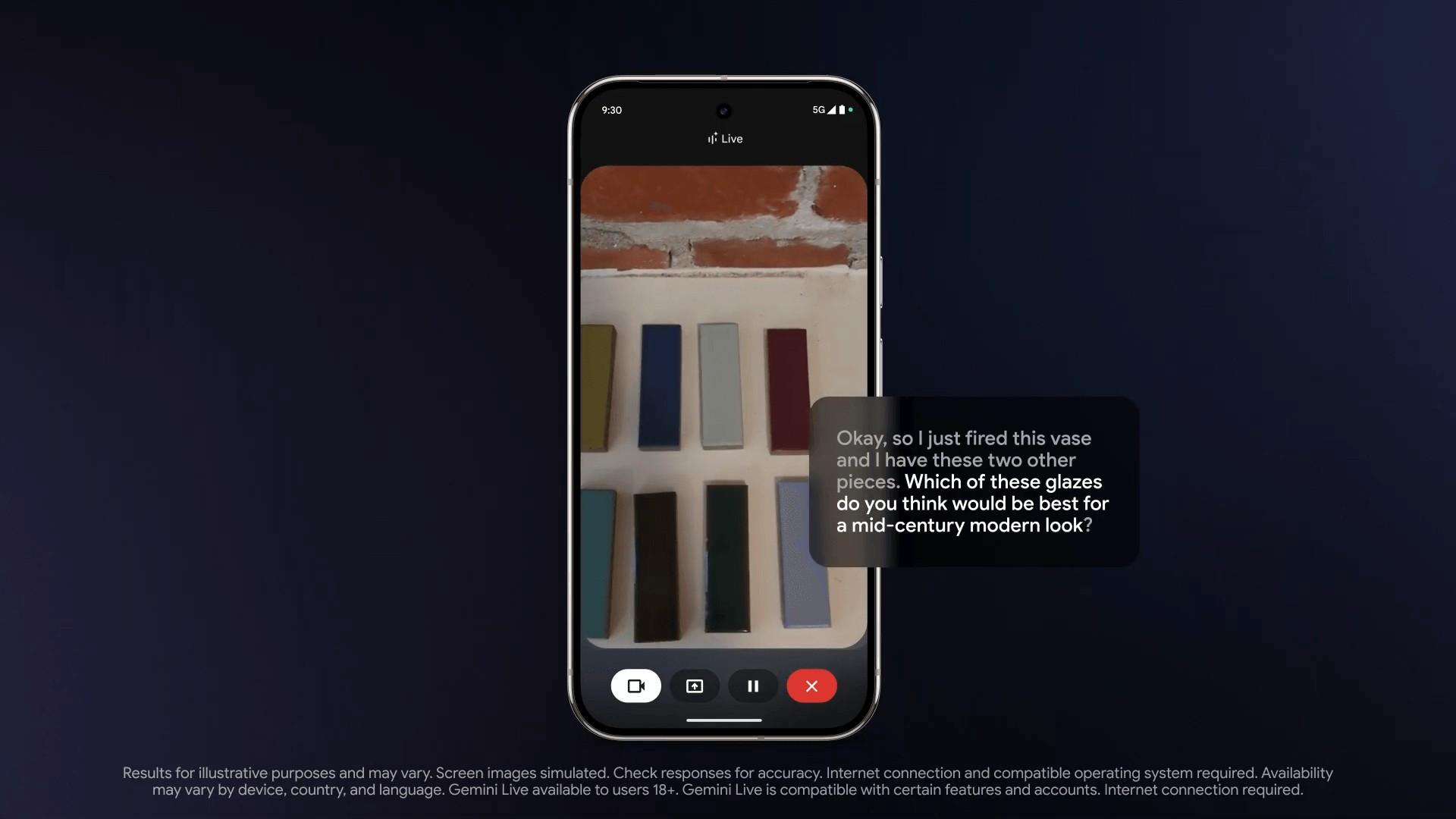

Mit der neuen Funktion sollen Anwender visuelle Inhalte auf ihrem Smartphone-Display oder vor der Kamera in Echtzeit mit Gemini besprechen können. Als mögliche Anwendungsfälle nennt Google etwa Stylingtipps, technischen Support oder kreative Beratung beim Einrichten. Das folgende Beispiel zeigt den Einsatz von Gemini Live, um einen Fehler an einem Google Nest Gerät zu finden.

Ursprünglicher Artikel vom 3. März 2025:

Google Gemini mit Vision soll im März starten: Live-Videoanalyse per KI

Google bringt Live-Videoanalyse für seinen Gemini-Assistenten. Das gab das Unternehmen im Rahmen des Mobile World Congress bekannt.

Google stellt auf dem Mobile World Congress (MWC) in Barcelona KI-Funktionen für seinen Gemini-Assistenten vor. Wie das Unternehmen bekannt gab, werden Abonnenten des Google One AI Premium Plans für Gemini Advanced noch in diesem Monat Zugriff auf Live-Video- und Screen-Sharing-Funktionen erhalten.

Gemini Live erhält zwei wesentliche Neuerungen: Zum einen die Möglichkeit, Live-Videos zu analysieren, zum anderen eine Screen-Sharing-Funktion. Mit beiden Funktionen können Nutzerinnen und Nutzer visuelle Inhalte in Echtzeit mit dem KI-Assistenten teilen - bei Live-Video über Kamerabilder von außen, bei Screen-Sharing über den eigenen Smartphone-Bildschirm, um Inhalte darauf kommentieren zu lassen.

Die neuen Funktionen sind zunächst nur für Android-Geräte verfügbar und unterstützen mehrere Sprachen. Auf dem MWC zeigt Google die Integration dieser Funktionen auf Partnergeräten verschiedener Android-Hersteller.

KI-Assistenten kommen in der echten Welt an

Die Erweiterung um visuelle Funktionen ist ein wichtiger Schritt in der Entwicklung von KI-Assistenten, die zunehmend multimodal agieren und mit der realen Welt interagieren sollen.

Googles Ziel für 2025 ist "Project Astra", ein universeller multimodaler KI-Assistent, der Text-, Video- und Audiodaten in Echtzeit verarbeiten und in einem Gesprächskontext von bis zu zehn Minuten speichern kann. Astra soll auch Google Search, Lens und Maps nutzen können.

Es ist nicht bekannt, ob Google tatsächlich die Veröffentlichung von Astra plant oder, was wahrscheinlicher erscheint, ob die für Astra vorgestellten Funktionen in Gemini integriert werden.

Mit Gemini Live positioniert sich Google gegen den Konkurrenten OpenAI und dessen ChatGPT: Der Advanced Voice Mode von ChatGPT unterstützt seit Dezember Live- und Screen-Sharing.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.