Google lässt Künstliche Intelligenz Wale beobachten

Google hat eine Künstliche Intelligenz vorgestellt, die Buckelwalrufe in akustischen Unterwasseraufnahmen erkennt.

Google hat die Walsuch-KI als Teil seines "AI for Social Good" Programms in Partnerschaft mit der "U.S. National Oceanic and Atmospheric Administration" (NOAA) entwickelt. Die NOAA sammelt seit 2005 an zwölf Standorten im Pazifik akustische Daten.

Sogenannte Hydrophone arbeiten Tag und Nacht und zeichnen die Rufe der Meeressäuger über große Entfernung und in tiefster Tiefe auf. Besonders in abgelegenen Regionen der Meere können die Buckelwale so beobachtet werden, ohne dass Wissenschaftler vor Ort sein müssen.

Große Datenmengen rückwirkend verstehen

Anhand der Audiodaten können die Forscher Rückschlüsse über Anwesenheit, saisonales und tägliches Verhalten und Populationsdichte der Meeressäuger ziehen.

Die historischen Daten zeigen zudem mögliche Veränderungen der Ausbreitung der Tiere im Laufe der Zeit. So können die Forscher durch den Menschen verursachte Populationsveränderungen untersuchen.

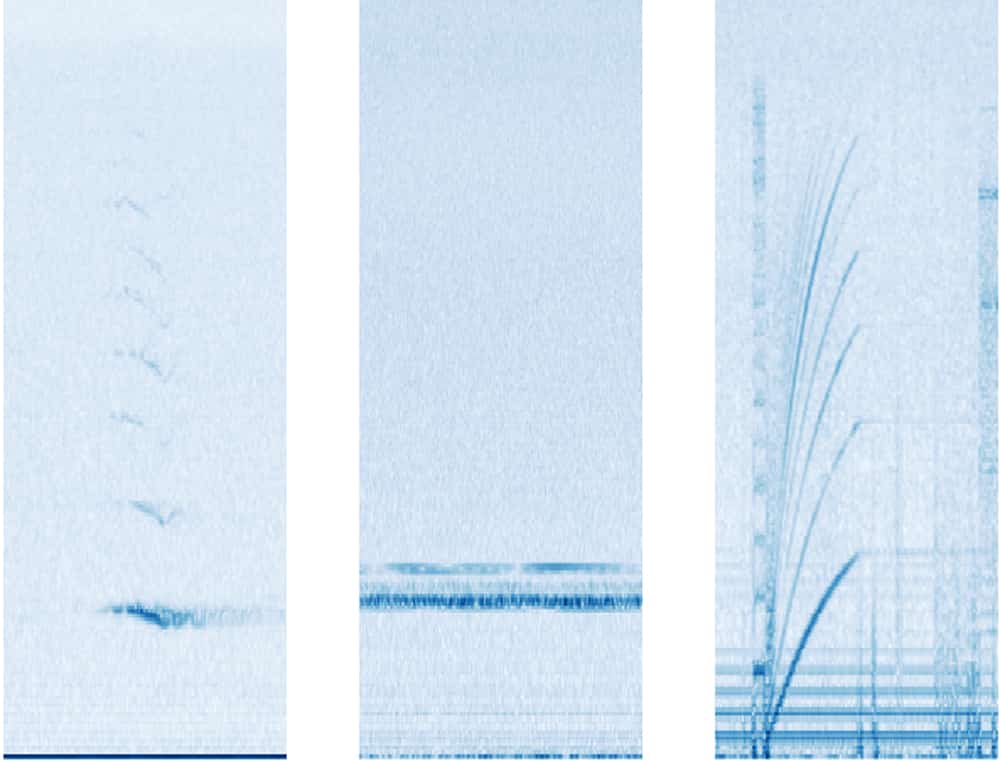

Bisherige Verfahren zur manuellen Markierung von Buckelwalrufen in den Audiodaten sind sehr zeitaufwendig. Doch Googles KI muss nicht wie der Mensch zuhören: Sie untersucht Bilder statt Töne, indem sie sogenannte Spektrogramme analysiert. Das sind graphische Darstellungen der Audioaufnahmen. In diesen Spektrogrammen kann sie Buckelwalrufe mittels Bildanalyse erkennen.

Bildmodell analysiert Audioaufnahmen

Die Forscher trainierten das Bildmodell ResNet-50. Es wird üblicherweise für Bildklassifizierungen verwendet und eignet sich laut der Forscher besonders für die Klassifizierung von Spektrogrammen.

Vor dem Training sortierten die Forscher manuell 0,2 Prozent der Audiodateien vor, in denen Buckelwalrufe im Spektrogramm visuell erkennbar waren. Anhand dieses Datensatzes lernte die KI dann, wie die Rufe aussehen.

Nach dem Training konnte die KI Buckelwalrufe mit einer Genauigkeit von über 90 Prozent erkennen. In der Analyse der Testdaten spiegelte sich die saisonale Wanderbewegung der Buckelwale wieder.

Die Forscher sehen das als Hinweis, dass die KI erfolgreich arbeitet. Sie soll jetzt auf den gesamten Datensatz angesetzt werden. Die Forscher erhoffen sich so tiefere Einblicke in das Leben der Buckelwale und rückwirkend über ihren Werdegang der letzten 15 Jahre.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.