Mit der Skalierung von Sprachmodellen entstehen vereinzelt neue Fähigkeiten, die nicht in kleineren Modellen vorkommen. Eine Forschungsarbeit untersucht diesen Effekt.

In verschiedenen Disziplinen wie der Philosophie, den klassischen Naturwissenschaften, der Kognitionswissenschaft, der Systemtheorie oder auch der Kunst spricht man von Emergenz, wenn ein Untersuchungsobjekt Eigenschaften aufweist, die seine einzelnen Elemente allein nicht besitzen. Das sind etwa Verhaltensweisen oder Fähigkeiten, die erst durch die Interaktion der einzelnen Teile entstehen.

Der Begriff stammt vom lateinischen emergere, ein Wort, das mit „Auftauchen“, „Herauskommen“, oder „Emporsteigen“ übersetzt wird. Einige Theorien halten etwa das Bewusstsein für eine emergente Eigenschaft biologischer Gehirne. Ein Beispiel für Emergenz in physikalischen Systemen ist die Entstehung komplexer, symmetrischer und fraktaler Muster in Schneeflocken.

Große Sprachmodelle weisen emergente Fähigkeiten auf

Große Sprachmodelle wie OpenAIs GPT-3 haben die maschinelle Verarbeitung natürlicher Sprache (NLP) in den letzten Jahren bestimmt und große Leistungssprünge ermöglicht. Dabei zeigte sich, dass die Skalierung der Sprachmodelle - also etwa mehr Trainingsdaten und größere Modelle - zu einer besseren Leistung in NLP-Aufgaben führte. Mit Untersuchungen zu Skalierungsgesetzen konnten Forschende in vielen Fällen die Auswirkung der Skalierung auf die Leistung systematisch vorhersagen.

Doch mit der Skalierung kam auch die Erkenntnis, dass für bestimmte Aufgaben die Leistung der Modelle nicht kontinuierlich mit der Skalierung steigt. Beobachtete Leistungssprünge für solche Aufgaben können daher nicht immer im Voraus vorhergesagt werden. Im Gegenteil finden sich in große Sprachmodellen Fähigkeiten, die in kleineren Modellen nicht auftauchen.

Eine neue Arbeit von Forschenden von Google Research, Stanford University, UNC Chapel Hill und Deepmind untersucht nun diese emergenten Fähigkeiten in großen Sprachmodellen.

Forschende untersuchen unvorhersehbares Phänomen emergenter Fähigkeiten

Zu diesen emergenten Fähigkeiten zählt laut des Teams etwa die Möglichkeit, Ausgaben des Sprachmodells mit Few-Shot-Prompting zu steuern oder sehr simple mathematische Berechnungen wie Addition und Subtraktion mit drei oder Multiplikation mit zwei Ziffern durchzuführen.

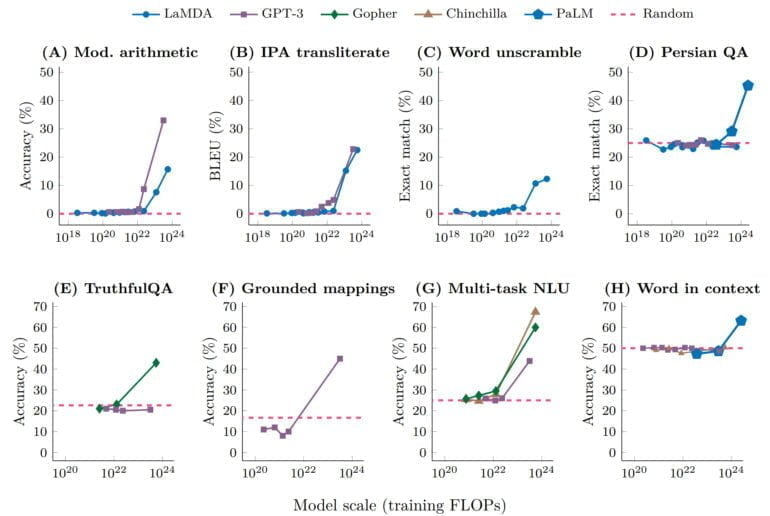

In diesen und anderen Fällen kann gezeigt werden, dass bei einer Visualisierung über eine Skalierungskurve die Leistung zu Beginn nahezu zufällig ist und ab einem bestimmten kritischen Schwellenwert der Modellskala die Leistung deutlich über den Zufallswert springt.

Diese qualitative Veränderung wird auch als Phasenübergang bezeichnet: Eine dramatische Veränderung im Gesamtverhalten, die bei der Untersuchung des Systems im kleineren Maßstab nicht vorhersehbar gewesen wäre.

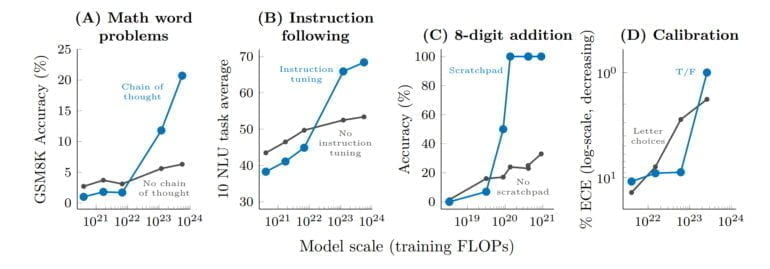

Abseits des Few-Shot-Prompting gibt es weitere Prompting- und Feintuning-Strategien, die die Fähigkeiten großer Sprachmodelle verbessern. Ein Beispiel ist etwa Chain-of-Thought-Prompting, das Schlussfolgerungen zuverlässiger durchführt.

Die Forschenden beobachten bei einigen dieser Methoden ebenfalls emergente Effekte: Bei kleineren Modellen bleibt die Leistung trotz des Einsatzes einer Methode gleich oder verschlechtert sich sogar. Erst bei größeren Modellen führen die Methoden zu Leistungssprüngen.

Fazit: Emergente Fähigkeiten bleiben vorerst unerklärt

In ihrer Arbeit beziehen sich die Forschenden zudem auf unterschiedliche Erklärungen für das Phänomen emergenter Fähigkeiten in großen Sprachmodellen. Sie kommen jedoch zu dem Schluss, dass dieses noch nicht abschließend erklärt werden könne.

Neben der Skalierung der Modellgröße und der Datenmengen könnten in manchen Fällen auch kleinere Modelle mit neuen Architekturen, qualitativ besseren Daten oder verbessertem Trainingsvorgehen ähnliche Fähigkeiten entwickeln. Skalierung allein sei also nicht der einzige Faktor, der eine emergente Fähigkeit erschließe.

In vielen Fällen sei es erst die Skalierung, die zeige, dass solche emergenten Fähigkeiten möglich seien. So habe etwa das 175 Milliarden große GPT-3-Modell im One-Shot-Prompting keine über dem Zufall liegende Performance gezeigt. Manche Forschenden vermuteten die von GPT-3 genutzte Modellarchitektur und das Trainingsziel als Ursache. Später habe jedoch das 540 Milliarden Parameter große PaLM gezeigt, dass Skalierung allein tatsächlich ausreichen kann, um bei dieser Aufgabe eine überdurchschnittliche Leistung zu erzielen.

Das Auftreten emergenter Fähigkeiten werfe daher die Frage auf, ob weitere Skalierung größere Sprachmodelle mit neuen emergenten Fähigkeiten ermögliche. So gebe es etwa im BIG-Bench Benchmark für NLP dutzende Aufgaben, die noch kein großes Sprachmodell geknackt habe - viele davon beinhalten abstraktes Schlussfolgern, etwa Schach oder fortschrittliche Mathematik.

Das Team sieht daher folgende Punkte als relevant für zukünftige Forschung:

- weitere Modellskalierung

- verbesserte Modellarchitekturen und Training

- Skalierung der Daten

- bessere Techniken für Prompting und besseres Verständnis von Prompting

- Aufgaben an der Grenze der Fähigkeit aktueller Sprachmodelle

- Verstehen der Emergenz

Wir haben emergente Fähigkeiten von Sprachmodellen erörtert, für die bisher nur über einer bestimmten Rechenleistungs-Skala sinnvolle Leistungen beobachtet wurden. Emergente Fähigkeiten können eine Vielzahl von Sprachmodellen, Aufgabentypen und experimentellen Szenarien umfassen. Solche Fähigkeiten sind ein kürzlich entdecktes Ergebnis der Skalierung von Sprachmodellen, und die Fragen, wie sie entstehen und ob eine weitere Skalierung weitere emergente Fähigkeiten ermöglichen wird scheinen wichtige zukünftige Forschungsrichtungen für den Bereich des NLP zu sein.

Aus dem Paper